Die Videogenerierungstechnologie hat in den letzten Jahren erhebliche Fortschritte erzielt, aber vorhandene Modelle haben immer noch Einschränkungen bei der Erfassung komplexer Bewegung und physikalischer Phänomene. Das Forschungsteam von Meta schlug das Videojam-Framework vor, um die Bewegungsexpression von Videogenerierungsmodellen durch gemeinsame Darstellung von Aussehen zu verbessern.

Im Bereich der Videogenerierung haben vorhandene generative Modelle trotz erheblicher Fortschritte in den letzten Jahren immer noch Schwierigkeiten, komplexe Bewegung, dynamische und physikalische Phänomene in der Realität zu erfassen. Diese Einschränkung stammt hauptsächlich aus den traditionellen Pixel -Rekonstruktionszielen, die dazu neigen, den Realismus des Aussehens zu verbessern und die Konsistenz der Bewegung zu ignorieren.

Um dieses Problem anzugehen, schlug das Forschungsteam von Meta ein neues Framework namens Videojam vor, das darauf abzielt, effektive Bewegungspräparate in Videogenerierende Modelle zu verleihen, indem Modelle ermutigt, gemeinsame Darstellungen von Aussehensbewegungen zu lernen.

Das Videojam -Framework enthält zwei komplementäre Einheiten. Während der Trainingsphase erweitert das Rahmen das Ziel, sowohl die erzeugten Pixel als auch die entsprechende Bewegung sowohl aus einer einzigen Lernrepräsentation vorherzusagen.

Während der Argumentationsphase führte das Forschungsteam einen Mechanismus ein, der als "intrinsische Führung" bezeichnet wird, der den Erzeugungsprozess in Richtung einer konsistenten Bewegungsrichtung führt, indem sie die eigene sich entwickelnde Bewegungsvorhersage des Modells als dynamisches Leitsignal nutzte. Es ist erwähnenswert, dass Videojam auf jedes Videogenerierungsmodell angewendet werden kann, ohne die Trainingsdaten zu ändern oder das Modell zu erweitern.

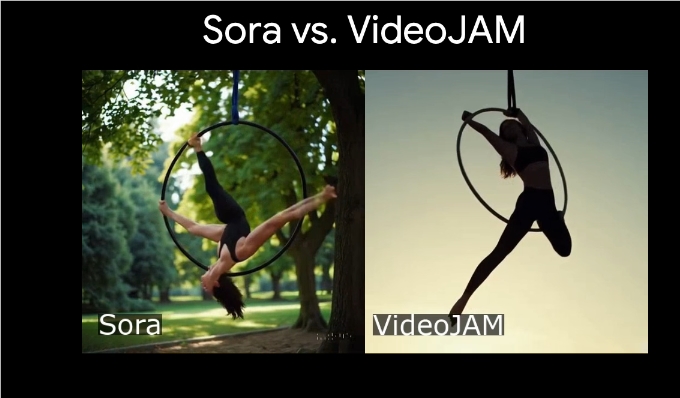

Videojam hat sich als branchenführende Konsistenz in Bewegung erwiesen und über mehrere wettbewerbsfähige proprietäre Modelle hinausgeht und gleichzeitig die visuelle Qualität der generierten Bilder verbessert. Diese Studieergebnisse betonen die komplementäre Beziehung zwischen Aussehen und Bewegung, die den visuellen Effekt und die Bewegungskohärenz der Videoerzeugung erheblich verbessern kann, wenn die beiden effektiv kombiniert werden.

Darüber hinaus zeigte das Forschungsteam die hervorragende Leistung von Videojam-30b bei der Generation komplexer Sportarten, einschließlich Szenen wie Skateboardern Sprung- und Balletttänzer, die sich am See drehen. Durch den Vergleich des Bibase-Modells DIT-30B ergab die Studie, dass Videojam die Qualität der Bewegungsgenerierung erheblich verbessert hat.

Projekteingang: https://hila-chefer.github.io/videojam-paper.github.io/

Schlüsselpunkte:

Videojam Framework verbessert die Bewegungsexpression von Modellen der Videogenerierung durch gemeinsame Darstellung von Aussehen.

Während des Trainings kann Videojam Pixel und Bewegungen gleichzeitig vorhersagen, wodurch die Konsistenz generierter Inhalte verbessert wird.

Es wurde nachgewiesen, dass Videojam mehrere Wettbewerbsmodelle sowohl in der Bewegungskonsistenz als auch in der visuellen Qualität übertrifft.

Das Videojam -Framework von Meta hat durch das kombinierte Erscheinungsbild und die Bewegungsdarstellung neue Durchbrüche in die Videogenerierung gebracht. Er hat die Bewegungskonsistenz und die visuelle Qualität generierter Videos erheblich verbessert und eine neue Richtung für die zukünftige Entwicklung der Videogenerierungstechnologie darstellt.