Forschungsteams der Stanford University und der University of Washington haben kürzlich eine bahnbrechende KI-Trainingsmethode namens S1 veröffentlicht. Im Gegensatz zum Verlassen der früheren Rechenleistung oder komplexen Algorithmen erreicht die S1 -Methode geschickt einen Leistungssprung, indem die Zuordnung von Rechenressourcen des Modells während des Tests gesteuert wird.

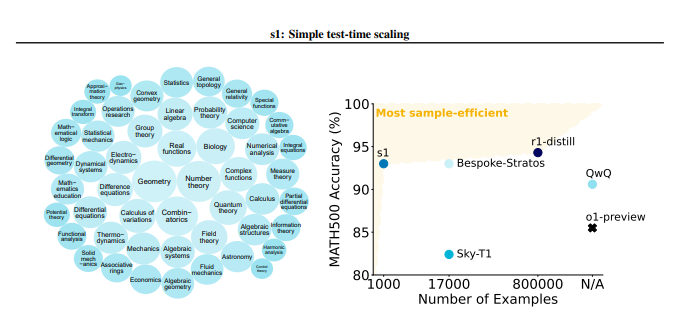

Die S1-Methode konstruierte zunächst sorgfältig einen kleinen Datensatz namens S1K, der 1000 hochwertige Inferenzprobleme enthielt. Die Screening -Standards dieses Datensatzes sind sehr streng und müssen gleichzeitig die drei Bedingungen von hoher Schwierigkeit, starker Vielfalt und hervorragender Qualität erfüllen. Das Forschungsteam überprüfte die Bedeutung dieser drei Kriterien durch detaillierte Ablationsexperimente, und die Ergebnisse zeigten, dass eine zufällige Selektion oder die Fokussierung auf ein einzelnes Kriterium zu einem signifikanten Leistungsrückgang führen würden. Es ist erwähnenswert, dass selbst wenn sie mit einem Superset mit 59.000 Proben trainiert wird, sein Effekt weitaus geringer ist als die von sorgfältig ausgewählten 1000 Proben, was die Kritikalität der Datenauswahl hervorhebt.

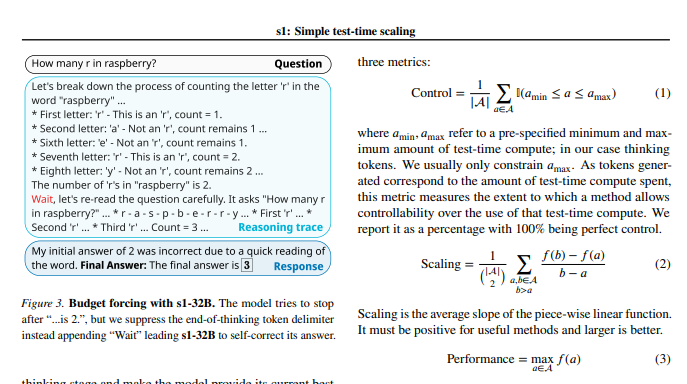

Nach Abschluss des Modelltrainings verwendeten die Forscher eine Technik namens "Budget Obligatorisch", um die Anzahl der Berechnungen während der Tests zu kontrollieren. Einfach ausgedrückt, diese Methode erweitert die Denkzeit des Modells, indem er den Denkprozess des Modells gewaltsam beendet oder "Wartewartanweisungen" hinzufügt, wodurch das Modell für eingehende Erkundungen und Überprüfungen führt. Auf diese Weise kann das Modell die Inferenzschritte wiederholt überprüfen und die Fehler effektiv korrigieren.

Experimentelle Ergebnisse zeigen, dass mit der Feinabstimmung im S1K-Datensatz und der Unterstützung der "Budget Oblicatory" -Technologie die Leistung des S1-32B-Modells in mathematischen Problemen auf Wettbewerbsebene um bis zu 27%übertroffen hat. Noch überraschender ist, dass das S1-32B-Modell durch "Budget obligatorische" Skalierung auch die Verallgemeinerungsfähigkeit über sein eigenes Trainingsniveau zeigte und seine Punktzahl für den Aime24-Testsatz von 50% auf 57% stieg.

Der Kernbeitrag dieser Studie besteht darin, dass sie eine einfache und effiziente Methode zum Erstellen von Datensätzen mit hohen Inferenzfunktionen und Erreichung der Leistungsskalierung beim Testen bietet. Basierend darauf hat das Forschungsteam das S1-32B-Modell erstellt, dessen Leistung mit dem Modell geschlossene Quellen vergleichbar ist oder sogar übertrifft und gleichzeitig Open Source und hohe Probeneffizienz erreicht. Der Code, das Modell und die Daten für die Studie sind auf GitHub offen.

Die Forscher führten auch eingehende Ablationsexperimente an den Feinheiten der Daten und der Skalierungstechnik während des Tests durch. Auf der Datenseite fanden sie es entscheidend, gleichzeitig Schwierigkeiten, Vielfalt und Qualität zu berücksichtigen. In Bezug auf die Skalierung zur Testzeit zeigt der Ansatz "Budget Oblicatory" hervorragende Kontrollierbarkeit und Leistungsverbesserungen. Die Studie untersucht auch zwei verschiedene Methoden, parallele Skalierung und sequentielle Skalierung, und führt fortschrittliche Technologien wie Rebase ein und liefert wichtige Inspiration für zukünftige Forschungsrichtungen.

Diese Studie bringt nicht nur eine neue kostengünstige und hocheffiziente Idee auf den Bereich des KI-Trainings, sondern legt auch eine solide Grundlage für eine breitere Palette von AI-Anwendungen.

Papieradresse: https://arxiv.org/pdf/2501.19393

Diese Studie zeigt, dass die Inferenzfunktionen von KI-Modellen durch sorgfältige Konstruktions- und Testing-Computing-Ressourcenmanagement erheblich verbessert werden können, was neue Anweisungen für die zukünftige KI-Entwicklung bietet.