เมื่อเร็วๆ นี้ ความนิยมของแอปพลิเคชัน AI large language model (LLM) ได้ผลักดันให้เกิดการแข่งขันที่รุนแรงในด้านฮาร์ดแวร์ AMD ได้เปิดตัวซีรีส์ Strix Point APU ล่าสุด และโปรเซสเซอร์ Ryzen AI แสดงให้เห็นถึงข้อได้เปรียบที่สำคัญในการจัดการงาน LLM ด้วยประสิทธิภาพที่เหนือกว่าซีรีส์ Lunar Lake ของ Intel มาก เครื่องมือแก้ไข Downcodes จะทำให้คุณมีความเข้าใจเชิงลึกเกี่ยวกับประสิทธิภาพของซีรีส์ Strix Point APU และนวัตกรรมทางเทคโนโลยีที่อยู่เบื้องหลัง

เมื่อเร็วๆ นี้ AMD ได้เปิดตัว Strix Point APU ซีรีส์ล่าสุด โดยเน้นย้ำถึงประสิทธิภาพที่โดดเด่นของซีรีส์นี้ในแอปพลิเคชัน AI large language model (LLM) ซึ่งเหนือกว่าโปรเซสเซอร์ซีรีส์ Lunar Lake ของ Intel อย่างมาก เนื่องจากความต้องการปริมาณงาน AI ยังคงเพิ่มขึ้น การแข่งขันด้านฮาร์ดแวร์จึงรุนแรงมากขึ้น เพื่อตอบสนองต่อตลาด AMD ได้เปิดตัวโปรเซสเซอร์ AI ที่ออกแบบมาสำหรับแพลตฟอร์มมือถือ โดยมีเป้าหมายเพื่อประสิทธิภาพที่สูงขึ้นและความหน่วงที่ลดลง

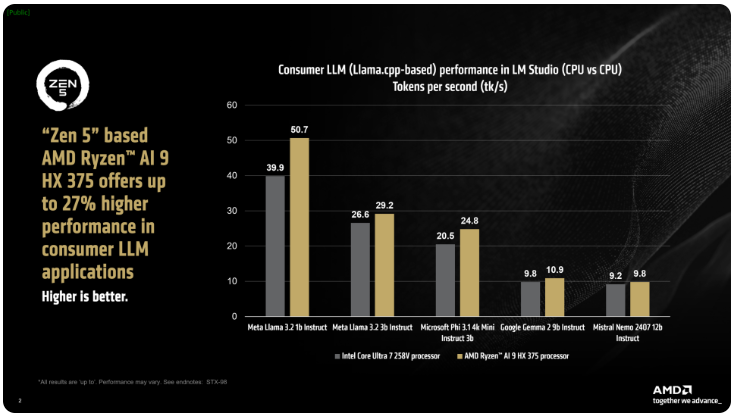

AMD กล่าวว่าโปรเซสเซอร์ Ryzen AI300 ของซีรีส์ ix Point สามารถเพิ่มจำนวนโทเค็นที่ประมวลผลต่อวินาทีได้อย่างมากเมื่อประมวลผลงาน AI LLM เมื่อเทียบกับ Core Ultra258V ของ Intel ประสิทธิภาพของ Ryzen AI9375 ได้รับการปรับปรุงขึ้น 27% แม้ว่า Core Ultra7V จะไม่ใช่รุ่นที่เร็วที่สุดในซีรีส์ L Lake แต่จำนวนคอร์และเธรดนั้นใกล้เคียงกับโปรเซสเซอร์ Lunar Lake ระดับสูง ซึ่งแสดงให้เห็นถึงความสามารถในการแข่งขันของผลิตภัณฑ์ AMD ในด้านนี้

เครื่องมือ LM Studio ของ AMD เป็นแอปพลิเคชันที่เน้นผู้บริโภคเป็นหลักโดยใช้เฟรมเวิร์ก llama.cpp ซึ่งได้รับการออกแบบมาเพื่อทำให้การใช้โมเดลภาษาขนาดใหญ่ง่ายขึ้น เฟรมเวิร์กช่วยเพิ่มประสิทธิภาพการทำงานของซีพียู x86 แม้ว่าไม่จำเป็นต้องใช้ GPU เพื่อรัน LLM แต่การใช้ GPU ก็สามารถเร่งการประมวลผลเพิ่มเติมได้ จากการทดสอบพบว่า Ryzen AI9HX375 สามารถบรรลุเวลาแฝงที่ลดลง 35 เท่าในโมเดล Meta Llama3.21b Instruct ซึ่งประมวลผลโทเค็น 50.7 ต่อวินาที เมื่อเปรียบเทียบกัน Core Ultra7258V มีเพียง 39.9 โทเค็น

ไม่เพียงเท่านั้น Strix Point APU ยังมาพร้อมกับการ์ดกราฟิกในตัว Radeon อันทรงพลังที่ใช้สถาปัตยกรรม RDNA3.5 ซึ่งสามารถถ่ายโอนงานไปยัง iGPU ผ่านทาง ulkan API เพื่อปรับปรุงประสิทธิภาพของ LLM ต่อไป ด้วยการใช้เทคโนโลยีหน่วยความจำกราฟิกแบบแปรผัน (VGM) โปรเซสเซอร์ Ryzen AI300 สามารถเพิ่มประสิทธิภาพการจัดสรรหน่วยความจำ ปรับปรุงประสิทธิภาพการใช้พลังงาน และบรรลุการปรับปรุงประสิทธิภาพได้สูงสุดถึง 60% ในท้ายที่สุด

ในการทดสอบเปรียบเทียบ AMD ใช้การตั้งค่าเดียวกันบนแพลตฟอร์ม Intel AI Playground และพบว่า Ryzen AI9HX375 เร็วกว่า Core Ultra7258V บน Microsoft Phi3.1 ถึง 87% และเร็วกว่า 13% ในรุ่น Mistral7b Instruct0.3 ถึงกระนั้นผลลัพธ์ก็ยังน่าสนใจกว่าเมื่อเปรียบเทียบกับ Core Ultra9288V ซึ่งเป็นเรือธงของซีรีย์ Lunar Lake ในปัจจุบัน AMD กำลังมุ่งเน้นไปที่การใช้โมเดลภาษาขนาดใหญ่ที่ได้รับความนิยมมากขึ้นผ่านทาง LM Studio โดยมีเป้าหมายเพื่อให้ผู้ใช้ที่ไม่ใช่ด้านเทคนิคเริ่มต้นได้ง่ายขึ้น

การเปิดตัวซีรีส์ AMD Strix Point APU ทำให้เกิดการแข่งขันที่รุนแรงยิ่งขึ้นในด้านโปรเซสเซอร์ AI และยังบ่งชี้ว่าแอปพลิเคชัน AI ในอนาคตจะมีการรองรับฮาร์ดแวร์ที่ทรงพลังมากขึ้น การปรับปรุงประสิทธิภาพและประสิทธิภาพการใช้พลังงานจะทำให้ผู้ใช้ได้รับประสบการณ์ AI ที่ราบรื่นและทรงพลังยิ่งขึ้น บรรณาธิการของ Downcodes จะยังคงให้ความสนใจกับการพัฒนาล่าสุดในสาขานี้และนำเสนอรายงานที่น่าตื่นเต้นแก่ผู้อ่านมากขึ้น