ในช่วงไม่กี่ปีที่ผ่านมา ค่าใช้จ่ายในการฝึกอบรมโมเดลภาษาขนาดใหญ่ยังคงอยู่ในระดับสูง ซึ่งกลายเป็นปัจจัยสำคัญที่จำกัดการพัฒนาของ AI วิธีลดต้นทุนการฝึกอบรมและปรับปรุงประสิทธิภาพกลายเป็นจุดสนใจของอุตสาหกรรม บรรณาธิการของ Downcodes นำเสนอการตีความรายงานล่าสุดจากนักวิจัยที่ Harvard University และ Stanford University ในกรณีนี้ ยังสามารถปรับปรุงประสิทธิภาพของโมเดลได้อีกด้วย เรามาดูรายละเอียดการวิจัยที่น่าตื่นเต้นนี้กันดีกว่า

ในด้านปัญญาประดิษฐ์ ขนาดใหญ่ขึ้นดูเหมือนจะหมายถึงความสามารถที่มากขึ้น ในการแสวงหาโมเดลภาษาที่มีประสิทธิภาพยิ่งขึ้น บริษัทเทคโนโลยีรายใหญ่ต่างซ้อนพารามิเตอร์โมเดลและข้อมูลการฝึกอบรมอย่างบ้าคลั่ง เพียงเพื่อพบว่าต้นทุนก็เพิ่มขึ้นเช่นกัน ไม่มีวิธีฝึกอบรมโมเดลภาษาที่คุ้มต้นทุนและมีประสิทธิภาพใช่ไหม

นักวิจัยจากมหาวิทยาลัยฮาร์วาร์ดและสแตนฟอร์ดเพิ่งตีพิมพ์บทความซึ่งพวกเขาพบว่าความแม่นยำของการฝึกโมเดลเป็นเหมือนกุญแจที่ซ่อนอยู่ซึ่งสามารถปลดล็อก "รหัสต้นทุน" ของการฝึกโมเดลภาษาได้

ความแม่นยำของโมเดลคืออะไร พูดง่ายๆ ก็คือหมายถึงพารามิเตอร์ของโมเดลและจำนวนหลักที่ใช้ในกระบวนการคำนวณ โมเดลการเรียนรู้เชิงลึกแบบดั้งเดิมมักจะใช้ตัวเลขทศนิยม 32 บิต (FP32) สำหรับการฝึก แต่ในช่วงไม่กี่ปีที่ผ่านมา ด้วยการพัฒนาฮาร์ดแวร์ จึงมีการใช้ประเภทตัวเลขที่มีความแม่นยำต่ำกว่า เช่น ตัวเลขทศนิยม 16 บิต (FP16) หรือ 8- จำนวนเต็มบิต (INT8) การฝึกอบรมเป็นไปได้แล้ว

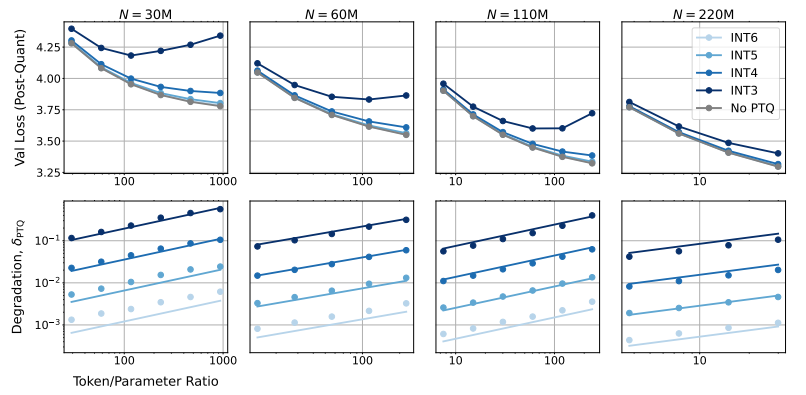

ดังนั้น การลดความแม่นยำของโมเดลจะส่งผลต่อประสิทธิภาพของโมเดลอย่างไร นี่คือคำถามที่บทความนี้ต้องการสำรวจ จากการทดลองจำนวนมาก นักวิจัยได้วิเคราะห์ต้นทุนและการเปลี่ยนแปลงประสิทธิภาพของการฝึกโมเดลและการอนุมานภายใต้ความแม่นยำที่แตกต่างกัน และเสนอชุดกฎการปรับขนาด "การรับรู้ถึงความแม่นยำ" ชุดใหม่

พวกเขาพบว่าการฝึกที่มีความแม่นยำต่ำกว่าจะช่วยลด "จำนวนพารามิเตอร์ที่มีประสิทธิผล" ของแบบจำลองได้อย่างมีประสิทธิภาพ จึงช่วยลดปริมาณการคำนวณที่จำเป็นสำหรับการฝึกอบรม ซึ่งหมายความว่า ด้วยงบประมาณการคำนวณที่เท่ากัน เราสามารถฝึกอบรมโมเดลขนาดใหญ่ขึ้นหรือในระดับเดียวกันได้ การใช้ความแม่นยำที่ต่ำกว่าสามารถประหยัดทรัพยากรการคำนวณได้จำนวนมาก

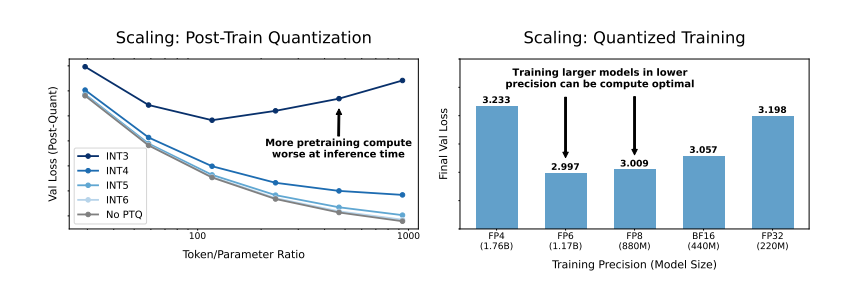

ที่น่าแปลกใจยิ่งกว่านั้นคือ นักวิจัยยังพบว่าในบางกรณี การฝึกที่มีความแม่นยำต่ำกว่าสามารถปรับปรุงประสิทธิภาพของแบบจำลองได้จริง ตัวอย่างเช่น สำหรับผู้ที่ต้องการ "การวัดปริมาณหลังการฝึก" หากแบบจำลองใช้ความแม่นยำต่ำกว่าในระหว่างขั้นตอนการฝึก แบบจำลองจะมีความแข็งแกร่งมากขึ้นในการลดความแม่นยำหลังการหาปริมาณ ดังนั้นจึงแสดงประสิทธิภาพที่ดีขึ้นในระหว่างขั้นตอนการอนุมาน

ดังนั้นเราควรเลือกความแม่นยำแบบใดในการฝึกโมเดล โดยการวิเคราะห์กฎการปรับขนาด นักวิจัยได้ข้อสรุปที่น่าสนใจ:

การฝึกความแม่นยำแบบ 16 บิตแบบดั้งเดิมอาจไม่เหมาะสมที่สุด การวิจัยของพวกเขาชี้ให้เห็นว่าความแม่นยำ 7-8 หลักอาจเป็นตัวเลือกที่คุ้มค่ากว่า

มันไม่ฉลาดเลยที่จะติดตามการฝึกอบรมที่มีความแม่นยำต่ำเป็นพิเศษ (เช่น 4 หลัก) อย่างสุ่มสี่สุ่มห้า เนื่องจากที่ความแม่นยำต่ำมาก จำนวนพารามิเตอร์ที่มีประสิทธิภาพของโมเดลจะลดลงอย่างรวดเร็ว เพื่อรักษาประสิทธิภาพไว้ เราจำเป็นต้องเพิ่มขนาดโมเดลอย่างมาก ซึ่งจะส่งผลให้ต้นทุนการคำนวณสูงขึ้น

ความแม่นยำในการฝึกที่เหมาะสมที่สุดอาจแตกต่างกันไปตามรุ่นที่มีขนาดต่างกัน สำหรับรุ่นที่ต้องใช้ "การฝึกมากเกินไป" มาก เช่น ซีรีส์ Llama-3 และ Gemma-2 การฝึกที่มีความแม่นยำสูงกว่าอาจคุ้มค่ากว่า

งานวิจัยนี้ให้มุมมองใหม่ในการทำความเข้าใจและเพิ่มประสิทธิภาพการฝึกอบรมโมเดลภาษา ข้อความนี้บอกเราว่าการเลือกความแม่นยำนั้นไม่คงที่ แต่จำเป็นต้องชั่งน้ำหนักตามขนาดรุ่นเฉพาะ ปริมาณข้อมูลการฝึกอบรม และสถานการณ์การใช้งาน

แน่นอนว่า การศึกษานี้มีข้อจำกัดบางประการ ตัวอย่างเช่น แบบจำลองที่พวกเขาใช้มีขนาดค่อนข้างเล็ก และผลการทดลองอาจไม่สามารถสรุปได้โดยตรงกับแบบจำลองขนาดใหญ่ นอกจากนี้ พวกเขามุ่งเน้นไปที่ฟังก์ชันการสูญเสียของแบบจำลองเท่านั้น และไม่ได้ประเมินประสิทธิภาพของแบบจำลองในงานดาวน์สตรีม

อย่างไรก็ตาม งานวิจัยนี้ยังคงมีนัยสำคัญ โดยเผยให้เห็นความสัมพันธ์ที่ซับซ้อนระหว่างความแม่นยำของโมเดล ประสิทธิภาพของโมเดล และค่าใช้จ่ายในการฝึกอบรม และให้ข้อมูลเชิงลึกอันมีค่าแก่เราสำหรับการออกแบบและการฝึกโมเดลภาษาที่มีประสิทธิภาพและประหยัดมากขึ้นในอนาคต

บทความ: https://arxiv.org/pdf/2411.04330

โดยรวมแล้ว งานวิจัยนี้ให้แนวคิดและวิธีการใหม่ๆ ในการลดต้นทุนของการฝึกอบรมโมเดลภาษาขนาดใหญ่ และให้ข้อมูลอ้างอิงที่สำคัญสำหรับการพัฒนา AI ในอนาคต บรรณาธิการของ Downcodes มุ่งหวังที่จะมีความก้าวหน้ามากขึ้นในการวิจัยความแม่นยำของแบบจำลอง และมีส่วนช่วยในการสร้างแบบจำลอง AI ที่คุ้มค่ามากขึ้น