บรรณาธิการของ Downcodes ได้เรียนรู้ว่า Ai2 ซึ่งเป็นสถาบันวิจัย AI ที่ไม่แสวงหากำไร เพิ่งเปิดตัวซีรีส์ภาษา OLMo2 ใหม่ ซึ่งเป็นซีรีส์ "Open Language Model" (OLMo) รุ่นที่สอง OLMo2 ยึดมั่นในแนวคิดของโค้ดโอเพ่นซอร์สโดยสมบูรณ์ และข้อมูลการฝึกอบรม เครื่องมือ และโค้ดต่างๆ ของมันก็เปิดกว้างอย่างสมบูรณ์ นี่เป็นสิ่งสำคัญอย่างยิ่งในสาขา AI ในปัจจุบัน และแสดงถึงความสูงใหม่ในการพัฒนา AI แบบโอเพ่นซอร์ส แตกต่างจากรุ่นอื่นๆ ที่อ้างว่าเป็น "เปิด" OLMo2 ปฏิบัติตามคำจำกัดความของ Open Source Initiative อย่างเคร่งครัด ตรงตามมาตรฐานที่เข้มงวดของ AI โอเพ่นซอร์ส และให้การสนับสนุนทางเทคนิคที่แข็งแกร่งและทรัพยากรการเรียนรู้ที่มีคุณค่าแก่ชุมชน AI

Ai2 ซึ่งเป็นองค์กรวิจัย AI ที่ไม่แสวงหากำไร เพิ่งเปิดตัวซีรี่ส์ OLMo2 ใหม่ ซึ่งเป็นรุ่นที่สองของซีรีส์ "Open Language Model" (OLMo) ที่องค์กรเปิดตัว การเปิดตัว OLMo2 ไม่เพียงแต่ให้การสนับสนุนทางเทคนิคที่แข็งแกร่งสำหรับชุมชน AI เท่านั้น แต่ยังแสดงถึงการพัฒนาล่าสุดของ AI โอเพ่นซอร์สด้วยโค้ดโอเพ่นซอร์สที่สมบูรณ์

แตกต่างจากโมเดลภาษา "เปิด" อื่นๆ ที่มีอยู่ในตลาดปัจจุบัน เช่น ซีรีส์ Meta's Llama OLMo2 ตรงตามคำจำกัดความที่เข้มงวดของ Open Source Initiative ซึ่งหมายความว่าข้อมูลการฝึกอบรม เครื่องมือ และโค้ดที่ใช้สำหรับการพัฒนาเป็นแบบสาธารณะและทุกคนสามารถเข้าถึงได้ ใช้. ตามที่กำหนดโดย Open Source Initiative OLMo2 ตรงตามข้อกำหนดขององค์กรสำหรับมาตรฐาน "open source AI" ซึ่งได้รับการสรุปในเดือนตุลาคมปีนี้

Ai2 กล่าวในบล็อกว่าในระหว่างกระบวนการพัฒนา OLMo2 ข้อมูลการฝึกอบรม รหัส แผนการฝึกอบรม วิธีการประเมิน และจุดตรวจสอบระดับกลางทั้งหมดเปิดกว้างโดยสมบูรณ์ โดยมีเป้าหมายเพื่อส่งเสริมนวัตกรรมและการค้นพบในชุมชนโอเพ่นซอร์สผ่านทรัพยากรที่ใช้ร่วมกัน "ด้วยการแบ่งปันข้อมูล โซลูชั่น และการค้นพบของเราอย่างเปิดเผย เราหวังว่าจะมอบทรัพยากรแก่ชุมชนโอเพ่นซอร์สในการค้นพบวิธีการใหม่ ๆ และเทคโนโลยีที่เป็นนวัตกรรมใหม่"

ซีรี่ส์ OLMo2 มีสองเวอร์ชัน: เวอร์ชันหนึ่งคือ OLMo7B ที่มีพารามิเตอร์ 7 พันล้านพารามิเตอร์ และอีกเวอร์ชันคือ OLMo13B ที่มีพารามิเตอร์ 13 พันล้านพารามิเตอร์ จำนวนพารามิเตอร์ส่งผลโดยตรงต่อประสิทธิภาพของโมเดล และเวอร์ชันที่มีพารามิเตอร์มากกว่ามักจะสามารถจัดการงานที่ซับซ้อนมากขึ้นได้ OLMo2 ทำงานได้ดีกับงานข้อความทั่วไป โดยสามารถทำงานต่างๆ ให้เสร็จสิ้นได้ เช่น การตอบคำถาม การสรุปเอกสาร และการเขียนโค้ด

หมายเหตุแหล่งที่มาของรูปภาพ: รูปภาพนี้สร้างขึ้นโดย AI และรูปภาพนั้นได้รับอนุญาตจากผู้ให้บริการ Midjourney

ในการฝึก OLMo2 นั้น Ai2 ใช้ชุดข้อมูลที่มีโทเค็นห้าล้านล้านโทเค็น โทเค็นเป็นหน่วยที่เล็กที่สุดในโมเดลภาษา 1 ล้านโทเค็นมีค่าประมาณ 750,000 คำ ข้อมูลการฝึกอบรมประกอบด้วยเนื้อหาจากเว็บไซต์คุณภาพสูง เอกสารทางวิชาการ กระดานสนทนาถามตอบ และสมุดงานคณิตศาสตร์สังเคราะห์ และได้รับการคัดเลือกอย่างรอบคอบเพื่อให้มั่นใจถึงประสิทธิภาพและความแม่นยำของแบบจำลอง

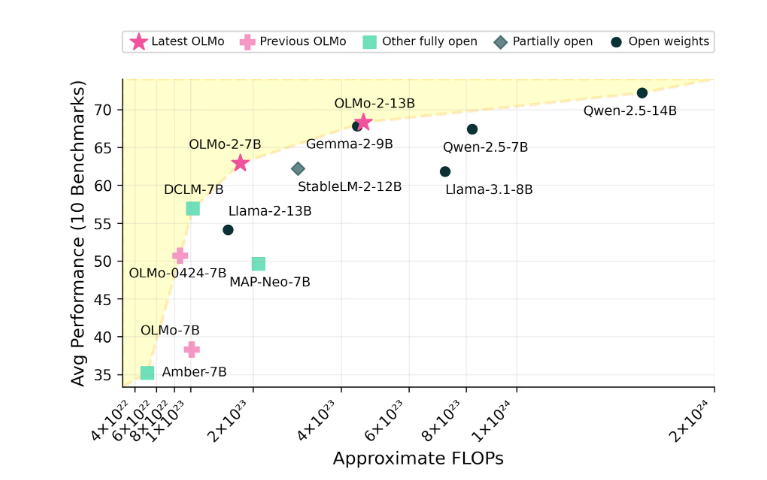

Ai2 มั่นใจในประสิทธิภาพของ OLMo2 โดยอ้างว่าสามารถแข่งขันกับโมเดลโอเพ่นซอร์สเช่น Meta's Llama3.1 ในด้านประสิทธิภาพ Ai2 ชี้ให้เห็นว่าประสิทธิภาพของ OLMo27B แซงหน้า Llama3.18B และกลายเป็นหนึ่งในโมเดลภาษาเปิดเต็มรูปแบบที่แข็งแกร่งที่สุดในปัจจุบัน สามารถดาวน์โหลด OLMo2 ทุกรุ่นและส่วนประกอบต่างๆ ได้ฟรีผ่านทางเว็บไซต์อย่างเป็นทางการของ Ai2 และปฏิบัติตามใบอนุญาต Apache2.0 ซึ่งหมายความว่าโมเดลเหล่านี้ไม่เพียงแต่สามารถใช้เพื่อการวิจัยเท่านั้น แต่ยังรวมถึงการใช้งานเชิงพาณิชย์ด้วย

ลักษณะโอเพ่นซอร์สของ OLMo2 จะส่งเสริมความร่วมมือแบบเปิดและนวัตกรรมในด้าน AI อย่างมาก ทำให้นักวิจัยและนักพัฒนามีพื้นที่ในการพัฒนาที่กว้างขึ้น เราหวังเป็นอย่างยิ่งว่า OLMo2 จะนำเสนอความก้าวหน้าและการใช้งานที่มากขึ้นในอนาคต