ในช่วงไม่กี่ปีที่ผ่านมา โมเดล Transformer และกลไกความสนใจมีความก้าวหน้าอย่างมากในด้านโมเดลภาษาขนาดใหญ่ (LLM) แต่ปัญหาของการถูกรบกวนจากข้อมูลที่ไม่เกี่ยวข้องยังคงมีอยู่เสมอ บรรณาธิการของ Downcodes จะตีความรายงานล่าสุดสำหรับคุณ ซึ่งเสนอโมเดลใหม่ที่เรียกว่า Differential Transformer (DIFF Transformer) ซึ่งมีจุดมุ่งหมายเพื่อแก้ไขปัญหาสัญญาณรบกวนความสนใจในโมเดล Transformer และปรับปรุงประสิทธิภาพและความแม่นยำของโมเดล โมเดลกรองข้อมูลที่ไม่เกี่ยวข้องออกได้อย่างมีประสิทธิภาพผ่านกลไกการให้ความสนใจที่แตกต่างที่เป็นนวัตกรรมใหม่ ช่วยให้โมเดลสามารถมุ่งเน้นไปที่ข้อมูลสำคัญได้มากขึ้น ดังนั้นจึงบรรลุการปรับปรุงที่สำคัญในหลาย ๆ ด้าน รวมถึงการสร้างแบบจำลองภาษา การประมวลผลข้อความขนาดยาว การดึงข้อมูลสำคัญ และลดภาพลวงตาของโมเดล ฯลฯ .

โมเดลภาษาขนาดใหญ่ (LLM) มีการพัฒนาอย่างรวดเร็วเมื่อเร็ว ๆ นี้ ซึ่งโมเดล Transformer มีบทบาทสำคัญ แกนหลักของ Transformer คือกลไกความสนใจ ซึ่งทำหน้าที่เหมือนตัวกรองข้อมูล และช่วยให้โมเดลมุ่งเน้นไปที่ส่วนที่สำคัญที่สุดของประโยค แต่แม้แต่ Transformer ที่ทรงพลังก็ยังถูกรบกวนด้วยข้อมูลที่ไม่เกี่ยวข้อง เช่นเดียวกับที่คุณพยายามค้นหาหนังสือในห้องสมุด แต่กลับถูกกองหนังสือที่ไม่เกี่ยวข้องล้นหลาม และประสิทธิภาพก็ต่ำโดยธรรมชาติ

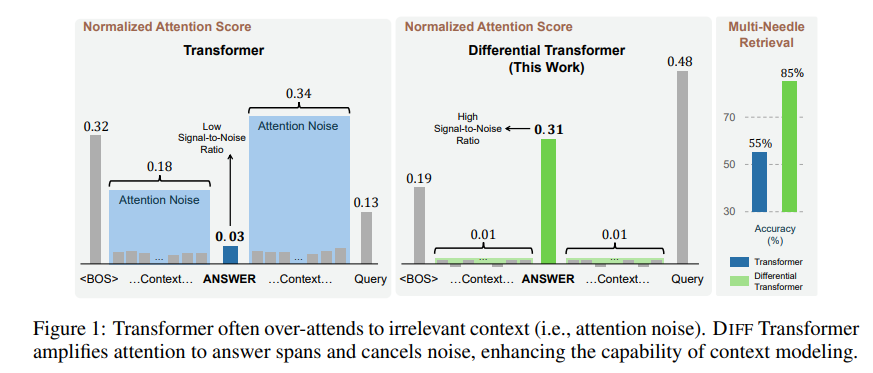

ข้อมูลที่ไม่เกี่ยวข้องซึ่งเกิดจากกลไกความสนใจนี้เรียกว่าสัญญาณรบกวนความสนใจในรายงาน ลองจินตนาการว่าคุณต้องการค้นหาข้อมูลสำคัญในไฟล์ แต่ความสนใจของโมเดล Transformer นั้นกระจัดกระจายไปยังตำแหน่งที่ไม่เกี่ยวข้องต่างๆ เช่นเดียวกับคนสายตาสั้นที่ไม่สามารถมองเห็นประเด็นสำคัญได้

เพื่อแก้ไขปัญหานี้ บทความนี้จึงขอเสนอหม้อแปลงแบบดิฟเฟอเรนเชียล (DIFF Transformer) ชื่อนั้นล้ำหน้ามาก แต่จริงๆ แล้วหลักการนั้นง่ายมาก เช่นเดียวกับหูฟังตัดเสียงรบกวน เสียงจะถูกกำจัดผ่านความแตกต่างระหว่างสัญญาณทั้งสอง

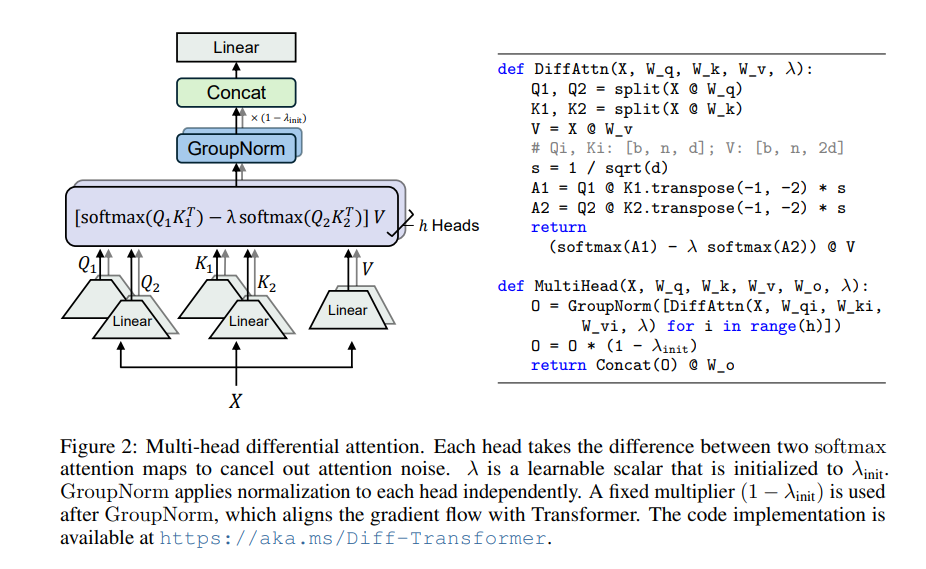

แกนหลักของ Differential Transformer คือกลไกการสนใจที่แตกต่างกัน โดยแบ่งแบบสอบถามและเวกเตอร์คีย์ออกเป็นสองกลุ่ม คำนวณแผนที่ความสนใจสองแผนที่ตามลำดับ จากนั้นลบแผนที่ทั้งสองนี้เพื่อให้ได้คะแนนความสนใจสุดท้าย กระบวนการนี้เหมือนกับการถ่ายภาพวัตถุเดียวกันด้วยกล้องสองตัว จากนั้นซ้อนภาพทั้งสองภาพเข้าด้วยกัน และความแตกต่างจะถูกเน้นให้โดดเด่น

ด้วยวิธีนี้ Differential Transformer สามารถกำจัดสัญญาณรบกวนจากความสนใจได้อย่างมีประสิทธิภาพ และช่วยให้โมเดลมุ่งเน้นไปที่ข้อมูลสำคัญได้มากขึ้น เช่นเดียวกับเมื่อคุณใส่หูฟังป้องกันเสียงรบกวน เสียงรอบข้างจะหายไป และคุณสามารถได้ยินเสียงที่คุณต้องการได้ชัดเจนยิ่งขึ้น

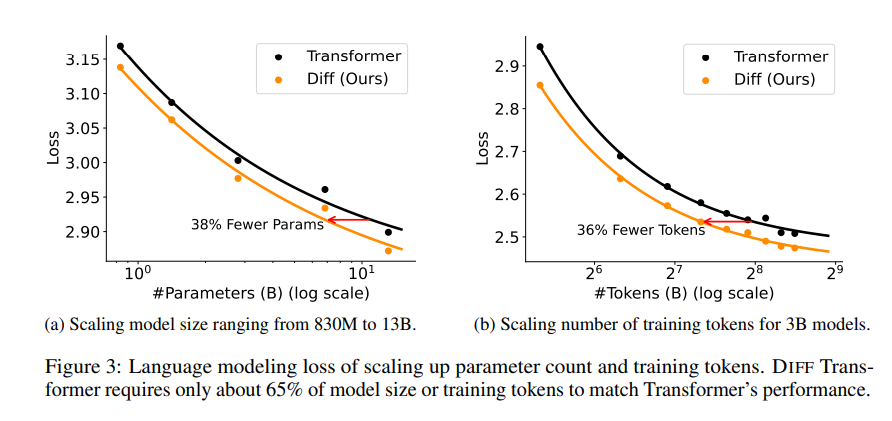

บทความนี้มีการทดลองหลายชุดเพื่อพิสูจน์ความเหนือกว่าของหม้อแปลงดิฟเฟอเรนเชียล ประการแรก ทำงานได้ดีในการสร้างแบบจำลองภาษา โดยต้องการเพียง 65% ของขนาดโมเดลหรือข้อมูลการฝึกอบรมของ Transformer เพื่อให้ได้ผลลัพธ์ที่คล้ายคลึงกัน

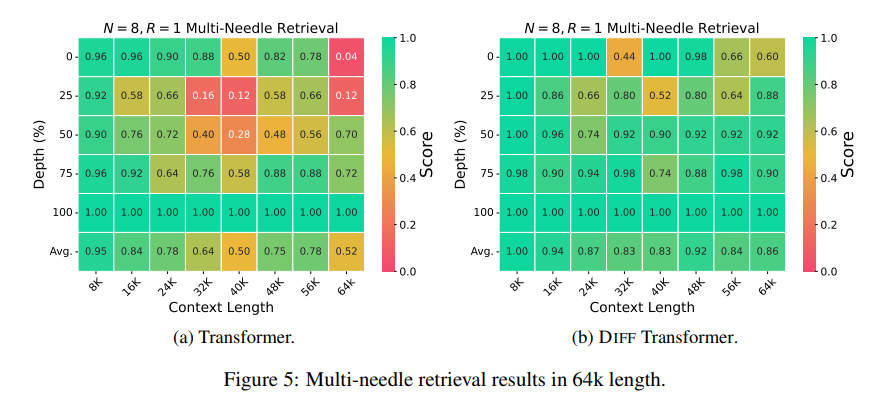

ประการที่สอง Differential Transformer ยังดีกว่าในการสร้างแบบจำลองข้อความยาวและสามารถใช้ข้อมูลบริบทที่ยาวขึ้นได้อย่างมีประสิทธิภาพ

ที่สำคัญกว่านั้น Differential Transformer แสดงให้เห็นถึงข้อได้เปรียบที่สำคัญในการดึงข้อมูลที่สำคัญ การลดภาพลวงตาของโมเดล และการเรียนรู้บริบท

ในแง่ของการดึงข้อมูลที่สำคัญ Differential Transformer เปรียบเสมือนเครื่องมือค้นหาที่แม่นยำซึ่งสามารถค้นหาสิ่งที่คุณต้องการในข้อมูลจำนวนมหาศาลได้อย่างแม่นยำ โดยสามารถรักษาความแม่นยำสูงได้แม้ในสถานการณ์ที่มีข้อมูลที่ซับซ้อนอย่างยิ่ง

ในแง่ของการลดภาพหลอนของแบบจำลอง Differential Transformer สามารถหลีกเลี่ยงแบบจำลองที่ "ไร้สาระ" ได้อย่างมีประสิทธิภาพ และสร้างการสรุปข้อความและผลลัพธ์คำถามและคำตอบที่แม่นยำและเชื่อถือได้มากขึ้น

ในด้านการเรียนรู้บริบท Differential Transformer เปรียบเสมือนผู้เชี่ยวชาญด้านการเรียนรู้มากกว่า สามารถเรียนรู้ความรู้ใหม่ๆ ได้อย่างรวดเร็วจากกลุ่มตัวอย่างจำนวนน้อย และผลการเรียนรู้มีความเสถียรมากกว่า ต่างจาก Transformer ที่ไม่ได้รับผลกระทบจากลำดับตัวอย่างง่ายๆ .

นอกจากนี้ Differential Transformer ยังสามารถลดค่าผิดปกติในค่าการเปิดใช้งานโมเดลได้อย่างมีประสิทธิภาพ ซึ่งหมายความว่าจะเป็นมิตรกับการวัดปริมาณของโมเดลมากกว่า และสามารถบรรลุการวัดปริมาณบิตที่ต่ำกว่าได้ ซึ่งจะช่วยปรับปรุงประสิทธิภาพของแบบจำลอง

โดยรวมแล้ว Differential Transformer สามารถแก้ไขปัญหาเสียงรบกวนของรุ่น Transformer ได้อย่างมีประสิทธิภาพผ่านกลไกการสนใจที่แตกต่างกัน และบรรลุการปรับปรุงที่สำคัญในหลาย ๆ ด้าน โดยให้แนวคิดใหม่ๆ สำหรับการพัฒนาโมเดลภาษาขนาดใหญ่ และจะมีบทบาทสำคัญในสาขาอื่นๆ ในอนาคต

ที่อยู่กระดาษ: https://arxiv.org/pdf/2410.05258

โดยรวมแล้ว Differential Transformer มอบวิธีการที่มีประสิทธิภาพในการแก้ปัญหาเสียงรบกวนของโมเดล Transformer ประสิทธิภาพที่ยอดเยี่ยมในหลายสาขาบ่งชี้ถึงตำแหน่งที่สำคัญในการพัฒนาโมเดลภาษาขนาดใหญ่ในอนาคต บรรณาธิการของ Downcodes แนะนำให้ผู้อ่านอ่านบทความฉบับเต็มเพื่อทำความเข้าใจในรายละเอียดทางเทคนิคและโอกาสในการนำไปใช้อย่างลึกซึ้ง เราหวังว่าจะได้ Differential Transformer ที่จะนำเสนอความก้าวหน้าในด้านปัญญาประดิษฐ์มากขึ้น!