ล่าสุด บรรณาธิการของ Downcodes ให้ความสนใจกับข่าวที่น่ากังวล: เครื่องมือถอดความ AI ที่ใช้กันอย่างแพร่หลายในอุตสาหกรรมการแพทย์ซึ่งใช้เทคโนโลยี Whisper ของ OpenAI พบว่ามี "ภาพหลอน" และอาจสร้างเนื้อหาที่เป็นเท็จ สิ่งนี้กระตุ้นให้เกิดความกังวลเกี่ยวกับความปลอดภัยและความน่าเชื่อถือของเทคโนโลยี AI ในด้านการแพทย์ บทความนี้จะวิเคราะห์เหตุการณ์นี้โดยละเอียด สำรวจความเสี่ยงที่อาจเกิดขึ้น และการตอบสนองของ OpenAI

เมื่อเร็วๆ นี้ เครื่องมือถอดความ AI ที่ขับเคลื่อนโดยเทคโนโลยี Whisper ของ OpenAI ได้รับความนิยมในอุตสาหกรรมการแพทย์ แพทย์และองค์กรด้านการดูแลสุขภาพหลายแห่งใช้เครื่องมือนี้เพื่อบันทึกและสรุปการเผชิญหน้าของผู้ป่วย

ตามรายงานของ ABC News นักวิจัยพบว่าเครื่องมือนี้อาจทำให้เกิด "ภาพหลอน" ได้ในบางกรณี และบางครั้งก็สร้างเนื้อหาขึ้นมาเลยด้วยซ้ำ

เครื่องมือถอดความที่พัฒนาโดยบริษัทชื่อ Nabla ประสบความสำเร็จในการถอดเสียงบทสนทนาทางการแพทย์มากกว่า 7 ล้านครั้ง และปัจจุบันมีแพทย์มากกว่า 30,000 คนและระบบสุขภาพ 40 ระบบใช้งานอยู่ ถึงกระนั้น Nabla ก็ตระหนักถึงศักยภาพที่ Whisper จะมีอาการประสาทหลอน และบอกว่ากำลังดำเนินการเพื่อแก้ไขปัญหานี้

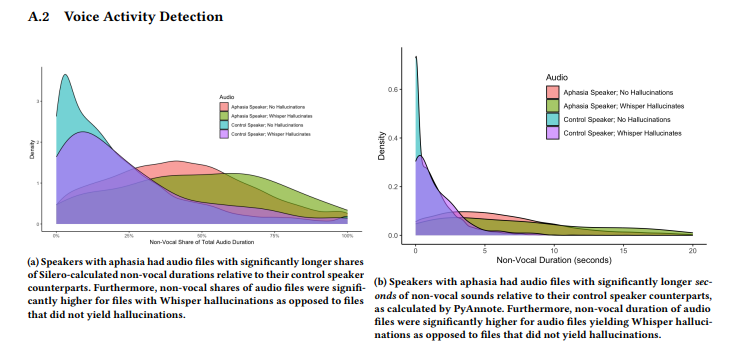

การศึกษาที่ดำเนินการโดยทีมนักวิจัยจาก Cornell University, University of Washington และคนอื่นๆ พบว่า Whisper มีอาการประสาทหลอนประมาณ 1% ของการถอดเสียง ในกรณีเหล่านี้ เครื่องมือจะสุ่มสร้างวลีที่ไม่มีความหมายในช่วงเวลาที่บันทึกเสียงอย่างเงียบๆ ซึ่งบางครั้งอาจแสดงอารมณ์ที่รุนแรง นักวิจัยได้รวบรวมตัวอย่างเสียงจาก AphasiaBank ของ TalkBank และตั้งข้อสังเกตว่าความเงียบเป็นเรื่องปกติโดยเฉพาะอย่างยิ่งเมื่อผู้ที่มีความผิดปกติในการพูดพูด

Allison Koenecke นักวิจัยจากมหาวิทยาลัย Cornell แบ่งปันตัวอย่างบางส่วนบนโซเชียลมีเดียที่แสดงเนื้อหาหลอนประสาทที่สร้างโดย Whisper นักวิจัยพบว่าเนื้อหาที่สร้างโดยเครื่องมือนี้ยังรวมถึงคำศัพท์ทางการแพทย์ที่สร้างขึ้นและแม้แต่วลีเช่น "ขอบคุณสำหรับการรับชม!" ซึ่งฟังดูเหมือนคำจากวิดีโอ YouTube

การวิจัยถูกนำเสนอในการประชุม FAccT ของสมาคมเครื่องจักรคอมพิวเตอร์ในประเทศบราซิลเมื่อเดือนมิถุนายน แต่ก็ไม่ชัดเจนว่าได้รับการตรวจสอบโดยผู้ทรงคุณวุฒิหรือไม่ เกี่ยวกับปัญหานี้ Taya Christianson โฆษกของ OpenAI กล่าวในการให้สัมภาษณ์กับ "The Verge" ว่าพวกเขาให้ความสำคัญกับปัญหานี้เป็นอย่างมาก และจะพยายามทำงานอย่างหนักเพื่อปรับปรุงต่อไป โดยเฉพาะอย่างยิ่งในการลดอาการประสาทหลอน ในเวลาเดียวกัน เธอกล่าวว่าเมื่อใช้ Whisper บนแพลตฟอร์ม API มีนโยบายการใช้งานที่ชัดเจนซึ่งห้ามไม่ให้ใช้เครื่องมือในสภาพแวดล้อมการตัดสินใจที่มีเดิมพันสูง

ไฮไลท์:

เครื่องมือถอดเสียง Whisper ใช้กันอย่างแพร่หลายในอุตสาหกรรมการแพทย์ และบันทึกการสนทนาทางการแพทย์ได้ 7 ล้านครั้ง

⚠️ การวิจัยพบว่า Whisper "ทำให้เกิดอาการประสาทหลอน" ประมาณ 1% ของการถอดเสียง ซึ่งบางครั้งก็สร้างเนื้อหาที่ไม่มีความหมาย

OpenAI กล่าวว่ากำลังดำเนินการปรับปรุงประสิทธิภาพของเครื่องมือ โดยเฉพาะอย่างยิ่งในการลดอาการประสาทหลอน

โดยรวมแล้ว เทคโนโลยี AI มีแนวโน้มกว้างไกลสำหรับการนำไปใช้ในวงการแพทย์ แต่ก็เผชิญกับความท้าทายมากมายเช่นกัน การเกิดขึ้นของปรากฏการณ์ “ภาพหลอน” ของ Whisper เตือนเราว่าเราจำเป็นต้องปฏิบัติต่อเทคโนโลยี AI ด้วยความระมัดระวัง และเสริมสร้างการกำกับดูแลด้านความปลอดภัยและความน่าเชื่อถือเพื่อให้แน่ใจว่าการใช้งานที่ปลอดภัยและมีประสิทธิภาพในด้านการแพทย์ และปกป้องสิทธิและความปลอดภัยของผู้ป่วย บรรณาธิการของ Downcodes จะยังคงให้ความสำคัญกับการพัฒนาเหตุการณ์นี้ต่อไป