ลักษณะ "กล่องดำ" ของโมเดลภาษาขนาดใหญ่ (LLM) ถือเป็นประเด็นสำคัญที่สร้างปัญหาในด้านปัญญาประดิษฐ์มาโดยตลอด ผลลัพธ์ของโมเดลเอาท์พุตที่แปลไม่ได้ทำให้ยากต่อการรับประกันความน่าเชื่อถือและความน่าเชื่อถือ เพื่อแก้ปัญหานี้ OpenAI ได้เปิดตัวเทคโนโลยีใหม่ที่เรียกว่า Prover-Verifier Games (PVG) ซึ่งมีจุดมุ่งหมายเพื่อปรับปรุงความสามารถในการตีความและตรวจสอบได้ของเอาต์พุต LLM บรรณาธิการของ Downcodes จะอธิบายเทคโนโลยีนี้โดยละเอียดให้คุณ

OpenAI เพิ่งเปิดตัวเทคโนโลยีใหม่ที่เรียกว่า Prover-Verifier Games (PVG) ซึ่งมีจุดมุ่งหมายเพื่อแก้ปัญหา "กล่องดำ" ของเอาต์พุตโมเดลปัญญาประดิษฐ์

ลองนึกภาพคุณมีผู้ช่วยที่ฉลาดสุดๆ แต่กระบวนการคิดของมันเหมือนกับกล่องดำ และคุณไม่รู้ว่ามันจะไปถึงข้อสรุปได้อย่างไร ฟังดูไม่ค่อยสบายใจใช่ไหม ใช่ นี่คือปัญหาที่โมเดลภาษาขนาดใหญ่จำนวนมาก (LLM) เผชิญอยู่ในปัจจุบัน แม้ว่าจะมีประสิทธิภาพ แต่ความถูกต้องของเนื้อหาที่สร้างขึ้นนั้นยากต่อการตรวจสอบ

URL กระดาษ: https://cdn.openai.com/prover-verifier-games-improve-legibility-of-llm-outputs/legibility.pdf

เพื่อแก้ไขปัญหานี้ OpenAI ได้เปิดตัวเทคโนโลยี PVG พูดง่ายๆ คือปล่อยให้รุ่นขนาดเล็ก (เช่น GPT-3) ควบคุมเอาต์พุตของรุ่นขนาดใหญ่ (เช่น GPT-4) มันเหมือนกับการเล่นเกม The Prover มีหน้าที่สร้างเนื้อหา และผู้ตรวจสอบมีหน้าที่ตัดสินว่าเนื้อหานั้นถูกต้องหรือไม่ ฟังดูน่าสนใจใช่ไหม?

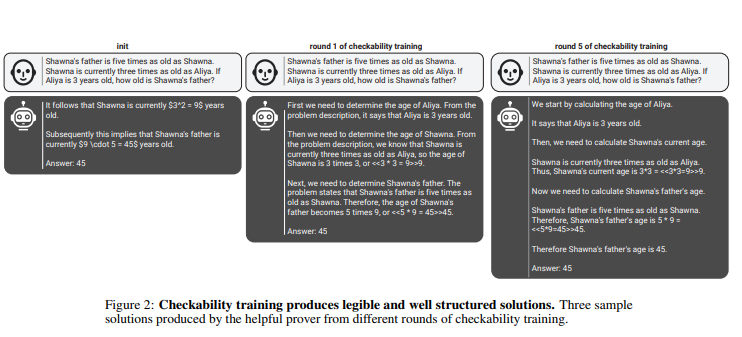

ในกฎนี้ ผู้พิสูจน์และผู้ตรวจสอบจะปรับปรุงความสามารถของตนอย่างต่อเนื่องผ่านการฝึกอบรมซ้ำหลายรอบ ผู้ตรวจสอบใช้การเรียนรู้แบบมีผู้สอนเพื่อทำนายความถูกต้องของเนื้อหา ในขณะที่ผู้พิสูจน์ใช้การเรียนรู้แบบเสริมกำลังเพื่อเพิ่มประสิทธิภาพเนื้อหาที่พวกเขาสร้างขึ้น สิ่งที่น่าสนใจยิ่งกว่านั้นคือ มีสุภาษิตอยู่สองประเภท: สุภาษิตที่มีประโยชน์ และสุภาษิตที่มีไหวพริบ สุภาษิตที่มีประโยชน์พยายามสร้างเนื้อหาที่ถูกต้องและโน้มน้าวใจ ในขณะที่สุภาษิตเจ้าเล่ห์พยายามสร้างเนื้อหาที่ไม่ถูกต้องแต่น่าเชื่อถือพอๆ กัน ดังนั้นจึงเป็นการท้าทายวิจารณญาณของผู้ตรวจสอบ

penAI เน้นย้ำว่าเพื่อฝึกอบรมโมเดลตัวตรวจสอบที่มีประสิทธิภาพ จำเป็นต้องมีข้อมูลฉลากจริงและถูกต้องจำนวนมากเพื่อปรับปรุงความสามารถในการจดจำ มิฉะนั้น แม้ว่าจะใช้เทคโนโลยี PVG เนื้อหาที่ได้รับการตรวจสอบแล้วอาจยังมีความเสี่ยงต่อการส่งออกที่ผิดกฎหมาย

ไฮไลท์:

เทคโนโลยี PVG แก้ปัญหา AI “กล่องดำ” ด้วยการตรวจสอบเอาท์พุตของรุ่นใหญ่กับรุ่นเล็ก

กรอบการฝึกอบรมขึ้นอยู่กับทฤษฎีเกมและจำลองปฏิสัมพันธ์ระหว่างผู้พิสูจน์และผู้ตรวจสอบ ปรับปรุงความแม่นยำและความสามารถในการควบคุมของเอาต์พุตแบบจำลอง

จำเป็นต้องมีข้อมูลจริงจำนวนมากเพื่อฝึกโมเดลตัวตรวจสอบเพื่อให้แน่ใจว่ามีวิจารณญาณและความทนทานเพียงพอ

โดยรวมแล้ว เทคโนโลยี PVG ของ OpenAI มอบแนวคิดใหม่ในการแก้ปัญหา "กล่องดำ" ของโมเดลปัญญาประดิษฐ์ แต่ประสิทธิภาพยังคงขึ้นอยู่กับข้อมูลการฝึกอบรมคุณภาพสูง การพัฒนาในอนาคตของเทคโนโลยีนี้เป็นสิ่งที่ควรค่าแก่การรอคอย เนื่องจากจะส่งเสริมการพัฒนาแบบจำลองปัญญาประดิษฐ์ในทิศทางที่เชื่อถือได้ อธิบายได้ และน่าเชื่อถือมากขึ้น บรรณาธิการของ Downcodes หวังว่าจะได้เห็นเทคโนโลยีที่เป็นนวัตกรรมที่คล้ายกันเกิดขึ้นมากขึ้น