โปรแกรมแก้ไข Downcodes จะทำให้คุณเข้าใจถึงความลับของโมเดล Transformer อย่างเจาะลึก! เมื่อเร็วๆ นี้ บทความชื่อ "Transformer Layers as Painters" ได้อธิบายอย่างชัดเจนถึงกลไกการทำงานของชั้นกลางของโมเดล Transformer จากมุมมองของ "จิตรกร" บทความนี้แสดงให้เห็นว่าลำดับชั้นของ Transformer ทำงานอย่างไรผ่านคำอุปมาและการทดลองที่ชาญฉลาด โดยให้แนวคิดใหม่ๆ ให้เราเข้าใจการทำงานภายในของโมเดลภาษาขนาดใหญ่ ในบทความนี้ ผู้เขียนเปรียบเทียบแต่ละชั้นของ Transformer กับจิตรกร โดยทำงานร่วมกันเพื่อสร้างภาพในภาษาที่ยิ่งใหญ่ และตรวจสอบมุมมองนี้ผ่านชุดการทดลอง

ในโลกแห่งปัญญาประดิษฐ์มีกลุ่มจิตรกรพิเศษ - โครงสร้างลำดับชั้นในโมเดล Transformer พวกมันเปรียบเสมือนพู่กันมหัศจรรย์ วาดภาพโลกหลากสีบนผืนผ้าใบแห่งภาษา เมื่อเร็ว ๆ นี้ บทความชื่อ Transformer Layers as Painters ได้มอบมุมมองใหม่ให้เราเข้าใจกลไกการทำงานของเลเยอร์กลางของ Transformer

โมเดล Transformer ซึ่งเป็นโมเดลภาษาขนาดใหญ่ที่ได้รับความนิยมมากที่สุดในปัจจุบัน มีพารามิเตอร์นับพันล้านรายการ แต่ละชั้นของมันเปรียบเสมือนจิตรกรที่ทำงานร่วมกันเพื่อสร้างภาพภาษาที่ยิ่งใหญ่ให้สมบูรณ์ แต่จิตรกรเหล่านี้ทำงานร่วมกันอย่างไร แปรงและสีที่พวกเขาใช้แตกต่างกันอย่างไร บทความนี้พยายามตอบคำถามเหล่านี้

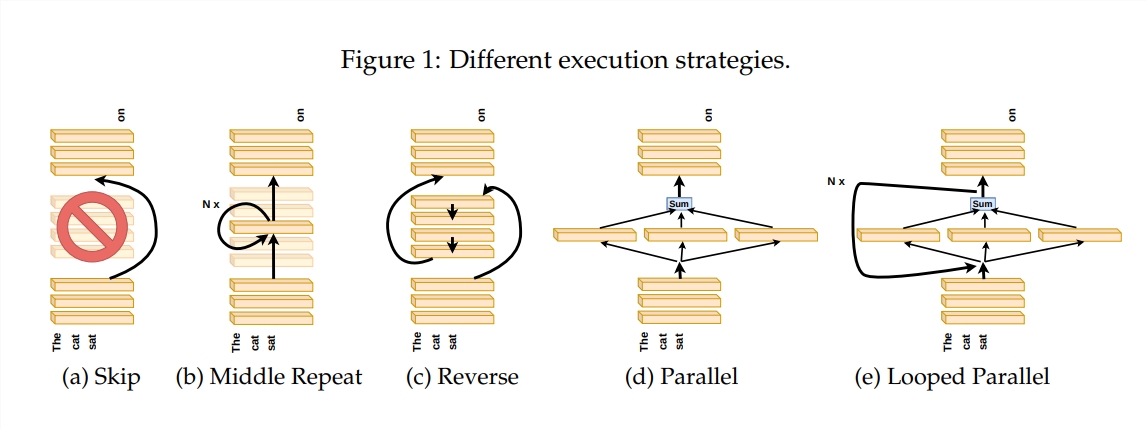

เพื่อสำรวจวิธีการทำงานของเลเยอร์ Transformer ผู้เขียนได้ออกแบบชุดการทดลอง รวมถึงการข้ามบางเลเยอร์ การเปลี่ยนลำดับของเลเยอร์ หรือการรันเลเยอร์ในแบบคู่ขนาน การทดลองเหล่านี้เปรียบเสมือนการกำหนดกฎการวาดภาพที่แตกต่างกันสำหรับจิตรกรเพื่อดูว่าพวกเขาสามารถปรับตัวได้หรือไม่

ในคำอุปมา "ไปป์ไลน์ของจิตรกร" ข้อมูลนำเข้าจะถูกมองว่าเป็นผืนผ้าใบ และกระบวนการส่งผ่านชั้นกลางก็เหมือนกับการส่งผ่านผืนผ้าใบบนสายการประกอบ "จิตรกร" แต่ละคน ซึ่งก็คือแต่ละชั้นของ Transformer จะปรับเปลี่ยนภาพวาดตามความเชี่ยวชาญของตนเอง การเปรียบเทียบนี้ช่วยให้เราเข้าใจความเท่าเทียมและความสามารถในการปรับขนาดของเลเยอร์ Transformer

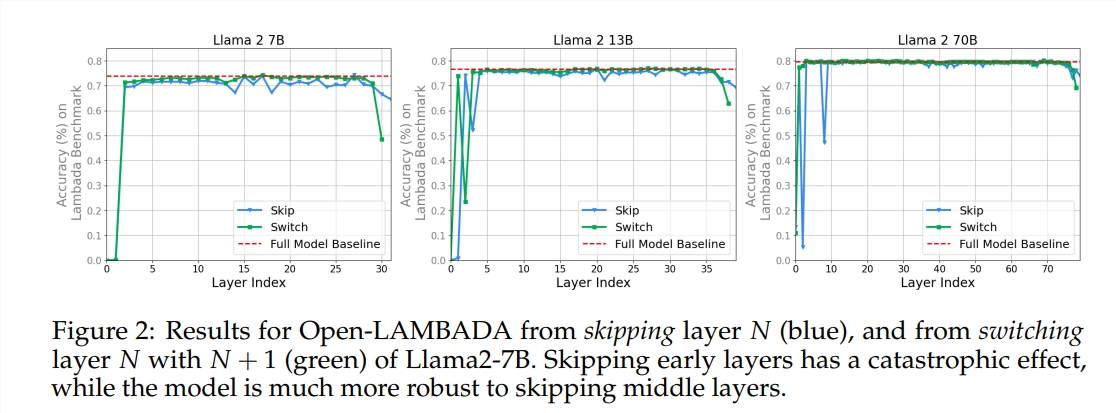

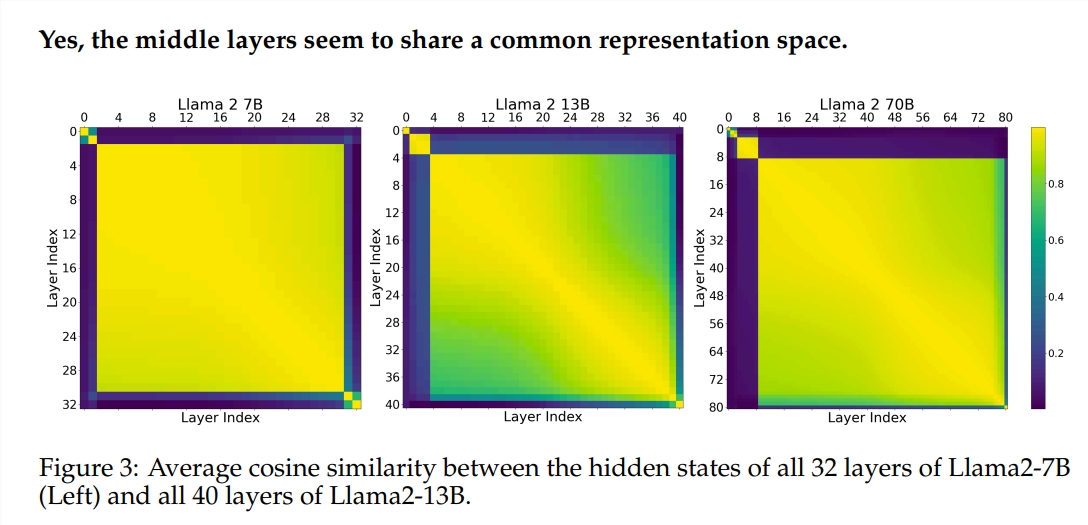

การทดลองใช้แบบจำลองภาษาขนาดใหญ่ (LLM) ที่ได้รับการฝึกอบรมล่วงหน้าสองแบบ ได้แก่ Llama2-7B และ BERT ผลการศึกษาพบว่าจิตรกรในระดับกลางดูเหมือนจะใช้กล่องสีร่วมกันซึ่งเป็นตัวแทนของพื้นที่ แตกต่างจากสีในชั้นแรกและชั้นสุดท้าย จิตรกรที่ข้ามชั้นกลางบางชั้นจะมีผลกระทบเพียงเล็กน้อยต่อภาพวาดทั้งหมด ซึ่งบ่งชี้ว่าไม่จำเป็นต้องใช้จิตรกรทุกคน

แม้ว่าจิตรกรชั้นกลางจะใช้กล่องสีเดียวกัน แต่พวกเขาใช้ทักษะของตนเองในการวาดภาพลวดลายต่างๆ บนผืนผ้าใบ หากคุณใช้เทคนิคบางอย่างของจิตรกรซ้ำ ภาพวาดนั้นจะสูญเสียเสน่ห์ดั้งเดิมไป

ลำดับที่คุณวาดมีความสำคัญอย่างยิ่งสำหรับงานทางคณิตศาสตร์และการให้เหตุผลซึ่งต้องใช้ตรรกะที่เข้มงวด สำหรับงานที่ต้องอาศัยความเข้าใจเชิงความหมาย ผลกระทบของลำดับจะมีค่อนข้างน้อย

ผลการวิจัยพบว่าชั้นกลางของ Transformer มีความสม่ำเสมอในระดับหนึ่งแต่ไม่ได้ซ้ำซ้อน สำหรับงานทางคณิตศาสตร์และการให้เหตุผล ลำดับของเลเยอร์มีความสำคัญมากกว่างานด้านความหมาย

การศึกษายังพบว่าไม่จำเป็นทุกเลเยอร์และสามารถข้ามเลเยอร์กลางได้โดยไม่ส่งผลกระทบร้ายแรงต่อประสิทธิภาพของโมเดล นอกจากนี้ แม้ว่าเลเยอร์กลางจะใช้พื้นที่การแสดงเดียวกัน แต่ก็ทำหน้าที่ต่างกัน การเปลี่ยนลำดับการดำเนินการของเลเยอร์ส่งผลให้ประสิทธิภาพลดลง ซึ่งบ่งชี้ว่าลำดับนั้นมีผลกระทบสำคัญต่อประสิทธิภาพของโมเดล

บนเส้นทางการสำรวจโมเดล Transformer นักวิจัยหลายคนกำลังพยายามเพิ่มประสิทธิภาพ รวมถึงการตัดแต่งกิ่ง การลดพารามิเตอร์ ฯลฯ ผลงานเหล่านี้มอบประสบการณ์อันมีค่าและเป็นแรงบันดาลใจในการทำความเข้าใจโมเดล Transformer

ที่อยู่กระดาษ: https://arxiv.org/pdf/2407.09298v1

โดยรวมแล้ว บทความนี้ให้มุมมองใหม่ให้เราเข้าใจกลไกภายในของโมเดล Transformer และให้แนวคิดใหม่ๆ สำหรับการเพิ่มประสิทธิภาพโมเดลในอนาคต บรรณาธิการของ Downcodes แนะนำให้ผู้อ่านที่สนใจอ่านบทความเต็มเพื่อทำความเข้าใจในเชิงลึกเกี่ยวกับความลึกลับของโมเดล Transformer!