สาขาวิชาการประมวลผลภาษาธรรมชาติ (NLP) กำลังเปลี่ยนแปลงไปในแต่ละวัน และการพัฒนาอย่างรวดเร็วของโมเดลภาษาขนาดใหญ่ (LLM) ได้นำโอกาสและความท้าทายที่ไม่เคยมีมาก่อนมาให้เรา ในหมู่พวกเขา การพึ่งพาการประเมินแบบจำลองกับข้อมูลที่มีคำอธิบายประกอบโดยมนุษย์ถือเป็นปัญหาคอขวด งานรวบรวมข้อมูลที่มีค่าใช้จ่ายสูงและใช้เวลานานจะจำกัดการประเมินที่มีประสิทธิภาพและการปรับปรุงแบบจำลองอย่างต่อเนื่อง บรรณาธิการของ Downcodes จะแนะนำโซลูชันใหม่ที่เสนอโดยนักวิจัย Meta FAIR - "ผู้ประเมินการเรียนรู้ด้วยตนเอง" ซึ่งให้แนวคิดใหม่สำหรับการแก้ปัญหานี้

ในยุคปัจจุบัน สาขาการประมวลผลภาษาธรรมชาติ (NLP) กำลังพัฒนาอย่างรวดเร็ว และโมเดลภาษาขนาดใหญ่ (LLM) สามารถทำงานที่เกี่ยวข้องกับภาษาที่ซับซ้อนได้ด้วยความแม่นยำสูง ทำให้มีความเป็นไปได้มากขึ้นในการโต้ตอบระหว่างมนุษย์กับคอมพิวเตอร์ อย่างไรก็ตาม ปัญหาสำคัญใน NLP คือการพึ่งพาคำอธิบายประกอบของมนุษย์ในการประเมินแบบจำลอง

ข้อมูลที่มนุษย์สร้างขึ้นถือเป็นสิ่งสำคัญสำหรับการฝึกโมเดลและการตรวจสอบความถูกต้อง แต่การรวบรวมข้อมูลนี้มีราคาแพงและใช้เวลานาน นอกจากนี้ เนื่องจากแบบจำลองมีการปรับปรุงอย่างต่อเนื่อง คำอธิบายประกอบที่รวบรวมไว้ก่อนหน้านี้อาจจำเป็นต้องได้รับการอัปเดต ทำให้มีประโยชน์น้อยลงในการประเมินแบบจำลองใหม่ ส่งผลให้จำเป็นต้องรับข้อมูลใหม่อย่างต่อเนื่อง ก่อให้เกิดความท้าทายต่อขนาดและความยั่งยืนของการประเมินแบบจำลองที่มีประสิทธิผล

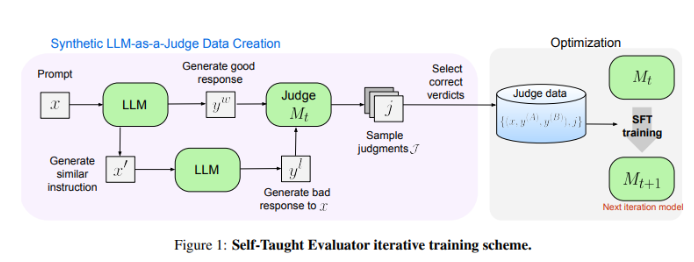

นักวิจัยที่ Meta FAIR ได้คิดค้นวิธีแก้ปัญหาใหม่ - "ผู้ประเมินด้วยตนเอง" วิธีการนี้ไม่จำเป็นต้องมีคำอธิบายประกอบโดยมนุษย์และได้รับการฝึกเกี่ยวกับข้อมูลที่สร้างขึ้นแบบสังเคราะห์ ขั้นแรก แบบจำลองเริ่มต้นสร้างคู่การตั้งค่าสังเคราะห์ที่ตัดกัน จากนั้นแบบจำลองจะประเมินคู่เหล่านี้และปรับปรุงซ้ำๆ โดยใช้วิจารณญาณของตัวเองเพื่อปรับปรุงประสิทธิภาพในการทำซ้ำครั้งต่อๆ ไป ซึ่งช่วยลดการพึ่งพาคำอธิบายประกอบที่มนุษย์สร้างขึ้นได้อย่างมาก

นักวิจัยได้ทดสอบประสิทธิภาพของ "ผู้ประเมินการเรียนรู้ด้วยตนเอง" โดยใช้แบบจำลอง Llama-3-70B-Instruct วิธีการนี้ช่วยเพิ่มความแม่นยำของโมเดลบนเกณฑ์มาตรฐาน RewardBench จาก 75.4 เป็น 88.7 ซึ่งตรงกับหรือเกินกว่าประสิทธิภาพของโมเดลที่ได้รับการฝึกด้วยคำอธิบายประกอบของมนุษย์ หลังจากการวนซ้ำหลายครั้ง โมเดลสุดท้ายได้รับความแม่นยำ 88.3 ในการอนุมานครั้งเดียว และ 88.7 ในการโหวตเสียงข้างมาก ซึ่งแสดงให้เห็นถึงความเสถียรและความน่าเชื่อถือที่แข็งแกร่ง

"ผู้ประเมินการเรียนรู้ด้วยตนเอง" มอบโซลูชันที่ปรับขนาดได้และมีประสิทธิภาพสำหรับการประเมินโมเดล NLP โดยใช้ประโยชน์จากข้อมูลสังเคราะห์และการปรับปรุงตนเองแบบวนซ้ำ จัดการกับความท้าทายในการอาศัยคำอธิบายประกอบของมนุษย์ และการพัฒนาแบบจำลองภาษาที่ก้าวหน้า

ที่อยู่กระดาษ: https://arxiv.org/abs/2408.02666

"ผู้ประเมินการเรียนรู้ด้วยตนเอง" ของ Meta FAIR ได้นำมาซึ่งการเปลี่ยนแปลงครั้งยิ่งใหญ่ในการประเมินโมเดล NLP และฟีเจอร์ที่มีประสิทธิภาพและปรับขนาดได้ของ Meta FAIR จะช่วยส่งเสริมความก้าวหน้าอย่างต่อเนื่องของโมเดลภาษาในอนาคตได้อย่างมีประสิทธิภาพ ผลการวิจัยนี้ไม่เพียงแต่ลดการพึ่งพาข้อมูลคำอธิบายประกอบของมนุษย์เท่านั้น แต่ยังปูทางไปสู่การสร้างแบบจำลอง NLP ที่ทรงพลังและเชื่อถือได้มากขึ้นอีกด้วย เราหวังว่าจะมีนวัตกรรมที่คล้ายกันมากขึ้นในอนาคต!