บรรณาธิการของ Downcodes จะช่วยคุณตีความรายงานการวิจัยระดับโลกที่เผยแพร่โดย Checkmarx ซึ่งเปิดเผยสถานะปัจจุบันของการใช้เครื่องมือการเขียนโปรแกรม AI อย่างแพร่หลายในด้านการพัฒนาซอฟต์แวร์และความเสี่ยงด้านความปลอดภัยที่เกิดขึ้น ข้อมูลรายงานแสดงให้เห็นว่าแม้ว่าบางบริษัทจะสั่งห้ามการใช้เครื่องมือการเขียนโปรแกรม AI อย่างชัดเจน แต่อัตราการนำไปใช้ยังคงสูง โดยเน้นถึงความท้าทายที่องค์กรต้องเผชิญในการจัดการ AI เชิงสร้างสรรค์ รายงานยังให้การอภิปรายเชิงลึกเกี่ยวกับการกำกับดูแลเครื่องมือ AI ขององค์กร การประเมินความเสี่ยงด้านความปลอดภัย และความไว้วางใจของนักพัฒนาในเครื่องมือ AI ซึ่งเป็นข้อมูลอ้างอิงที่สำคัญสำหรับองค์กรต่างๆ ในการใช้เครื่องมือ AI อย่างมีประสิทธิภาพ

จากการศึกษาทั่วโลกที่เผยแพร่โดยบริษัทรักษาความปลอดภัยบนคลาวด์ Checkmarx แม้ว่า 15% ของบริษัทจะห้ามการใช้เครื่องมือการเขียนโปรแกรม AI อย่างชัดเจน แต่ทีมพัฒนาเกือบทั้งหมด (99%) ยังคงใช้เครื่องมือเหล่านี้ ปรากฏการณ์นี้สะท้อนให้เห็นถึงความยากลำบากในการควบคุมการใช้ generative AI ในกระบวนการพัฒนาจริง

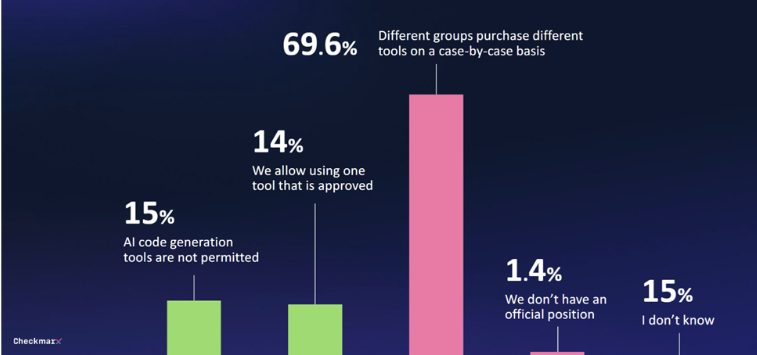

การศึกษาพบว่ามีเพียง 29% ของบริษัทเท่านั้นที่สร้างระบบการกำกับดูแลทุกรูปแบบสำหรับเครื่องมือ AI เชิงสร้างสรรค์ 70% ของบริษัทไม่มีกลยุทธ์ส่วนกลาง และการตัดสินใจจัดซื้อจัดจ้างของแผนกต่างๆ มักจะเกิดขึ้นชั่วคราวและขาดการจัดการแบบครบวงจร

เนื่องจากนักพัฒนาใช้เครื่องมือการเขียนโปรแกรม AI มากขึ้นเรื่อยๆ ปัญหาด้านความปลอดภัยจึงกลายเป็นข้อกังวลที่เพิ่มขึ้น 80% ของผู้ตอบแบบสอบถามกังวลเกี่ยวกับภัยคุกคามที่อาจเกิดขึ้นที่นักพัฒนาอาจนำมาเมื่อใช้ AI และ 60% กังวลเป็นพิเศษเกี่ยวกับ "ภาพหลอน" ที่อาจเกิดขึ้นจาก AI

แม้จะมีข้อกังวลเหล่านี้ แต่ผู้คนจำนวนมากยังคงสนใจในศักยภาพของ AI 47% ของผู้ตอบแบบสอบถามเต็มใจที่จะปล่อยให้ AI ทำการเปลี่ยนแปลงโค้ดโดยไม่มีการควบคุมดูแล ในขณะที่มีเพียง 6% เท่านั้นที่แสดงความไม่ไว้วางใจมาตรการรักษาความปลอดภัยของ AI ในสภาพแวดล้อมซอฟต์แวร์โดยสิ้นเชิง

Kobi Tzruya ประธานเจ้าหน้าที่ฝ่ายผลิตภัณฑ์ของ Checkmarx กล่าวว่า “การตอบรับจาก CISO ทั่วโลกเผยให้เห็นว่านักพัฒนากำลังใช้ AI เพื่อการพัฒนาแอปพลิเคชัน แม้ว่าเครื่องมือ AI เหล่านี้จะไม่สามารถสร้างโค้ดที่ปลอดภัยได้อย่างน่าเชื่อถือ ซึ่งหมายความว่าทีมรักษาความปลอดภัยกำลังเผชิญกับปัญหาจำนวนมาก รหัสใหม่และรหัสที่อาจเป็นอันตราย"

รายงานดัชนีแนวโน้มการทำงานของ Microsoft ยังแสดงให้เห็นว่าพนักงานจำนวนมากใช้เครื่องมือ AI ของตนเองโดยไม่ได้จัดเตรียมให้ และมักไม่พูดคุยเรื่องนี้อย่างเปิดเผย ซึ่งเป็นอุปสรรคต่อการนำ generative AI ไปใช้ในกระบวนการทางธุรกิจอย่างเป็นระบบ

ไฮไลท์:

1. ? **15% ของบริษัทแบนเครื่องมือการเขียนโปรแกรม AI แต่ 99% ของทีมพัฒนายังคงใช้งานอยู่**

2. ? **มีเพียง 29% ของบริษัทเท่านั้นที่สร้างระบบการกำกับดูแลสำหรับเครื่องมือ AI เชิงสร้างสรรค์**

3. ? **47% ของผู้ตอบแบบสอบถามยินดีให้ AI ทำการเปลี่ยนแปลงโค้ดโดยไม่ได้รับการดูแล**

โดยรวมแล้ว รายงานเน้นย้ำถึงความจำเป็นขององค์กรในการเสริมสร้างนโยบายการจัดการและความปลอดภัยของเครื่องมือการเขียนโปรแกรม AI และสร้างสมดุลระหว่างความสะดวกสบายที่ AI นำมากับความเสี่ยงที่อาจเกิดขึ้น องค์กรต่างๆ ควรกำหนดกลยุทธ์ที่เป็นหนึ่งเดียวและให้ความสนใจกับช่องโหว่ด้านความปลอดภัยที่ AI อาจนำมา เพื่อให้สามารถใช้เทคโนโลยี AI เพื่อปรับปรุงประสิทธิภาพการพัฒนาได้ดียิ่งขึ้น บรรณาธิการของ Downcodes แนะนำให้ให้ความสนใจกับรายงานติดตามผลของ Checkmarx เพื่อเรียนรู้เพิ่มเติมเกี่ยวกับการพัฒนาด้านความปลอดภัยของ AI