เมื่อเร็วๆ นี้ ประสบการณ์ผู้ใช้แชทบอท AI ของ Anthropic Claude ได้จุดประกายให้เกิดการพูดคุยอย่างดุเดือด ความคิดเห็นจากผู้ใช้จำนวนมากปรากฏบน Reddit โดยบอกว่าประสิทธิภาพของ Claude ลดลง โดยเฉพาะอย่างยิ่งปรากฏให้เห็นจากการสูญเสียความทรงจำและความสามารถในการเขียนโค้ดลดลง เหตุการณ์นี้กระตุ้นให้เกิดการอภิปรายอย่างกว้างขวางเกี่ยวกับการประเมินประสิทธิภาพและประสบการณ์ผู้ใช้ของโมเดลภาษาขนาดใหญ่ และเน้นย้ำอีกครั้งถึงความท้าทายที่บริษัท AI ต้องเผชิญในการรักษาความเสถียรของโมเดล

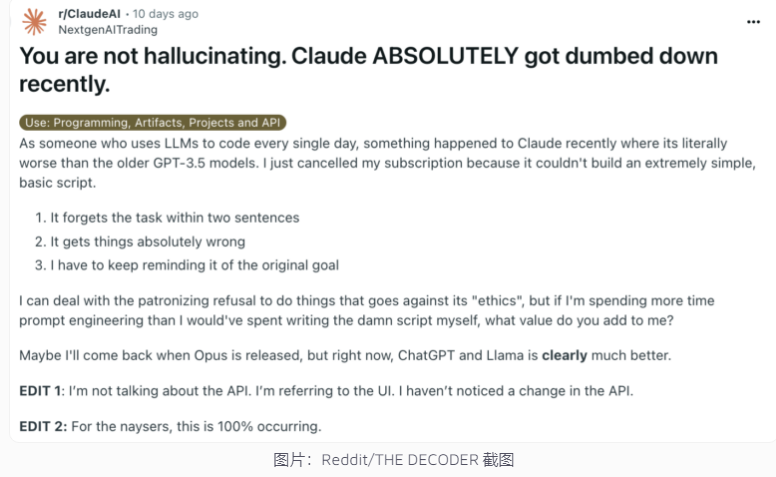

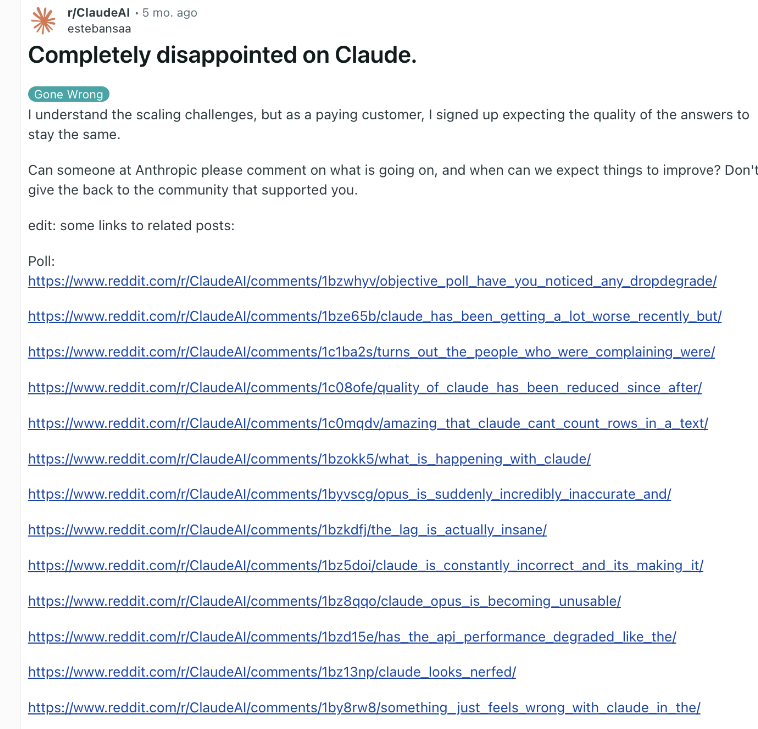

เมื่อเร็ว ๆ นี้ Claude แชทบอท AI ของ Anthropic มีส่วนเกี่ยวข้องกับความขัดแย้งด้านประสิทธิภาพอีกครั้ง โพสต์ใน Reddit อ้างว่า Claude กลายเป็นคนโง่มากขึ้นเมื่อเร็ว ๆ นี้ได้รับความสนใจอย่างกว้างขวาง โดยผู้ใช้หลายคนรายงานว่าพวกเขาประสบกับความสามารถของ Claude ที่ลดลง รวมถึงการสูญเสียความทรงจำและความสามารถในการเขียนโค้ดที่ลดลง

ในการตอบสนอง Alex Albert ผู้บริหารด้าน Anthropic ตอบว่าการสอบสวนของบริษัทไม่พบปัญหาทั่วไปใดๆ และยืนยันว่าไม่มีการเปลี่ยนแปลงใดๆ กับโมเดล Claude3.5Sonnet หรือไปป์ไลน์การอนุมาน เพื่อปรับปรุงความโปร่งใส Anthropic ได้เผยแพร่ระบบแจ้งของแบบจำลอง Claude บนเว็บไซต์อย่างเป็นทางการ

นี่ไม่ใช่ครั้งแรกที่ผู้ใช้รายงานความเสื่อมโทรมของ AI และบริษัทได้ปฏิเสธ ในช่วงสิ้นปี 2023 ChatGPT ของ OpenAI ก็ต้องเผชิญกับข้อสงสัยที่คล้ายกันเช่นกัน ตามที่คนในวงการอุตสาหกรรมระบุ สาเหตุของปรากฏการณ์นี้อาจรวมถึง: ความคาดหวังของผู้ใช้ที่เพิ่มขึ้นเมื่อเวลาผ่านไป การเปลี่ยนแปลงตามธรรมชาติในเอาท์พุต AI ข้อจำกัดทรัพยากรการประมวลผลชั่วคราว เป็นต้น

อย่างไรก็ตาม ปัจจัยเหล่านี้อาจยังส่งผลให้ประสิทธิภาพที่ผู้ใช้รับรู้ลดลง แม้ว่าโมเดลพื้นฐานจะไม่มีการเปลี่ยนแปลงที่สำคัญก็ตาม OpenAI เคยชี้ให้เห็นว่าพฤติกรรมของ AI นั้นเป็นสิ่งที่คาดเดาไม่ได้ และการรักษาและประเมินประสิทธิภาพ AI ที่สร้างในวงกว้างถือเป็นความท้าทายอย่างมาก

Anthropic กล่าวว่าจะยังคงให้ความสำคัญกับความคิดเห็นของผู้ใช้ และทำงานอย่างหนักเพื่อปรับปรุงเสถียรภาพด้านประสิทธิภาพของ Claude เหตุการณ์ดังกล่าวเน้นย้ำถึงความท้าทายที่บริษัท AI เผชิญในการรักษาความสอดคล้องของโมเดล ตลอดจนความสำคัญของการเพิ่มความโปร่งใสในการประเมินประสิทธิภาพและการสื่อสารของ AI

ข้อขัดแย้งด้านประสิทธิภาพของ Claude สะท้อนให้เห็นถึงความซับซ้อนของการพัฒนาและการปรับใช้โมเดลภาษาขนาดใหญ่ รวมถึงช่องว่างระหว่างความคาดหวังของผู้ใช้และการใช้งานจริง ในอนาคต บริษัท AI จำเป็นต้องปรับปรุงความเสถียรของโมเดลเพิ่มเติม และรักษาการสื่อสารที่มีประสิทธิภาพมากขึ้นกับผู้ใช้ เพื่อให้แน่ใจว่าเทคโนโลยี AI สามารถให้บริการแก่ผู้ใช้ได้อย่างน่าเชื่อถือต่อไป