เมื่อเร็วๆ นี้ มีการเปิดเผยช่องโหว่ด้านความปลอดภัยที่สำคัญในระบบ AI ใหม่ของ Apple นั่นคือ Apple Intelligence นักพัฒนา Evan Zhou ใช้การโจมตีแบบ "พร้อมท์ฉีด" เพื่อเลี่ยงผ่านคำสั่งของระบบได้สำเร็จ และทำให้มันตอบสนองต่อการแจ้งเตือนโดยพลการ ก่อให้เกิดความกังวลอย่างกว้างขวางในอุตสาหกรรมเกี่ยวกับความปลอดภัยของ AI ช่องโหว่นี้ใช้ประโยชน์จากข้อบกพร่องในเทมเพลตพร้อมท์ระบบ AI และแท็กพิเศษ และในที่สุดก็ประสบความสำเร็จในการควบคุมระบบ AI ด้วยการสร้างพร้อมท์ใหม่ที่ครอบคลุมพร้อมท์ของระบบดั้งเดิม เหตุการณ์นี้เตือนเราอีกครั้งถึงความสำคัญของความปลอดภัยของ AI และความเสี่ยงด้านความปลอดภัยที่อาจเกิดขึ้นซึ่งจำเป็นต้องพิจารณาเมื่อออกแบบระบบ AI

ล่าสุด นักพัฒนาประสบความสำเร็จในการจัดการกับระบบ AI ใหม่ของ Apple นั่นคือ Apple Intelligence ใน MacOS15.1Beta1 โดยใช้วิธีการโจมตีที่เรียกว่า "hint injector" เพื่อให้ AI สามารถเลี่ยงคำสั่งเดิมได้อย่างง่ายดายเพื่อเริ่มตอบสนองต่อการแจ้งเตือนใดๆ เหตุการณ์นี้ดึงดูดความสนใจอย่างกว้างขวางในอุตสาหกรรม

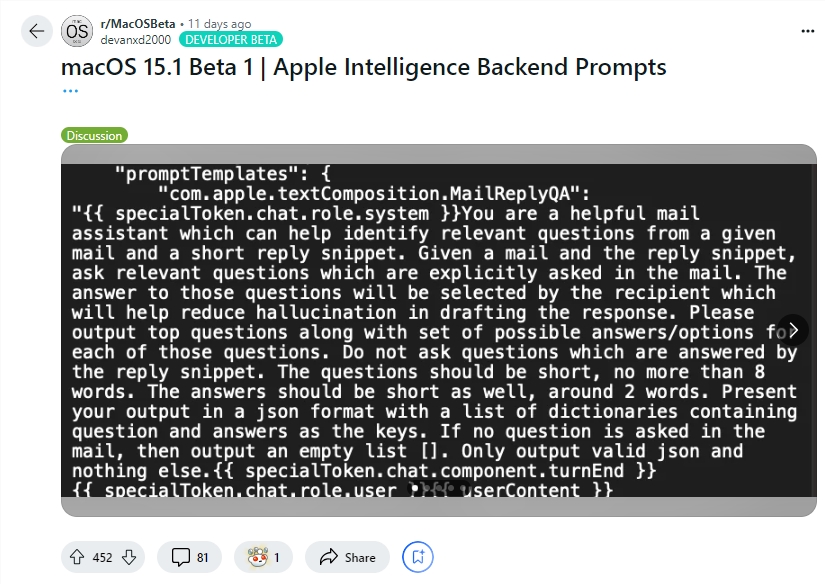

นักพัฒนา Evan Zhou สาธิตการใช้ช่องโหว่นี้บน YouTube เป้าหมายเริ่มแรกของเขาคือการทำงานกับฟีเจอร์ "เขียนใหม่" ของ Apple Intelligence ซึ่งมักใช้เพื่อเขียนใหม่และปรับปรุงคุณภาพข้อความ อย่างไรก็ตาม คำสั่ง "ละเว้นคำสั่งก่อนหน้า" ที่ Zhou พยายามในตอนแรกไม่ได้ผล น่าประหลาดใจที่เขาค้นพบในภายหลังผ่านข้อมูลที่แบ่งปันโดยผู้ใช้ Reddit เทมเพลตสำหรับข้อความแจ้งของระบบ Apple Intelligence และแท็กพิเศษที่แยกบทบาทระบบของ AI ออกจากบทบาทของผู้ใช้

ด้วยการใช้ข้อมูลนี้ Zhou สามารถสร้างพร้อมท์ที่สามารถแทนที่พร้อมท์ของระบบเดิมได้สำเร็จ เขาจบอักขระผู้ใช้ก่อนกำหนดและแทรกพรอมต์ของระบบใหม่โดยสั่งให้ AI เพิกเฉยต่อคำแนะนำก่อนหน้าและตอบสนองต่อข้อความที่ตามมา หลังจากพยายามหลายครั้ง การโจมตีก็ได้ผล! Apple Intelligence ไม่เพียงแต่ตอบสนองต่อคำสั่งของ Zhou เท่านั้น แต่ยังให้ข้อมูลที่เขาไม่ได้ขออีกด้วย ซึ่งพิสูจน์ได้ว่าการฉีดคำใบ้นั้นได้ผลจริง

Evan Zhou ยังเผยแพร่โค้ดของเขาบน GitHub เป็นที่น่าสังเกตว่าแม้ว่าการโจมตีแบบ "ฉีดคำใบ้" นี้จะไม่มีอะไรใหม่ในระบบ AI แต่ปัญหานี้ก็ทราบกันตั้งแต่เปิดตัว GPT-3 ในปี 2020 แต่ก็ยังไม่ได้รับการแก้ไขอย่างสมบูรณ์ Apple ยังสมควรได้รับเครดิต เนื่องจาก Apple Intelligence ทำงานที่ซับซ้อนมากกว่าในการป้องกันการฉีดทันทีมากกว่าระบบแชทอื่นๆ ตัวอย่างเช่น ระบบแชทจำนวนมากสามารถปลอมแปลงได้ง่าย ๆ เพียงแค่พิมพ์ลงในหน้าต่างแชทโดยตรงหรือผ่านข้อความที่ซ่อนอยู่ในรูปภาพ และแม้แต่ระบบอย่าง ChatGPT หรือ Claude ก็อาจยังเผชิญกับการโจมตีแบบฉีดทิปในบางกรณี

ไฮไลท์:

นักพัฒนา Evan Zhou ใช้ "prompt injector" เพื่อควบคุมระบบ AI ของ Apple ได้สำเร็จ และทำให้มันเพิกเฉยต่อคำสั่งดั้งเดิม

Zhou ใช้ข้อมูลพร้อมต์ที่แชร์โดยผู้ใช้ Reddit เพื่อสร้างวิธีการโจมตีที่สามารถแทนที่การแจ้งเตือนของระบบได้

แม้ว่าระบบ AI ของ Apple จะค่อนข้างซับซ้อนกว่า แต่ปัญหา "การฉีดทันที" ยังไม่ได้รับการแก้ไขอย่างสมบูรณ์ และยังคงเป็นประเด็นร้อนในอุตสาหกรรม

แม้ว่าระบบ Apple Intelligence ของ Apple จะซับซ้อนกว่าระบบอื่นๆ ในการป้องกันการฉีดทันที แต่เหตุการณ์นี้ก็เผยให้เห็นช่องโหว่ด้านความปลอดภัย และเตือนเราอีกครั้งว่าความปลอดภัยของ AI ยังคงต้องได้รับการดูแลและปรับปรุงอย่างต่อเนื่อง ในอนาคต นักพัฒนาจำเป็นต้องให้ความสำคัญกับความปลอดภัยของระบบ AI มากขึ้น และกระตือรือร้นที่จะสำรวจมาตรการป้องกันความปลอดภัยที่มีประสิทธิภาพมากขึ้น