ARC-AGI ซึ่งเป็นเกณฑ์มาตรฐานที่ออกแบบมาเพื่อประเมินความสามารถเชิงนามธรรมและการใช้เหตุผลของปัญญาประดิษฐ์ทั่วไป (AGI) มีความคืบหน้าเมื่อเร็วๆ นี้ แต่ Francois Cholet ผู้สร้าง เตือนเราว่านี่ไม่ได้หมายความว่า AGI กำลังใกล้เข้ามา เขาชี้ให้เห็นว่าประสิทธิภาพของระบบ AI ในปัจจุบันในการทดสอบ ARC-AGI ยังคงต่ำกว่าความคาดหมายอย่างมาก และเหตุผลหลักก็คือข้อจำกัดของโมเดลภาษาขนาดใหญ่ (LLM) ซึ่งสามารถจดจำรูปแบบได้ดีกว่าการใช้เหตุผลที่แท้จริง Sholay และผู้ร่วมงานของเขาเปิดตัวการแข่งขันมูลค่า 1 ล้านดอลลาร์เพื่อส่งเสริมความก้าวหน้าของ AI แบบโอเพ่นซอร์สใน ARC-AGI แต่ผลลัพธ์ยังยืนยันว่าการทดสอบอาจมีข้อบกพร่องและจำเป็นต้องปรับปรุงเพิ่มเติม

นับตั้งแต่เปิดตัวในปี 2562 ARC-AGI ได้รับความสนใจในด้านปัญญาประดิษฐ์ แม้ว่าระบบ AI จะมีความก้าวหน้าในการทดสอบบ้าง แต่คะแนนก็ยังต่ำกว่าระดับมนุษย์มาก สิ่งนี้กระตุ้นให้เกิดการพิจารณาทิศทางปัจจุบันของการพัฒนา AI และกระตุ้นให้นักวิจัยตรวจสอบคำจำกัดความและวิธีการประเมินของ AGI อีกครั้ง บทความนี้วิเคราะห์ข้อจำกัดของการทดสอบ ARC-AGI โดยละเอียด รวมถึงแนวโน้มสำหรับทิศทางการวิจัย AGI ในอนาคต และแสดงผลการแข่งขันที่เกี่ยวข้องและกลยุทธ์การรับมือของนักวิจัย

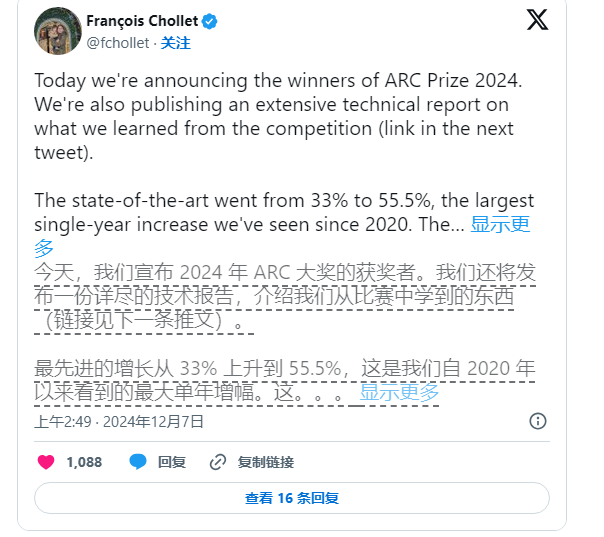

อย่างไรก็ตาม Sholay ยังไม่หยุดผลักดันการวิจัยด้าน AI เขาและ Mike Knoop ผู้ก่อตั้ง Zapier ร่วมกันเปิดตัวการแข่งขันมูลค่า 1 ล้านเหรียญสหรัฐในเดือนมิถุนายนปีนี้ เพื่อสนับสนุนให้ AI โอเพ่นซอร์สท้าทายเกณฑ์มาตรฐาน ARC-AGI แม้ว่าระบบ AI ที่มีประสิทธิภาพดีที่สุดจะได้คะแนนเพียง 55.5% จากทั้งหมด 17,789 รายการ แต่ต่ำกว่าคะแนน 85% ที่จำเป็นในการบรรลุ "ประสิทธิภาพของมนุษย์" แต่ Sholay และ Knoop ยังคงมองว่านี่เป็นก้าวสำคัญ

Knoop ชี้ให้เห็นในโพสต์บนบล็อกว่าความสำเร็จนี้ไม่ได้หมายความว่าเราใกล้จะตระหนักถึง AGI แล้ว แต่เป็นการเน้นย้ำว่างานบางอย่างใน ARC-AGI ต้องพึ่งพาโซลูชัน "กำลังดุร้าย" มากเกินไป และอาจไม่ได้ให้สัญญาณที่มีประสิทธิภาพสำหรับทั่วไปที่แท้จริง ปัญญา. เดิมที ARC-AGI ได้รับการออกแบบมาเพื่อทดสอบความสามารถทั่วไปของ AI โดยมอบงานที่ซับซ้อนและไม่เคยเห็นมาก่อน อย่างไรก็ตาม ยังคงมีข้อสงสัยว่างานเหล่านี้สามารถประเมิน AGI ได้อย่างมีประสิทธิภาพหรือไม่

หมายเหตุแหล่งที่มาของรูปภาพ: รูปภาพนี้สร้างขึ้นโดย AI และรูปภาพนั้นได้รับอนุญาตจากผู้ให้บริการ Midjourney

งานในเกณฑ์มาตรฐาน ARC-AGI เกี่ยวข้องกับปัญหาปริศนา ฯลฯ ซึ่งต้องใช้ AI เพื่ออนุมานคำตอบที่ไม่รู้จักตามข้อมูลที่ทราบ แม้ว่างานเหล่านี้ดูเหมือนจะส่งเสริมการปรับตัวของ AI ให้เข้ากับสถานการณ์ใหม่ แต่ผลลัพธ์แสดงให้เห็นว่าแบบจำลองที่มีอยู่ดูเหมือนจะค้นหาวิธีแก้ปัญหาผ่านการคำนวณจำนวนมาก และไม่จำเป็นต้องแสดงให้เห็นถึงความสามารถในการปรับตัวอย่างชาญฉลาดอย่างแท้จริง

นอกจากนี้ ผู้สร้าง ARC-AGI ยังต้องเผชิญกับคำวิจารณ์จากเพื่อนร่วมงาน โดยเฉพาะอย่างยิ่งเกี่ยวกับความคลุมเครือเกี่ยวกับคำจำกัดความของ AGI พนักงานของ OpenAI กล่าวเมื่อเร็วๆ นี้ว่าหาก AGI ถูกกำหนดให้เป็นปัญญาประดิษฐ์ที่ "ทำงานได้ดีกว่ามนุษย์ส่วนใหญ่ในงานส่วนใหญ่" แสดงว่า AGI ก็บรรลุผลสำเร็จแล้ว อย่างไรก็ตาม Cholet และ Knoop โต้แย้งว่าการออกแบบที่มีอยู่สำหรับเกณฑ์มาตรฐาน ARC-AGI ยังไม่บรรลุเป้าหมายนี้อย่างเต็มที่

นับจากนี้ไป Sholay และ Knoop วางแผนที่จะเปิดตัวเกณฑ์มาตรฐาน ARC-AGI รุ่นที่สอง และจะจัดการแข่งขันใหม่ในปี 2568 เพื่อแก้ไขข้อบกพร่องในการทดสอบปัจจุบัน พวกเขากล่าวว่าเกณฑ์มาตรฐานใหม่จะเน้นไปที่การส่งเสริมการพัฒนาการวิจัย AI ในทิศทางที่สำคัญยิ่งขึ้น และเร่งการนำ AGI ไปใช้

อย่างไรก็ตาม การแก้ไขเกณฑ์มาตรฐานที่มีอยู่ไม่ใช่เรื่องง่าย ความพยายามของ Sholay และ Knoop แสดงให้เห็นว่าการกำหนดความฉลาดในปัญญาประดิษฐ์ โดยเฉพาะอย่างยิ่งในด้านสติปัญญาทั่วไป ยังคงเป็นงานที่ยากและซับซ้อน

โดยรวมแล้ว ความคืบหน้าของเกณฑ์มาตรฐาน ARC-AGI และการอภิปรายที่เกี่ยวข้อง สะท้อนให้เห็นว่าการสำรวจปัญญาประดิษฐ์ทั่วไปในสาขาปัญญาประดิษฐ์ยังคงดำเนินต่อไป โดยมีทั้งความก้าวหน้าและความท้าทาย ในอนาคต คำจำกัดความที่เข้มงวดยิ่งขึ้นและการประเมินที่มีประสิทธิภาพมากขึ้น จำเป็นต้องมีวิธีการส่งเสริมการพัฒนา AGI อย่างแท้จริง