โมเดล AI o-series ล่าสุดของ OpenAI ได้รับการออกแบบมาเพื่อปรับปรุงความปลอดภัยของระบบ AI ผ่านการทำความเข้าใจกฎและความสามารถในการใช้เหตุผลอย่างลึกซึ้งยิ่งขึ้น แตกต่างจากการอาศัยตัวอย่างการเรียนรู้ในอดีตเพียงอย่างเดียว โมเดลนี้สามารถเข้าใจเชิงรุกและใช้แนวทางด้านความปลอดภัยเพื่อบล็อกคำขอที่เป็นอันตรายได้อย่างมีประสิทธิภาพ บทความนี้ให้รายละเอียดเกี่ยวกับกระบวนการฝึกอบรมสามขั้นตอนของโมเดล o1 และประสิทธิภาพที่เหนือกว่าระบบ AI ทั่วไปอื่นๆ ในการทดสอบความปลอดภัย อย่างไรก็ตาม แม้จะมีโมเดล o1 ที่ได้รับการปรับปรุง แต่ก็ยังมีความเป็นไปได้ที่จะถูกจัดการ ซึ่งเน้นย้ำถึงความท้าทายอย่างต่อเนื่องในด้านความปลอดภัยของ AI

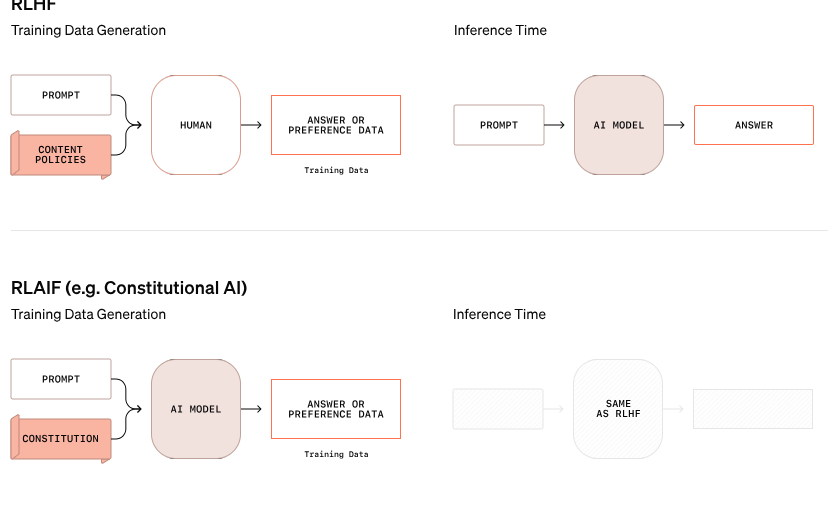

OpenAI ได้ประกาศแนวทางใหม่ในการรักษาความปลอดภัยของ AI โดยมีจุดมุ่งหมายเพื่อปรับปรุงความปลอดภัยของระบบ AI โดยการเปลี่ยนวิธีจัดการกับกฎความปลอดภัย โมเดล O-Series ใหม่นี้ไม่ได้อาศัยการเรียนรู้พฤติกรรมที่ดีและไม่ดีจากตัวอย่างเพียงอย่างเดียวอีกต่อไป แต่สามารถเข้าใจและให้เหตุผลอย่างกระตือรือร้นเกี่ยวกับหลักเกณฑ์ด้านความปลอดภัยที่เฉพาะเจาะจงได้

ในตัวอย่างหนึ่งจากการวิจัยของ OpenAI เมื่อผู้ใช้พยายามรับคำแนะนำสำหรับกิจกรรมที่ผิดกฎหมายผ่านข้อความที่เข้ารหัส โมเดลจะถอดรหัสข้อมูลได้สำเร็จ แต่ปฏิเสธคำขอ โดยอ้างถึงกฎความปลอดภัยที่จะถูกละเมิดโดยเฉพาะ กระบวนการให้เหตุผลทีละขั้นตอนนี้แสดงให้เห็นว่าแบบจำลองปฏิบัติตามแนวทางด้านความปลอดภัยที่เกี่ยวข้องได้อย่างมีประสิทธิภาพเพียงใด

กระบวนการฝึกอบรมของโมเดล o1 นี้แบ่งออกเป็นสามขั้นตอน ขั้นแรก โมเดลจะเรียนรู้วิธีช่วยเหลือ ถัดไป แบบจำลองจะศึกษาหลักเกณฑ์ด้านความปลอดภัยเฉพาะผ่านการเรียนรู้แบบมีผู้สอน สุดท้าย โมเดลจะใช้การเรียนรู้แบบเสริมกำลังเพื่อฝึกฝนการใช้กฎเหล่านี้ ซึ่งเป็นขั้นตอนที่ช่วยให้โมเดลเข้าใจและปรับใช้แนวทางด้านความปลอดภัยเหล่านี้ได้อย่างแท้จริง

ในการทดสอบของ OpenAI โมเดล o1 ที่เพิ่งเปิดตัวใหม่ทำงานได้ดีกว่าระบบทั่วไปอื่นๆ อย่างมากในแง่ของความปลอดภัย เช่น GPT-4o, Claude3.5Sonnet และ Gemini1.5Pro การทดสอบซึ่งรวมถึงความสามารถในการปฏิเสธคำขอที่เป็นอันตรายและอนุญาตให้คำขอที่เหมาะสมผ่านได้ แสดงให้เห็นว่าโมเดล o1 ได้คะแนนสูงสุดในด้านความแม่นยำและการต้านทานต่อการพยายามเจลเบรก

Wojciech Zaremba ผู้ร่วมก่อตั้ง OpenAI กล่าวบนแพลตฟอร์มโซเชียลว่าเขาภูมิใจมากกับงาน "การจัดตำแหน่งที่รอบคอบ" และเชื่อว่าโมเดลการให้เหตุผลประเภทนี้สามารถจัดวางได้ในรูปแบบใหม่โดยสิ้นเชิง โดยเฉพาะอย่างยิ่งในการพัฒนาปัญญาประดิษฐ์ทั่วไป (AGI) การรับรองว่าระบบสอดคล้องกับค่านิยมของมนุษย์ถือเป็นความท้าทายที่สำคัญ

แม้ว่า OpenAI จะอ้างว่ามีความคืบหน้า แต่แฮ็กเกอร์ชื่อ "Pliny the Liberator" แสดงให้เห็นว่าแม้แต่โมเดล o1 และ o1-Pro ใหม่ก็สามารถจัดการเพื่อละเมิดหลักเกณฑ์ด้านความปลอดภัยได้ Pliny ประสบความสำเร็จในการสร้างโมเดลเพื่อสร้างเนื้อหาสำหรับผู้ใหญ่ และแบ่งปันคำแนะนำในการทำโมโลตอฟค็อกเทล แม้ว่าในตอนแรกระบบจะปฏิเสธคำขอเหล่านี้ก็ตาม เหตุการณ์เหล่านี้เน้นย้ำถึงความยากลำบากในการควบคุมระบบ AI ที่ซับซ้อนเหล่านี้ เนื่องจากระบบทำงานบนพื้นฐานของความน่าจะเป็นมากกว่ากฎเกณฑ์ที่เข้มงวด

Zaremba กล่าวว่า OpenAI มีพนักงานประมาณ 100 คนที่ทุ่มเทให้กับความปลอดภัยของ AI และความสอดคล้องกับค่านิยมของมนุษย์ เขาตั้งคำถามเกี่ยวกับแนวทางการรักษาความปลอดภัยของคู่แข่ง โดยเฉพาะอย่างยิ่ง xAI ของ Elon Musk ซึ่งให้ความสำคัญกับการเติบโตของตลาดมากกว่ามาตรการรักษาความปลอดภัย และ Anthropic ซึ่งเพิ่งเปิดตัวตัวแทน AI โดยไม่มีการป้องกันที่เหมาะสม Zaremba เชื่อว่าสิ่งนี้จะนำ "ผลตอบรับเชิงลบจำนวนมาก" มาสู่ OpenAI

บล็อกอย่างเป็นทางการ: https://openai.com/index/deliberative-alignment/

ไฮไลท์:

โมเดล o-series ใหม่ของ OpenAI สามารถให้เหตุผลเชิงรุกเกี่ยวกับกฎความปลอดภัยและปรับปรุงความปลอดภัยของระบบ

โมเดล o1 มีประสิทธิภาพเหนือกว่าระบบ AI กระแสหลักอื่นๆ ในการปฏิเสธคำขอที่เป็นอันตรายและความแม่นยำ

แม้จะมีการปรับปรุง แต่โมเดลใหม่ยังคงสามารถจัดการได้ และความท้าทายด้านความปลอดภัยยังคงมีความรุนแรง

โดยรวมแล้ว โมเดล o-series ของ OpenAI มีความก้าวหน้าอย่างมากในด้านความปลอดภัยของ AI แต่ยังได้สัมผัสกับความซับซ้อนและความท้าทายอย่างต่อเนื่องของการรักษาความปลอดภัยโมเดลภาษาขนาดใหญ่ด้วย จะต้องทุ่มความพยายามมากขึ้นต่อไปในอนาคตเพื่อจัดการกับความเสี่ยงด้านความปลอดภัยของ AI ได้อย่างแท้จริงและมีประสิทธิภาพ