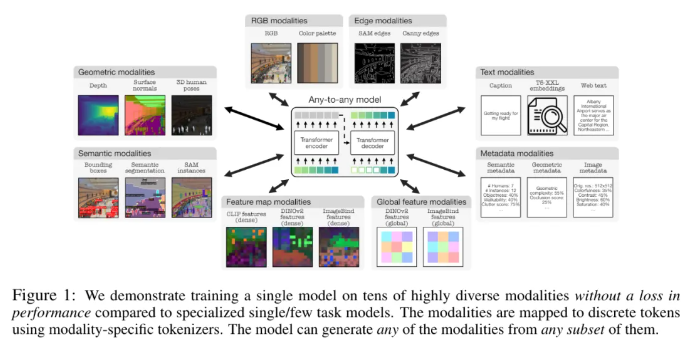

Apple และ Ecole Polytechnique Fédérale de Lausanne (EPFL) ในสวิตเซอร์แลนด์ได้ร่วมมือกันพัฒนาโมเดลมัลติโมดัลสุดล้ำ 4M-21 โมเดลนี้สามารถฝึกได้ 21 รูปแบบที่แตกต่างกัน โดยมีประสิทธิภาพดีกว่ารุ่นที่มีอยู่อย่างเห็นได้ชัด และมีฟังก์ชันต่างๆ มากมาย เช่น การดึงข้อมูลแบบข้ามโมดัลและการสร้างที่ควบคุมได้ งานวิจัยนี้ปรับปรุงประสิทธิภาพและความสามารถในการปรับตัวของแบบจำลองได้อย่างมาก โดยการขยายแบบจำลองและขนาดชุดข้อมูล เพิ่มประเภทและจำนวนรูปแบบการฝึกอบรม และการนำกลยุทธ์การฝึกอบรมร่วมมาใช้ โมเดล 4M-21 ใช้สถาปัตยกรรมตัวเข้ารหัส-ตัวถอดรหัสที่ใช้ Transformer และเพิ่มการฝังโมดอลเพิ่มเติมเพื่อปรับให้เข้ากับรูปแบบใหม่ กระบวนการฝึกอบรมจะพิจารณาคุณลักษณะของรูปแบบที่แตกต่างกันอย่างเต็มที่ และใช้วิธีการโทเค็นไนเซชันเฉพาะสำหรับโมดอล

การศึกษานี้นำโซลูชันก่อนการฝึกอบรม 4M มาใช้ ซึ่งสามารถปรับปรุงประสิทธิภาพและความสามารถในการปรับตัวของแบบจำลองโดยการขยายขนาดของแบบจำลองและชุดข้อมูล เพิ่มประเภทและจำนวนรูปแบบที่เกี่ยวข้องกับการฝึกอบรมแบบจำลอง และดำเนินการฝึกอบรมร่วมกันในหลาย ๆ ชุดข้อมูล นักวิจัยใช้วิธีการสร้างโทเค็นที่แตกต่างกันเพื่อแยกแยะรูปแบบด้วยคุณสมบัติที่แตกต่างกัน เช่น การฝังภาพทั่วโลก ท่าทางของมนุษย์ และอินสแตนซ์เชิงความหมาย ในแง่ของการเลือกสถาปัตยกรรม การศึกษานี้ใช้สถาปัตยกรรมตัวเข้ารหัส-ตัวถอดรหัส 4M ที่ใช้ Transformer และเพิ่มการฝังโมดอลเพิ่มเติมเพื่อปรับให้เข้ากับรูปแบบใหม่

โมเดลนี้ไม่เพียงแต่สามารถทำงานด้านการมองเห็นทั่วไปหลายชุดนอกกรอบได้ เช่น การประมาณค่าพื้นผิวปกติและความลึกของ DIODE, การแบ่งส่วนความหมายและอินสแตนซ์ของ COCO, การประมาณท่าทางของมนุษย์ด้วย 3DPW3D เป็นต้น นอกจากนี้ยังสามารถสร้างรูปแบบการฝึกอบรมตามอำเภอใจและรองรับหลายรูปแบบ มีการดำเนินการสร้างแบบละเอียดและหลายรูปแบบ และสามารถดึงข้อมูลภาพ RGB หรือรูปแบบอื่น ๆ ได้โดยใช้รูปแบบอื่นเป็นแบบสอบถาม นอกจากนี้ นักวิจัยยังได้ทำการทดลองการส่งสัญญาณหลายรูปแบบบน NYUv2, การแบ่งส่วนความหมายแบบ Hypersim และ ARKitScenes

คุณสมบัติการทำงานที่สำคัญ ได้แก่ :

รูปแบบใดๆ ต่อใดๆ: เพิ่มจาก 7 รูปแบบของแบบจำลองใดๆ ต่อใดๆ ที่ดีที่สุดที่มีอยู่เป็น 21 รูปแบบที่แตกต่างกัน ช่วยให้สามารถดึงข้อมูลข้ามโมดัล การสร้างที่ควบคุมได้ และประสิทธิภาพการทำงานนอกกรอบที่ทรงพลัง

การสนับสนุนความหลากหลาย: เพิ่มการสนับสนุนสำหรับข้อมูลที่มีโครงสร้างมากขึ้น เช่น ท่าทางของมนุษย์, อินสแตนซ์ SAM, ข้อมูลเมตา และอื่นๆ

การทำให้เป็นโทเค็น: ศึกษาการใช้โทเค็นแบบแยกส่วนสำหรับวิธีการต่างๆ โดยใช้วิธีการเฉพาะของโมดาลลิตี เช่น การฝังภาพทั่วโลก ท่าทางของมนุษย์ และอินสแตนซ์เชิงความหมาย

การปรับขนาด: ขยายขนาดโมเดลเป็นพารามิเตอร์ 3B และชุดข้อมูลเป็น 0.5B ตัวอย่าง

การฝึกอบรมการทำงานร่วมกัน: การฝึกอบรมการทำงานร่วมกันเกี่ยวกับการมองเห็นและภาษาในเวลาเดียวกัน

ที่อยู่กระดาษ: https://arxiv.org/pdf/2406.09406

ไฮไลท์:

- นักวิจัยจาก Apple และ Ecole Polytechnique Fédérale de Lausanne (EPFL) ในสวิตเซอร์แลนด์ได้ร่วมกันพัฒนาแบบจำลองรูปแบบใดก็ได้ต่อรูปแบบเดียว ซึ่งสามารถฝึกอบรมในรูปแบบที่แตกต่างกัน 21 รูปแบบ

- โมเดลสามารถทำงานเกี่ยวกับการมองเห็นทั่วไปได้หลากหลายตั้งแต่แกะกล่อง และยังสามารถสร้างรูปแบบการฝึกอบรมตามอำเภอใจ ซึ่งสนับสนุนวิธีการต่างๆ มากมายในการสร้างแบบละเอียดและหลายรูปแบบ

- นักวิจัยยังได้ทำการทดลองการส่งสัญญาณหลายรูปแบบบน NYUv2, การแบ่งส่วนความหมายแบบ Hypersim และ ARKitScenes

โดยรวมแล้ว โมเดล 4M-21 มีความก้าวหน้าอย่างมากในด้านการวิจัยหลายรูปแบบ ประสิทธิภาพอันทรงพลังและโอกาสในการนำไปใช้งานในวงกว้าง ถือเป็นทิศทางใหม่สำหรับการพัฒนาปัญญาประดิษฐ์หลายรูปแบบในอนาคต โอเพ่นซอร์สและแอปพลิเคชันในอนาคตของรุ่นนี้คุ้มค่าที่จะรอคอย