ทีมวิจัยจากมหาวิทยาลัยหนานจิง มหาวิทยาลัยฟู่ตัน และห้องปฏิบัติการเรือโนอาห์ของหัวเว่ย ได้สร้างความก้าวหน้าครั้งสำคัญในด้านมนุษย์ดิจิทัล 3 มิติ โดยแก้ปัญหาความสอดคล้องหลายมุมมองที่ไม่เพียงพอและการแสดงออกทางอารมณ์ในวิธีการที่มีอยู่ พวกเขาได้พัฒนาวิธีการใหม่ที่ช่วยให้สามารถสังเคราะห์อวาตาร์พูดได้ 3 มิติด้วยอารมณ์ที่ควบคุมได้ และได้รับการปรับปรุงที่สำคัญในการซิงโครไนซ์ริมฝีปากและคุณภาพการเรนเดอร์ ผลการวิจัยขึ้นอยู่กับชุดข้อมูล EmoTalk3D ที่สร้างขึ้นใหม่ ซึ่งประกอบด้วยวิดีโอหลายมุมมองที่ได้รับการปรับเทียบ คำอธิบายประกอบทางอารมณ์ และข้อมูลเรขาคณิต 3 มิติแบบเฟรมต่อเฟรม และได้รับการเผยแพร่สู่สาธารณะเพื่อใช้ในการวิจัยที่ไม่ใช่เชิงพาณิชย์ ด้วยกรอบการแมป "จากคำพูด เรขาคณิต ไปจนถึงรูปลักษณ์" วิธีการนี้สามารถจับภาพการแสดงออกทางสีหน้าที่ละเอียดอ่อนได้อย่างแม่นยำ และให้การเรนเดอร์ที่มีความเที่ยงตรงสูงภายใต้มุมมองที่อิสระ

ทางเข้าผลิตภัณฑ์: https://nju-3dv.github.io/projects/EmoTalk3D/

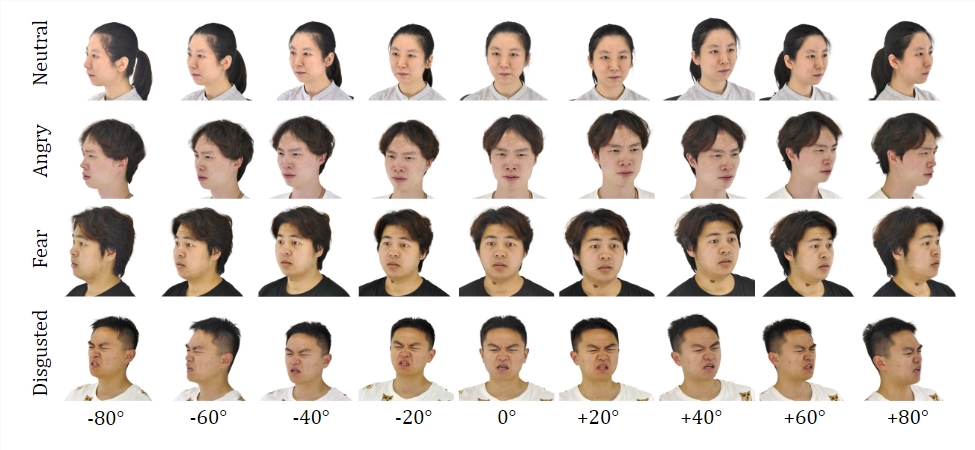

พวกเขารวบรวมชุดข้อมูล EmoTalk3D ด้วยวิดีโอหลายมุมมองที่ปรับเทียบแล้ว คำอธิบายประกอบทางอารมณ์ และเรขาคณิต 3 มิติแบบเฟรมต่อเฟรม และมีการเสนอวิธีการใหม่ในการสังเคราะห์อวาตาร์พูด 3 มิติด้วยอารมณ์ที่ควบคุมได้ พร้อมด้วยการปรับปรุงที่สำคัญในการซิงโครไนซ์ริมฝีปากและคุณภาพการเรนเดอร์

ชุดข้อมูล:

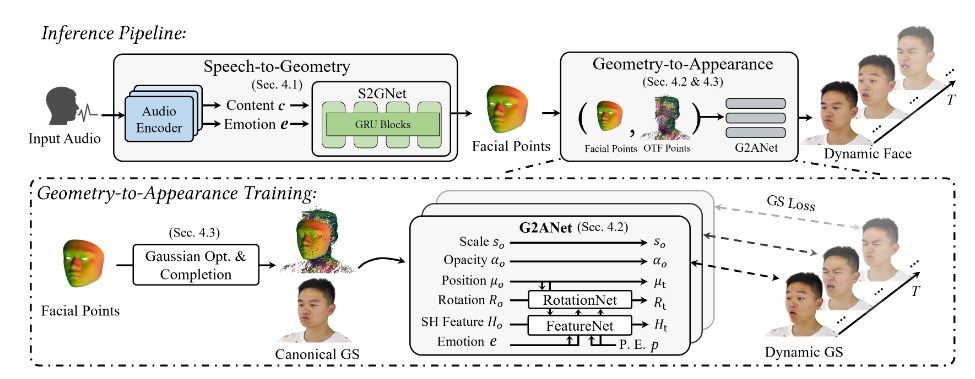

ด้วยการฝึกอบรมชุดข้อมูล EmoTalk3D ทีมวิจัยได้สร้างกรอบงานการทำแผนที่ "จากคำพูด เรขาคณิต ไปจนถึงรูปลักษณ์" ลำดับเรขาคณิต 3 มิติที่เหมือนจริงนั้นจะถูกคาดการณ์จากคุณสมบัติด้านเสียงก่อน จากนั้นลักษณะที่ปรากฏของหัวพูด 3 มิติที่แสดงโดย 4D Gaussian จะถูกสังเคราะห์ตามเรขาคณิตที่คาดการณ์ไว้ ลักษณะที่ปรากฏจะถูกแบ่งย่อยเพิ่มเติมเป็นแบบเกาส์เซียนแบบมาตรฐานและไดนามิก เรียนรู้จากวิดีโอแบบหลายมุมมอง และหลอมรวมกันเพื่อแสดงแอนิเมชั่นหัวพูดแบบดูฟรี

แบบจำลองนี้ช่วยให้ควบคุมอารมณ์ได้ในรูปอวาตาร์พูดที่สร้างขึ้น และแสดงผลในมุมมองที่หลากหลาย แสดงให้เห็นถึงคุณภาพการเรนเดอร์ที่ดีขึ้นและความเสถียรในการสร้างการเคลื่อนไหวของริมฝีปาก ขณะเดียวกันก็บันทึกรายละเอียดใบหน้าแบบไดนามิก เช่น ริ้วรอยและการแสดงออกทางสีหน้าที่ละเอียดอ่อน ในตัวอย่างของผลลัพธ์ที่สร้างขึ้น การแสดงออกที่มีความสุข โกรธ และหงุดหงิดของมนุษย์ดิจิทัล 3 มิติจะถูกแสดงอย่างถูกต้อง

กระบวนการโดยรวมประกอบด้วยห้าโมดูล:

อย่างแรกคือตัวเข้ารหัสการสลายตัวของเนื้อหาทางอารมณ์ ซึ่งจะแยกวิเคราะห์เนื้อหาและคุณลักษณะทางอารมณ์จากคำพูดอินพุต ส่วนที่สองคือเครือข่ายคำพูดต่อเรขาคณิต ซึ่งคาดการณ์คลาวด์พอยต์ 3 มิติแบบไดนามิกจากฟีเจอร์ที่สามคือการเพิ่มประสิทธิภาพแบบเกาส์เซียนและโมดูลการทำให้เสร็จสมบูรณ์ ลักษณะมาตรฐาน ประการที่สี่คือรูปทรงเรขาคณิตต่อลักษณะที่ปรากฏ เครือข่ายสังเคราะห์ลักษณะใบหน้าตามไดนามิกพอยต์คลาวด์ ประการที่ห้าคือโมดูลการเรนเดอร์ ซึ่งทำให้ไดนามิกเกาส์เซียนกลายเป็นแอนิเมชั่นแบบดูฟรี

นอกจากนี้ พวกเขายังสร้างชุดข้อมูล EmoTalk3D ซึ่งเป็นชุดข้อมูลหัวพูดหลายมุมมองพร้อมคำอธิบายประกอบตามอารมณ์พร้อมรูปทรงใบหน้า 3 มิติแบบเฟรมต่อเฟรม ซึ่งจะเผยแพร่ต่อสาธารณะเพื่อวัตถุประสงค์ในการวิจัยที่ไม่ใช่เชิงพาณิชย์

ไฮไลท์:

เสนอวิธีการใหม่ในการสังเคราะห์มนุษย์ดิจิทัลด้วยอารมณ์ที่ควบคุมได้

สร้างกรอบการทำแผนที่ “จากคำพูด เรขาคณิต ไปจนถึงรูปลักษณ์”

ชุดข้อมูล EmoTalk3D ถูกสร้างขึ้นและพร้อมที่จะเปิด

การวิจัยครั้งนี้เป็นแนวทางใหม่สำหรับการพัฒนาเทคโนโลยีดิจิทัลของมนุษย์ 3 มิติ วิธีการและชุดข้อมูลที่เสนอจะเป็นแหล่งทรัพยากรที่มีคุณค่าสำหรับการวิจัยในอนาคต และส่งเสริมการพัฒนาเทคโนโลยีดิจิทัลของมนุษย์ 3 มิติที่สมจริงและแสดงออกทางอารมณ์มากขึ้น การเปิดชุดข้อมูล EmoTalk3D ยังส่งเสริมความร่วมมือและการแลกเปลี่ยนในชุมชนวิชาการ