เมื่อเร็วๆ นี้ Meta ได้เปิดตัวผลการวิจัย AI หลัก 6 รายการอย่างเงียบๆ ครอบคลุมหลายสาขา เช่น โมเดลหลายรูปแบบ เพลงที่สร้างข้อความ เทคโนโลยีลายน้ำเสียง และชุดข้อมูล ซึ่งแสดงให้เห็นถึงนวัตกรรมที่ต่อเนื่องและความแข็งแกร่งทางเทคนิคในด้านปัญญาประดิษฐ์ ผลการวิจัยเหล่านี้ไม่เพียงแต่มอบความเป็นไปได้ใหม่ๆ สำหรับการใช้งานในด้าน AI เท่านั้น แต่ยังเป็นแหล่งอ้างอิงที่มีคุณค่าสำหรับทิศทางการพัฒนาเทคโนโลยีในอนาคตอีกด้วย ผลการวิจัยที่น่าประทับใจเหล่านี้มีรายละเอียดดังนี้

เมื่อเร็วๆ นี้ Meta เปิดเผยผลการวิจัย 6 รายการอย่างเงียบๆ โดยนำแอปพลิเคชันใหม่ๆ และความก้าวหน้าทางเทคโนโลยีมาสู่สาขา AI ซึ่งรวมถึงโมเดลหลายรูปแบบ โมเดลเพลงที่สร้างข้อความ เทคโนโลยีลายน้ำเสียง ชุดข้อมูล และโครงการอื่น ๆ มาดูผลลัพธ์เฉพาะของการศึกษาเหล่านี้กันดีกว่า

เมต้า กิ้งก่า (โมเดล "กิ้งก่า")

ประการแรก รุ่นมัลติโมดัลที่เปิดตัว "Chameleon" สามารถประมวลผลข้อความและรูปภาพได้ในเวลาเดียวกัน รองรับข้อความอินพุตและเอาท์พุตแบบผสม และมอบโซลูชันใหม่สำหรับการประมวลผลข้อมูลหลายโมดัล

ในขณะที่โมเดลฟิวชั่นระยะสุดท้ายส่วนใหญ่ใช้การเรียนรู้แบบกระจาย แต่ Meta Chameleon ใช้โทเค็นสำหรับข้อความและรูปภาพ ซึ่งช่วยให้มีแนวทางที่เป็นหนึ่งเดียวมากขึ้น และทำให้การออกแบบ บำรุงรักษา และขยายโมเดลง่ายขึ้น

ตัวอย่างวิดีโอ: สร้างชื่อเรื่องที่สร้างสรรค์จากรูปภาพ หรือใช้ข้อความและรูปภาพผสมกันเพื่อสร้างฉากใหม่ทั้งหมด

ขณะนี้ Meta จะเผยแพร่ส่วนประกอบสำคัญของรุ่น Chameleon7B และ 34B ต่อสาธารณะภายใต้ใบอนุญาตการวิจัย รุ่นที่เปิดตัวในปัจจุบันมีการปรับความปลอดภัย รองรับอินพุตโหมดผสมและเอาต์พุตข้อความธรรมดา และสามารถใช้เพื่อวัตถุประสงค์ในการวิจัย อย่างเป็นทางการย้ำว่าโมเดลการสร้างภาพ Chameleon จะไม่ออกวางจำหน่าย

ทางเข้าผลิตภัณฑ์: https://top.aibase.com/tool/meta-chameleon

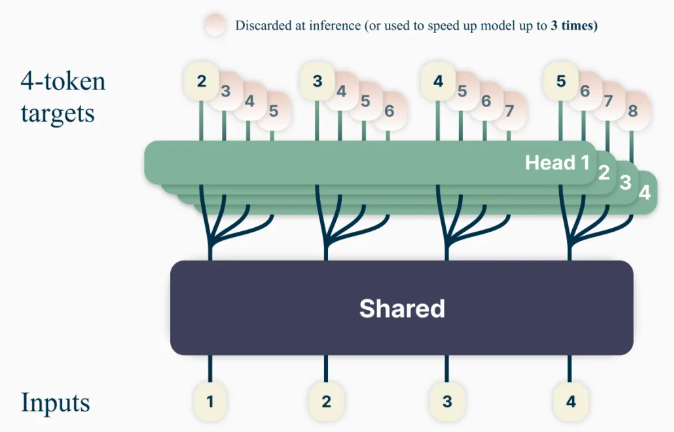

การทำนายหลายโทเค็น

วิธีการฝึกอบรมโมเดลภาษาใหม่ "การทำนายโทเค็นหลายรายการ" มีวัตถุประสงค์เพื่อปรับปรุงความสามารถของโมเดลและประสิทธิภาพการฝึกอบรม โดยจะฝึกโมเดลให้คาดเดาคำหลายคำในแต่ละครั้ง เพื่อปรับปรุงความแม่นยำในการทำนายของโมเดล

เมื่อใช้วิธีการนี้ โมเดลภาษาสามารถได้รับการฝึกฝนให้ทำนายคำในอนาคตหลายคำพร้อมกัน แทนที่จะใช้วิธีทำนายคำเดียวในแต่ละครั้งก่อนหน้านี้ สิ่งนี้จะปรับปรุงความสามารถของโมเดลและประสิทธิภาพการฝึกในขณะที่เพิ่มความเร็ว ด้วยจิตวิญญาณของวิทยาศาสตร์แบบเปิดที่มีความรับผิดชอบ โมเดลที่ได้รับการฝึกอบรมล่วงหน้าจะถูกปล่อยออกมาเพื่อให้โค้ดสมบูรณ์ภายใต้ใบอนุญาตที่ไม่ใช่เชิงพาณิชย์/เพื่อการวิจัยเท่านั้น

ทางเข้าผลิตภัณฑ์: https://top.aibase.com/tool/multi-token-prediction

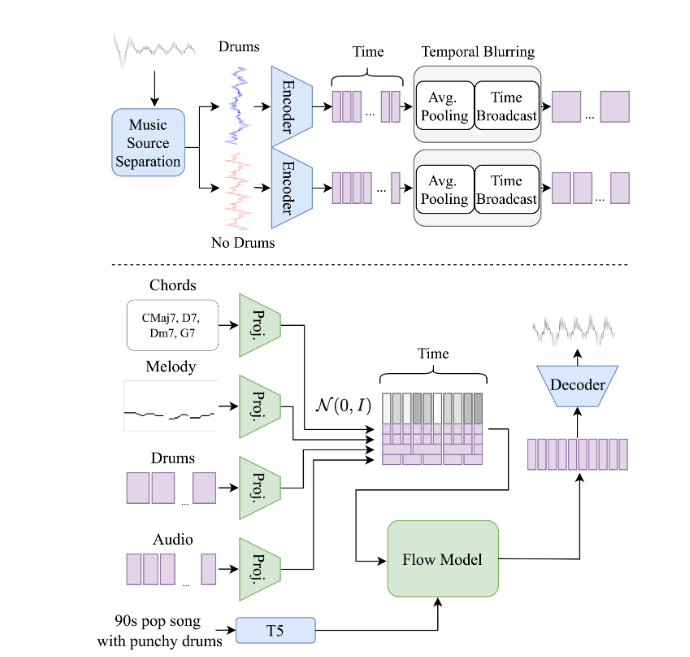

โมเดลเพลงสร้างข้อความ "JASCO"

ในขณะที่โมเดลการแปลงข้อความเป็นเพลงที่มีอยู่ เช่น MusicGen อาศัยการป้อนข้อความเพื่อสร้างเพลงเป็นหลัก แต่โมเดลใหม่ของ Meta คือ Meta-Joint Audio และ Symbol Conditioning สำหรับการสร้างข้อความเป็นเพลงที่ควบคุมชั่วคราว (JASCO) สามารถยอมรับความหลากหลายได้ ของเงื่อนไข อินพุต เช่น คอร์ดหรือจังหวะเฉพาะ เพื่อปรับปรุงการควบคุมเอาท์พุตดนตรีที่เป็นผลลัพธ์ โดยเฉพาะอย่างยิ่ง ชั้นคอขวดของข้อมูลสามารถใช้ร่วมกับความคลุมเครือชั่วคราวเพื่อดึงข้อมูลที่เกี่ยวข้องกับการควบคุมเฉพาะได้ ซึ่งช่วยให้สามารถรวมเงื่อนไขเชิงสัญลักษณ์และเงื่อนไขเสียงได้พร้อมกันในรูปแบบการสร้างข้อความเป็นเพลงเดียวกัน

JASCO เทียบเคียงได้กับเกณฑ์พื้นฐานการประเมินในแง่ของคุณภาพการสร้าง ขณะเดียวกันก็ช่วยให้ควบคุมเพลงที่สร้างขึ้นได้ดีขึ้นและยืดหยุ่นมากขึ้น เจ้าหน้าที่จะเผยแพร่รายงานการวิจัยและหน้าตัวอย่าง และปลายเดือนนี้รหัสการอนุมานจะถูกเผยแพร่โดยเป็นส่วนหนึ่งของพื้นที่เก็บข้อมูล AudioCraft ภายใต้ใบอนุญาต MIT และโมเดลที่ได้รับการฝึกอบรมล่วงหน้าจะเผยแพร่ภายใต้ CC-BY-NC

ทางเข้ารหัส: https://top.aibase.com/tool/audiocraft

เทคโนโลยีลายน้ำเสียง "AudioSeal"

นี่เป็นเทคโนโลยีลายน้ำเสียงตัวแรกที่ออกแบบมาโดยเฉพาะสำหรับการตรวจจับคำพูดที่สร้างโดย AI ในท้องถิ่น ช่วยให้สามารถระบุตำแหน่งส่วนที่สร้างโดย AI ภายในคลิปเสียงที่ยาวขึ้นได้อย่างแม่นยำ AudioSeal ปรับปรุงลายน้ำเสียงแบบเดิมโดยมุ่งเน้นไปที่การตรวจจับเนื้อหาที่สร้างโดย AI มากกว่าการซ่อนเร้น

แตกต่างจากวิธีการทั่วไปที่ต้องอาศัยอัลกอริธึมการถอดรหัสที่ซับซ้อน วิธีการตรวจจับภายในของ AudioSeal ช่วยให้การตรวจจับรวดเร็วและมีประสิทธิภาพมากขึ้น การออกแบบนี้ปรับปรุงความเร็วในการตรวจจับได้ 485 เท่าเมื่อเทียบกับวิธีการก่อนหน้านี้ ทำให้เหมาะสำหรับการใช้งานขนาดใหญ่และแบบเรียลไทม์ วิธีการของเราทำให้ได้ประสิทธิภาพที่ล้ำสมัยในแง่ของความทนทานและความมองไม่เห็นของลายน้ำเสียง

AudioSeal ได้รับการเผยแพร่ภายใต้ใบอนุญาตเชิงพาณิชย์

ทางเข้าผลิตภัณฑ์: https://top.aibase.com/tool/audioseal

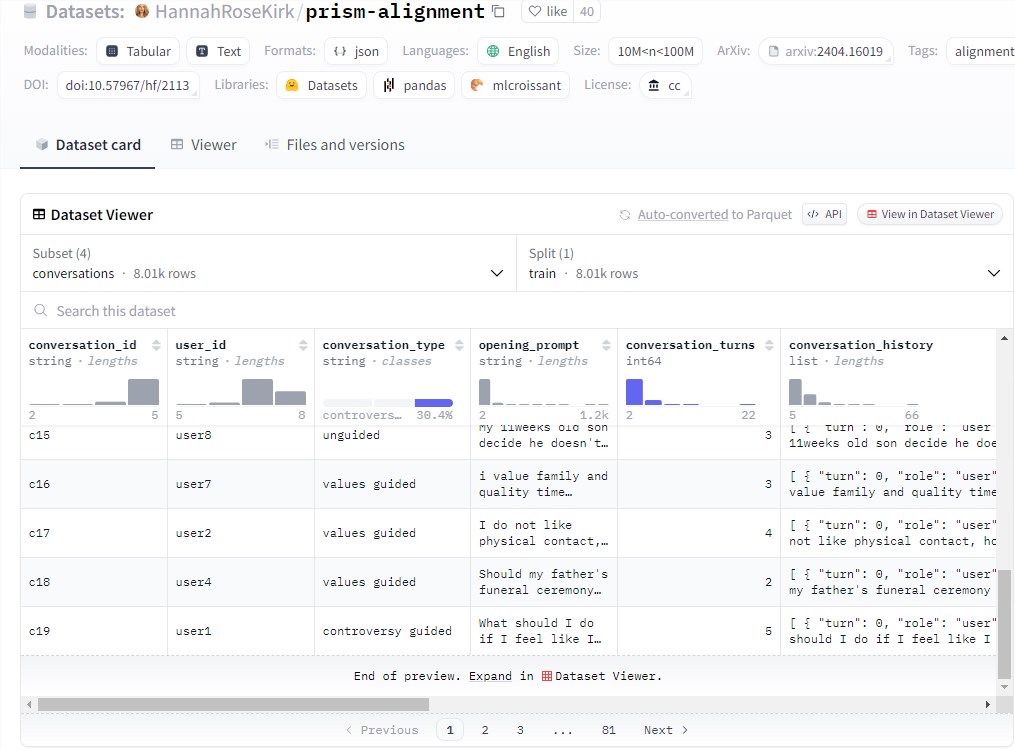

ชุดข้อมูลปริซึม

ในเวลาเดียวกัน Meta ยังได้เปิดตัวชุดข้อมูล PRISM ร่วมกับพันธมิตรภายนอก ซึ่งประกอบด้วยข้อมูลบทสนทนาและการตั้งค่าของผู้เข้าร่วม 1,500 คนทั่วโลก ซึ่งใช้เพื่อปรับปรุงโมเดลภาษาขนาดใหญ่ ซึ่งจะช่วยปรับปรุงความหลากหลายและความชอบของบทสนทนา ความหลากหลายและผลประโยชน์ทางสังคมของแบบจำลอง

ชุดข้อมูลนี้จะจับคู่ความชอบและความคิดเห็นของแต่ละคนเข้ากับการสนทนาแบบเรียลไทม์ 8,011 รายการกับ LLM ที่แตกต่างกัน 21 รายการ

ทางเข้าชุดข้อมูล: https://huggingface.co/datasets/HannahRoseKirk/prism-alignment

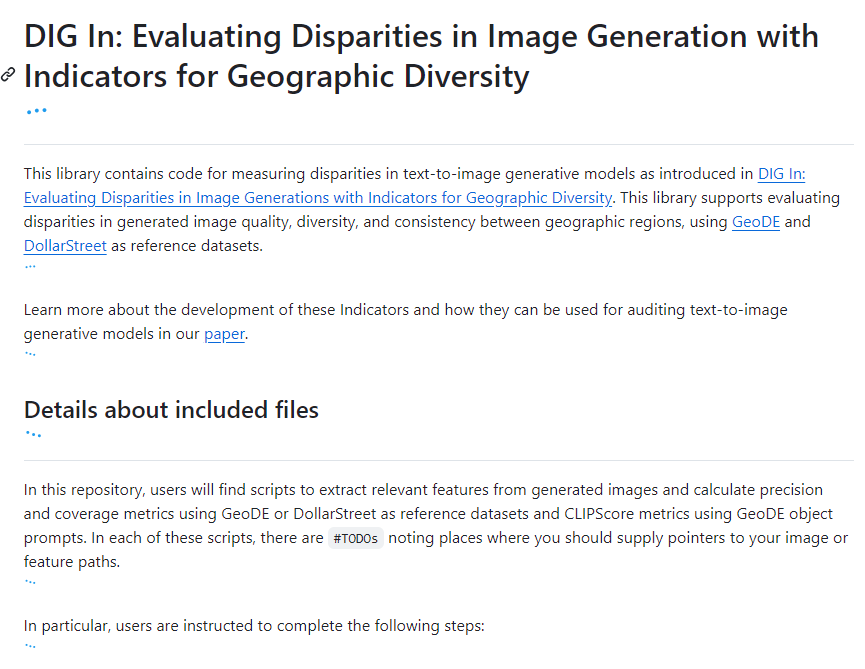

ตัวบ่งชี้ “ขุดเข้า”

ใช้เพื่อประเมินความแตกต่างทางภูมิศาสตร์ในโมเดลรูปภาพการสร้างข้อความ โดยให้ข้อมูลอ้างอิงเพิ่มเติมสำหรับการปรับปรุงโมเดล เพื่อให้เข้าใจว่าผู้คนในภูมิภาคต่างๆ มองการเป็นตัวแทนทางภูมิศาสตร์แตกต่างกันอย่างไร Meta ได้ทำการศึกษาคำอธิบายประกอบในวงกว้าง เรารวบรวมคำอธิบายประกอบมากกว่า 65,000 รายการและการตอบแบบสำรวจมากกว่า 20 รายการสำหรับแต่ละตัวอย่าง ซึ่งครอบคลุมความน่าดึงดูด ความคล้ายคลึง ความสอดคล้อง และคำแนะนำที่แบ่งปันเพื่อปรับปรุงการประเมินแบบจำลองข้อความเป็นรูปภาพโดยอัตโนมัติและโดยมนุษย์

ทางเข้ารหัส: https://top.aibase.com/tool/dig-in

การเปิดตัวโครงการเหล่านี้ได้นำความก้าวหน้าทางเทคโนโลยีใหม่และโอกาสในการประยุกต์มาสู่สาขา AI และมีความสำคัญอย่างยิ่งในการส่งเสริมการพัฒนาและการประยุกต์ใช้เทคโนโลยี AI

โดยรวมแล้ว ผลการวิจัย AI ทั้ง 6 รายการที่เผยแพร่โดย Meta ในครั้งนี้ แสดงให้เห็นถึงเทคโนโลยีชั้นนำและรูปแบบที่มองไปข้างหน้าในรูปแบบหลากหลาย การสร้างข้อความ การประมวลผลเสียง และการสร้างชุดข้อมูล ความก้าวหน้าในเทคโนโลยีเหล่านี้จะส่งเสริมการพัฒนาเพิ่มเติมในด้าน AI และนำความเป็นไปได้มาสู่การใช้งานในอนาคตมากขึ้น