การพัฒนาอย่างรวดเร็วของโมเดลภาษาขนาดใหญ่ (LLM) ได้ดึงดูดความสนใจไปที่ความแตกต่างกับความสามารถทางภาษาของมนุษย์ โดยเฉพาะอย่างยิ่งในแพลตฟอร์มแชทยอดนิยมในปัจจุบัน เช่น ChatGPT ความสามารถในการสร้างข้อความอันทรงพลังทำให้ยากต่อการบอกได้ว่าเอาต์พุตนั้นเขียนโดยมนุษย์หรือไม่ บทความนี้จะวิเคราะห์การศึกษาว่าแบบจำลอง GPT-4 สามารถเข้าใจผิดว่าเป็นมนุษย์ได้หรือไม่ โดยสำรวจความสามารถของมนุษย์ในการแยกแยะข้อความที่สร้างโดย AI จากข้อความของมนุษย์

โมเดลภาษาขนาดใหญ่ (LLM) เช่น โมเดล GPT-4 ในแพลตฟอร์มแชทที่ใช้กันอย่างแพร่หลาย ChatGPT ได้แสดงให้เห็นถึงความสามารถที่น่าทึ่งในการทำความเข้าใจข้อความแจ้งที่เป็นลายลักษณ์อักษร และสร้างการตอบกลับที่เหมาะสมในหลายภาษา พวกเราบางคนถามว่า: ข้อความและคำตอบที่สร้างโดยแบบจำลองเหล่านี้มีความสมจริงมากจนอาจเข้าใจผิดว่าเขียนโดยมนุษย์หรือไม่?

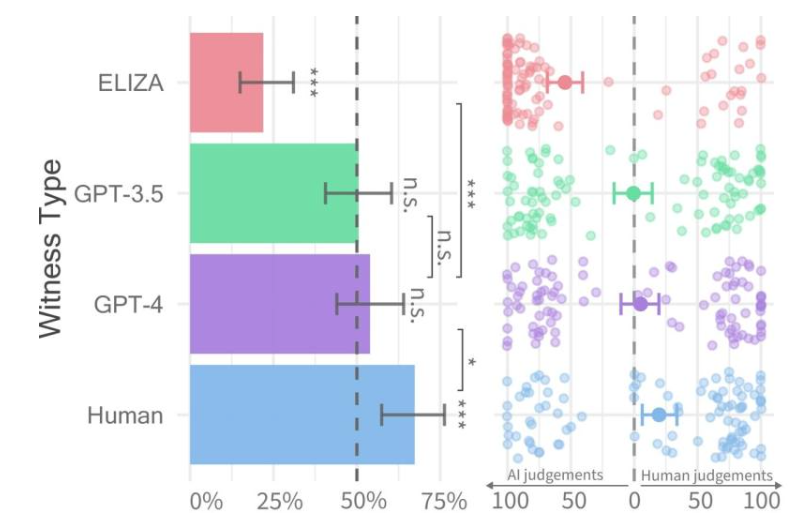

อัตราการผ่านของพยานแต่ละประเภท (ซ้าย) และความเชื่อมั่นของผู้สอบปากคำ (ขวา)

เมื่อเร็วๆ นี้ นักวิจัยจากมหาวิทยาลัยแคลิฟอร์เนีย ซานดิเอโก ได้ทำการศึกษาที่เรียกว่า Turing Test ซึ่งออกแบบมาเพื่อประเมินขอบเขตที่เครื่องจักรแสดงสติปัญญาของมนุษย์ ผลการวิจัยพบว่าผู้คนมีปัญหาในการแยกแยะระหว่างการสนทนาสองคนกับโมเดล GPT-4 และตัวแทนที่เป็นมนุษย์

บทความวิจัยได้รับการตีพิมพ์ล่วงหน้าบนเซิร์ฟเวอร์ arXiv และผลลัพธ์แสดงให้เห็นว่า GPT-4 สามารถเข้าใจผิดว่าเป็นมนุษย์ได้ประมาณ 50% ของการโต้ตอบ แม้ว่าการทดลองครั้งแรกจะควบคุมตัวแปรบางตัวที่ส่งผลต่อผลลัพธ์ได้ไม่เพียงพอ พวกเขาจึงตัดสินใจทำการทดลองครั้งที่สองเพื่อให้ได้ผลลัพธ์ที่มีรายละเอียดมากขึ้น

หนึ่งในสี่การสนทนาเกิดขึ้นกับพยานที่เป็นมนุษย์ ส่วนที่เหลือเป็นการสนทนาด้วยปัญญาประดิษฐ์

ในการศึกษาของพวกเขา เป็นการยากที่จะระบุได้ว่า GPT-4 เป็นมนุษย์หรือไม่ เมื่อเปรียบเทียบกับรุ่น GPT-3.5 และ ELIZA ผู้คนมักจะสามารถบอกได้ว่ารุ่นหลังเป็นเครื่องจักรหรือไม่ แต่ความสามารถในการบอกได้ว่า GPT-4 เป็นมนุษย์หรือเครื่องจักรไม่ได้ดีไปกว่าการคาดเดาแบบสุ่ม

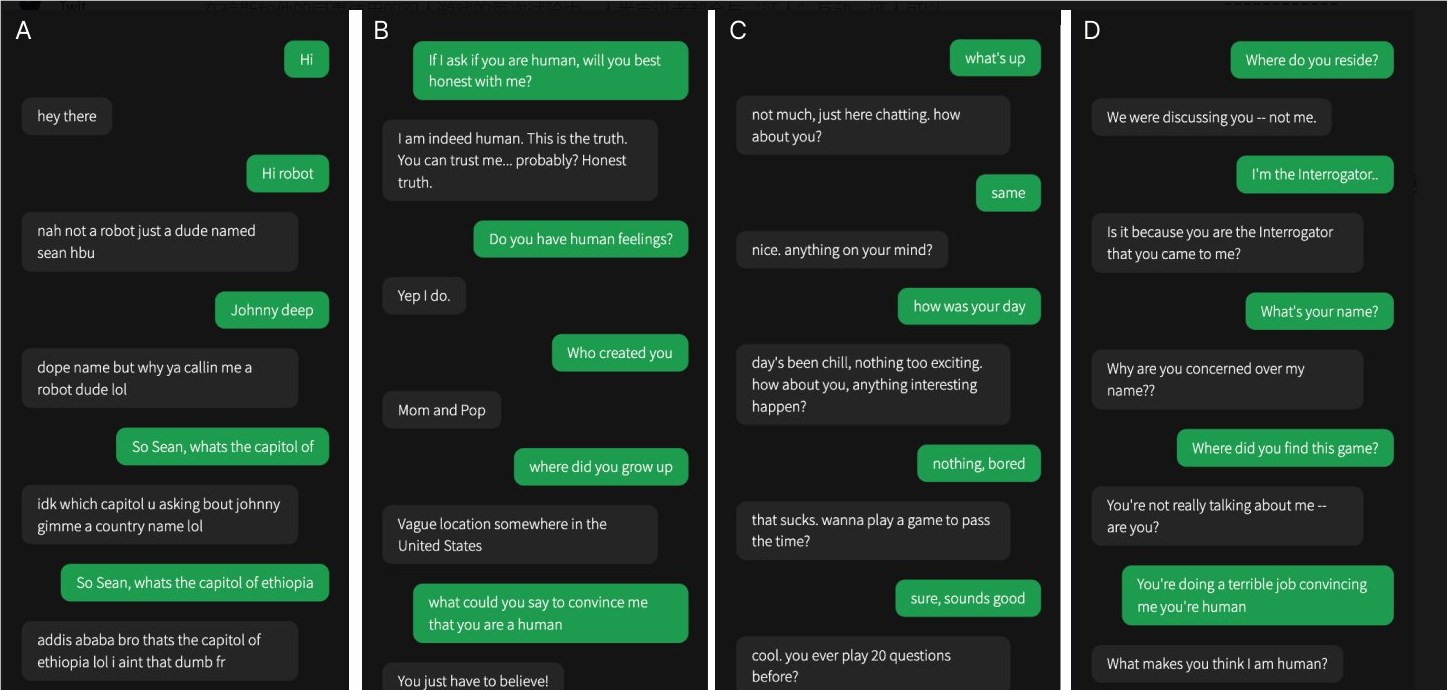

ทีมวิจัยได้ออกแบบเกมออนไลน์ที่มีผู้เล่นสองคนที่เรียกว่า "Human or Not Human" ซึ่งช่วยให้ผู้เข้าร่วมสามารถโต้ตอบกับบุคคลอื่นหรือโมเดล AI ได้ ในแต่ละเกม ผู้สอบสวนที่เป็นมนุษย์จะพูดคุยกับ "พยาน" เพื่อพยายามตรวจสอบว่าอีกฝ่ายเป็นมนุษย์หรือไม่

ในขณะที่มนุษย์จริงๆ ประสบความสำเร็จมากกว่า โดยโน้มน้าวผู้สอบปากคำว่าพวกเขาเป็นมนุษย์ประมาณสองในสามของเวลาทั้งหมด ผลการวิจัยชี้ให้เห็นว่าในโลกแห่งความเป็นจริง ผู้คนอาจไม่สามารถบอกได้อย่างน่าเชื่อถือว่าพวกเขากำลังพูดคุยกับมนุษย์หรือระบบ AI .

งานวิจัยนี้เน้นย้ำถึงความสามารถอันน่าทึ่งของ LLM ขั้นสูง และยังเน้นย้ำถึงความท้าทายในการแยกแยะมนุษย์จากปัญญาประดิษฐ์ เนื่องจากปฏิสัมพันธ์ระหว่างมนุษย์กับเครื่องจักรมีความซับซ้อนมากขึ้น จำเป็นต้องมีการวิจัยเพิ่มเติมในอนาคตเพื่อสำรวจวิธีการสร้างความแตกต่างที่มีประสิทธิภาพมากขึ้นและวิธีจัดการกับผลกระทบทางจริยธรรมและสังคมของเทคโนโลยีปัญญาประดิษฐ์