ด้วยการพัฒนาอย่างรวดเร็วของแบบจำลองภาษาขนาดใหญ่หลายรูปแบบ (MLLM) การบูรณาการรูปแบบภาษาด้วยภาพ ภาษา และคำพูดอย่างมีประสิทธิภาพจึงกลายเป็นจุดสนใจในการวิจัย อย่างไรก็ตาม ความท้าทายที่เกิดจากความแตกต่างที่สำคัญในข้อมูลโมดอลที่แตกต่างกัน เช่น ข้อมูลเชิงพื้นที่ของการมองเห็นและข้อมูลอนุกรมเวลาของคำพูด ขัดขวางปฏิสัมพันธ์หลายรูปแบบที่มีประสิทธิภาพ วิธีการที่มีอยู่มักจะอาศัยโมดูล ASR และ TTS อิสระ ซึ่งจะเพิ่มเวลาแฝงและลดความราบรื่นของการโต้ตอบ บทความนี้จะแนะนำ VITA-1.5 ซึ่งเป็นโมเดลภาษาขนาดใหญ่หลายรูปแบบที่รวมการมองเห็น ภาษา และคำพูดเข้าด้วยกัน โดยมีจุดมุ่งหมายเพื่อแก้ไขปัญหาเหล่านี้

เมื่อเร็ว ๆ นี้ มีความก้าวหน้าที่สำคัญในแบบจำลองภาษาขนาดใหญ่หลายรูปแบบ (MLLM) โดยเฉพาะอย่างยิ่งในการบูรณาการรูปแบบภาพและข้อความ อย่างไรก็ตาม ด้วยความนิยมที่เพิ่มขึ้นของการโต้ตอบระหว่างมนุษย์กับคอมพิวเตอร์ ความสำคัญของรูปแบบการพูดจึงมีความโดดเด่นมากขึ้นเรื่อยๆ โดยเฉพาะอย่างยิ่งในระบบการสนทนาหลายรูปแบบ เสียงไม่ได้เป็นเพียงสื่อหลักในการส่งข้อมูลเท่านั้น แต่ยังปรับปรุงความเป็นธรรมชาติและความสะดวกสบายของการโต้ตอบอย่างมากอีกด้วย

อย่างไรก็ตาม เนื่องจากความแตกต่างที่สำคัญระหว่างข้อมูลภาพและข้อมูลคำพูด การรวมข้อมูลเหล่านั้นเข้ากับ MLLM จึงไม่ใช่เรื่องเล็กน้อย ตัวอย่างเช่น ข้อมูลภาพบ่งบอกถึงข้อมูลเชิงพื้นที่ ในขณะที่ข้อมูลคำพูดบ่งบอกถึงการเปลี่ยนแปลงแบบไดนามิกในอนุกรมเวลา ความแตกต่างพื้นฐานเหล่านี้นำมาซึ่งความท้าทายในการเพิ่มประสิทธิภาพของทั้งสองรูปแบบไปพร้อมๆ กัน ซึ่งมักจะนำไปสู่ความขัดแย้งในระหว่างกระบวนการฝึกอบรม นอกจากนี้ ระบบคำพูดเป็นคำพูดแบบดั้งเดิมยังต้องอาศัยโมดูลการรู้จำเสียงพูดอัตโนมัติ (ASR) และโมดูลข้อความเป็นคำพูด (TTS) แยกกัน ซึ่งเพิ่มเวลาแฝงและลดการเชื่อมโยงกัน ซึ่งจำกัดประโยชน์ในการใช้งานแบบเรียลไทม์

เพื่อจัดการกับความท้าทายเหล่านี้ นักวิจัยได้เปิดตัว VITA-1.5 ซึ่งเป็นโมเดลภาษาขนาดใหญ่หลายรูปแบบที่ผสานรวมการมองเห็น ภาษา และคำพูด VITA-1.5 ใช้วิธีการฝึกอบรมสามขั้นตอนที่ออกแบบมาอย่างระมัดระวังเพื่อค่อยๆ แนะนำข้อมูลภาพและเสียงเพื่อบรรเทาความขัดแย้งของโมดอล ในขณะที่ยังคงรักษาประสิทธิภาพมัลติโมดัลที่แข็งแกร่งไว้

ในระยะแรก โมเดลมุ่งเน้นไปที่การฝึกอบรมด้านภาพและภาษา การสร้างความสามารถด้านภาพที่แข็งแกร่งโดยการฝึกอบรมอะแดปเตอร์ภาพ และปรับแต่งโมเดลอย่างละเอียดโดยใช้คำอธิบายภาพและข้อมูลคำถามและคำตอบที่เป็นภาพ

ขั้นตอนที่สองแนะนำการประมวลผลอินพุตเสียง โดยการฝึกตัวเข้ารหัสเสียงโดยใช้ข้อมูลที่จับคู่กับการถอดเสียงคำพูด จากนั้นปรับแต่งอย่างละเอียดโดยใช้ข้อมูลคำถามและคำตอบเกี่ยวกับคำพูด เพื่อให้โมเดลสามารถเข้าใจและตอบสนองต่ออินพุตเสียงได้อย่างมีประสิทธิภาพ สุดท้าย ในขั้นตอนที่สาม ตัวถอดรหัสเสียงได้รับการฝึกอบรมเพื่อให้ได้เอาต์พุตเสียงพูดจากต้นทางถึงปลายทางโดยไม่จำเป็นต้องใช้โมดูล TTS ภายนอก จึงทำให้ VITA-1.5 สามารถสร้างการตอบกลับด้วยเสียงที่ราบรื่น และเพิ่มความเป็นธรรมชาติและการโต้ตอบของบทสนทนาหลายรูปแบบ ระบบ

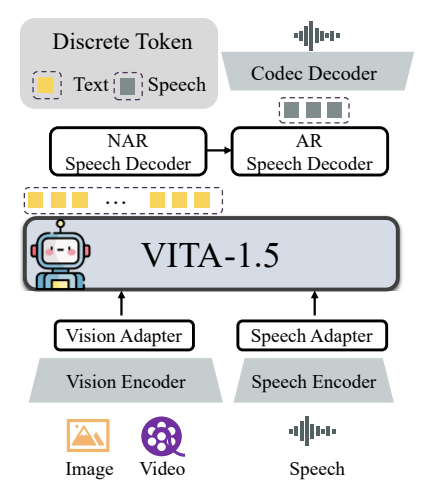

สถาปัตยกรรมโดยรวมของ VITA-1.5 ประกอบด้วยตัวเข้ารหัสภาพและเสียงและอะแดปเตอร์เพื่อเชื่อมต่อกับโมเดลภาษาขนาดใหญ่ เอาต์พุตมีโมดูลการสร้างคำพูดจากต้นทางถึงปลายทาง แทนที่จะใช้โมเดล TTS ภายนอก เช่น เวอร์ชัน VITA-1.0 ดั้งเดิม ตัวเข้ารหัสภาพใช้ InternViT-300M ขนาดภาพอินพุตคือ 448×448 พิกเซล และแต่ละภาพจะสร้างโทเค็นภาพ 256 ภาพ

สำหรับภาพที่มีความละเอียดสูง VITA-1.5 ใช้กลยุทธ์การแพตช์แบบไดนามิกเพื่อบันทึกรายละเอียดในท้องถิ่น วิดีโอถือเป็นประเภทอินพุตหลายภาพพิเศษ โดยมีเฟรมสุ่มตัวอย่างตามความยาวของวิดีโอ โมดูลการเข้ารหัสเสียงประกอบด้วยเลเยอร์ Convolutional แบบดาวน์แซมปลิงหลายเลเยอร์และบล็อก Transformer 24 บล็อก โดยมีอัตราเฟรมเอาต์พุต 12.5Hz อะแดปเตอร์เสียงประกอบด้วยชั้น Convolutional หลายชั้นพร้อมการสุ่มตัวอย่างต่ำ 2 เท่า TiCodec ใช้เป็นโมเดลตัวแปลงสัญญาณ ซึ่งเข้ารหัสสัญญาณเสียงพูดต่อเนื่องเป็นโทเค็นเสียงพูดแยกกันด้วยความถี่ 40Hz และสามารถถอดรหัสกลับเป็นสัญญาณเสียงพูดด้วยอัตราการสุ่มตัวอย่าง 24,000Hz ในการเปิดใช้งานโมเดลเพื่อส่งออกโทเค็นคำพูด จะมีการเพิ่มตัวถอดรหัสคำพูดสองตัวหลังโทเค็นข้อความ: ตัวถอดรหัสคำพูดแบบไม่ถอยอัตโนมัติ (NAR) และเครื่องถอดรหัสคำพูดแบบถอยหลังอัตโนมัติ (AR)

ข้อมูลการฝึกอบรมของ VITA-1.5 ครอบคลุมหลากหลายหมวดหมู่ เช่น ข้อมูลคำบรรยาย และข้อมูลคำถามและคำตอบ รวมถึงภาษาจีนและภาษาอังกฤษ ในขั้นตอนการฝึกอบรมที่แตกต่างกัน ชุดย่อยของชุดข้อมูลทั้งหมดจะถูกสุ่มตัวอย่างเพื่อให้บรรลุเป้าหมายที่แตกต่างกัน กลยุทธ์การฝึกอบรมจะดำเนินการในสามขั้นตอน:

ขั้นตอนแรก: การฝึกอบรมด้านภาพและภาษา รวมถึงการจัดตำแหน่งภาพ การทำความเข้าใจภาพ และการปรับแต่งภาพโดยมีผู้ดูแลอย่างละเอียด มีเป้าหมายเพื่อลดช่องว่างระหว่างการมองเห็นและภาษา และทำให้แบบจำลองสามารถเข้าใจเนื้อหาภาพและตอบคำถามด้วยภาพได้

ระยะที่ 2: การปรับแต่งอินพุตเสียง รวมถึงการจัดตำแหน่งเสียงและการปรับแต่งเสียงแบบละเอียดภายใต้การดูแล ได้รับการออกแบบมาเพื่อให้โมเดลเข้าใจอินพุตเสียงและโต้ตอบผ่านคำถามเสียงและคำตอบข้อความ

ขั้นตอนที่สาม: การปรับแต่งเอาต์พุตเสียง รวมถึงการฝึกอบรมตัวแปลงสัญญาณและการฝึกอบรมตัวถอดรหัส NAR + AR ได้รับการออกแบบมาเพื่อให้โมเดลสามารถสร้างเอาต์พุตเสียงพูดและบรรลุการโต้ตอบด้วยเสียงตั้งแต่ต้นทางถึงปลายทาง

นักวิจัยได้ทำการประเมินอย่างกว้างขวางเกี่ยวกับเกณฑ์มาตรฐานต่างๆ สำหรับความเข้าใจเกี่ยวกับภาพ วิดีโอ และคำพูด และเปรียบเทียบผลลัพธ์กับโอเพ่นซอร์สและโมเดลที่เป็นกรรมสิทธิ์ ผลลัพธ์แสดงให้เห็นว่า VITA-1.5 มีความสามารถในการรับรู้และการให้เหตุผลเทียบเคียงกับ MLLM ชั้นนำในงานด้านรูปภาพและวิดีโอ และประสบความสำเร็จในการปรับปรุงความสามารถด้านคำพูดอย่างมีนัยสำคัญ ตัวอย่างเช่น ในเกณฑ์มาตรฐานการทำความเข้าใจรูปภาพ VITA-1.5 ทำงานได้เทียบเท่ากับโมเดลโอเพ่นซอร์สที่ล้ำสมัย และยังเหนือกว่าโมเดลโอเพ่นซอร์สบางรุ่นด้วยซ้ำ ในแง่ของความเข้าใจเกี่ยวกับวิดีโอ VITA-1.5 มีประสิทธิภาพเทียบเท่ากับรุ่นโอเพ่นซอร์สชั้นนำ นอกจากนี้ VITA-1.5 ยังได้รับความแม่นยำระดับแนวหน้าในงาน ASR ทั้งภาษาจีนและภาษาอังกฤษ ซึ่งเหนือกว่าโมเดลคำพูดระดับมืออาชีพ

โดยรวมแล้ว VITA-1.5 ประสบความสำเร็จในการบูรณาการการมองเห็นและคำพูดผ่านกลยุทธ์การฝึกอบรมสามขั้นตอนที่ออกแบบมาอย่างระมัดระวัง บรรลุความสามารถในการเข้าใจภาพและคำพูดที่แข็งแกร่ง ช่วยให้สามารถโต้ตอบคำพูดเป็นคำพูดได้อย่างมีประสิทธิภาพโดยไม่ต้องพึ่งพาโมดูล ASR หรือ TTS แยกกัน การวิจัยนี้คาดว่าจะส่งเสริมความก้าวหน้าของโมเดลโอเพ่นซอร์สในด้านการโต้ตอบหลายรูปแบบแบบเรียลไทม์

ที่อยู่โครงการ: https://github.com/VITA-MLLM/VITA

การเกิดขึ้นของ VITA-1.5 ถือเป็นก้าวใหม่ในการพัฒนาโมเดลภาษาขนาดใหญ่หลายรูปแบบ ความสามารถในการสร้างคำพูดแบบ end-to-end และประสิทธิภาพที่ยอดเยี่ยมในงานทำความเข้าใจภาพ วิดีโอ และคำพูดจะช่วยสร้างธรรมชาติและราบรื่นยิ่งขึ้น แบบจำลองภาษาหลายรูปแบบสำหรับอนาคต ระบบโต้ตอบแบบไดนามิกมอบความเป็นไปได้ใหม่ๆ ผลการวิจัยนี้สมควรได้รับความสนใจและคาดว่าจะมีบทบาทสำคัญในการนำไปประยุกต์ใช้ในทางปฏิบัติ