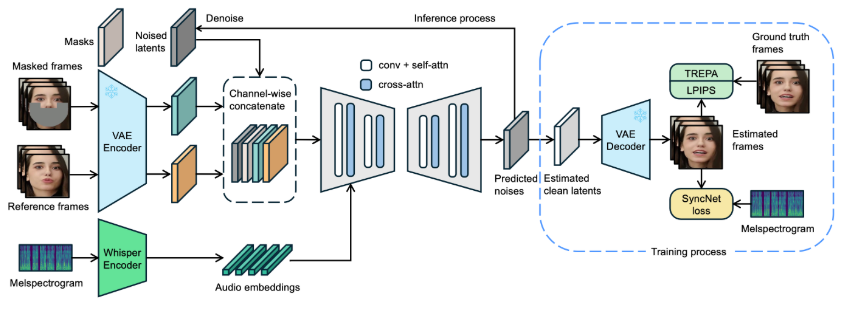

เฟรมเวิร์กการซิงโครไนซ์ลิป LatentSync ล่าสุดที่ออกโดย ByteDance ใช้โมเดลการแพร่กระจายแฝงแบบมีเงื่อนไขของเสียงโดยยึดตาม Stable Diffusion เพื่อให้ได้เอฟเฟกต์ลิปซิงโครไนซ์ที่แม่นยำและมีประสิทธิภาพมากขึ้น แตกต่างจากวิธีการก่อนหน้านี้ LatentSync ใช้แนวทางแบบ end-to-end เพื่อสร้างแบบจำลองความสัมพันธ์ที่ซับซ้อนระหว่างเสียงและการมองเห็นโดยตรง โดยไม่ต้องใช้การแสดงการเคลื่อนไหวระดับกลาง ปรับปรุงประสิทธิภาพการประมวลผลและความแม่นยำในการซิงโครไนซ์อย่างมีนัยสำคัญ เฟรมเวิร์กนี้ใช้ Whisper สำหรับการฝังเสียงอย่างชาญฉลาด และรวมเข้ากับกลไก TREPA เพื่อปรับปรุงความสอดคล้องของเวลา ทำให้มั่นใจได้ว่าวิดีโอเอาท์พุตจะรักษาความสอดคล้องกันของเสียงในขณะเดียวกันก็รักษาความแม่นยำของการซิงโครไนซ์ของริมฝีปาก

เมื่อเร็วๆ นี้ ByteDance ได้เปิดตัวเฟรมเวิร์กการซิงโครไนซ์ลิปใหม่ที่เรียกว่า LatentSync ซึ่งมีจุดมุ่งหมายเพื่อใช้โมเดลการแพร่กระจายแฝงของสภาพเสียงเพื่อให้ได้การซิงโครไนซ์ลิปที่แม่นยำยิ่งขึ้น เฟรมเวิร์กนี้อิงตาม Stable Diffusion และได้รับการปรับให้เหมาะสมเพื่อความสม่ำเสมอของเวลา

แตกต่างจากวิธีการก่อนหน้านี้ที่ใช้การกระจายเชิงพื้นที่พิกเซลหรือการสร้างสองขั้นตอน LatentSync ใช้แนวทางจากต้นทางถึงปลายทางโดยไม่จำเป็นต้องแสดงการเคลื่อนไหวระดับกลาง และสามารถสร้างแบบจำลองความสัมพันธ์ระหว่างภาพและเสียงที่ซับซ้อนได้โดยตรง

ในเฟรมเวิร์กของ LatentSync นั้น Whisper ถูกใช้ครั้งแรกในการแปลงสเปคโตรแกรมเสียงเป็นการฝังเสียงและรวมเข้ากับโมเดล U-Net ผ่านเลเยอร์การสนใจข้าม เฟรมเวิร์กดำเนินการเชื่อมต่อระดับช่องสัญญาณของหน้าต่างอ้างอิงและเฟรมมาสก์ด้วยตัวแปรแฝงสัญญาณรบกวนเป็นอินพุตไปยัง U-Net

ในระหว่างการฝึก มีการใช้แนวทางขั้นตอนเดียวเพื่อประเมินตัวแปรแฝงที่สะอาดจากสัญญาณรบกวนการคาดการณ์ จากนั้นจึงถอดรหัสเพื่อสร้างเฟรมที่สะอาด ในเวลาเดียวกัน โมเดลได้แนะนำกลไก Temporal REPresentation Alignment (TREPA) เพื่อปรับปรุงความสอดคล้องของเวลาและรับประกันว่าวิดีโอที่สร้างขึ้นสามารถรักษาความสอดคล้องกันของเวลาในขณะที่ยังคงความแม่นยำในการซิงโครไนซ์ของริมฝีปาก

เพื่อแสดงให้เห็นถึงประสิทธิภาพของเทคโนโลยีนี้ โปรเจ็กต์จึงจัดเตรียมชุดวิดีโอตัวอย่าง ซึ่งแสดงวิดีโอต้นฉบับและวิดีโอที่ลิปซิงค์ จากตัวอย่างต่างๆ ผู้ใช้สามารถสัมผัสได้ถึงความก้าวหน้าที่สำคัญของ LatentSync ในการซิงโครไนซ์ริมฝีปากวิดีโอ

วิดีโอต้นฉบับ:

วิดีโอเอาท์พุต:

นอกจากนี้ โครงการยังวางแผนที่จะเปิดซอร์สโค้ดอนุมานและจุดตรวจสอบเพื่ออำนวยความสะดวกแก่ผู้ใช้ในการฝึกอบรมและทดสอบ สำหรับผู้ใช้ที่ต้องการลองอนุมาน เพียงดาวน์โหลดไฟล์น้ำหนักโมเดลที่จำเป็น เท่านี้ก็พร้อมใช้งานแล้ว กระบวนการประมวลผลข้อมูลที่สมบูรณ์ยังได้รับการออกแบบ ครอบคลุมทุกขั้นตอนตั้งแต่การประมวลผลไฟล์วิดีโอไปจนถึงการจัดตำแหน่งใบหน้า เพื่อให้มั่นใจว่าผู้ใช้สามารถเริ่มต้นได้อย่างง่ายดาย

ทางเข้าโครงการตัวอย่าง: https://github.com/bytedance/LatentSync

ไฮไลท์:

LatentSync เป็นเฟรมเวิร์กการซิงโครไนซ์จากต้นทางถึงพอร์ตโดยอิงตามโมเดลการแพร่กระจายแฝงแบบมีเงื่อนไขของเสียง โดยไม่จำเป็นต้องแสดงการเคลื่อนไหวระดับกลาง

เฟรมเวิร์กใช้ Whisper เพื่อแปลงสเปกตรัมเสียงเป็นการฝัง ซึ่งช่วยเพิ่มความแม่นยำของโมเดลและความสม่ำเสมอของเวลาในระหว่างการซิงโครไนซ์ริมฝีปาก

โปรเจ็กต์นี้จัดเตรียมชุดวิดีโอตัวอย่าง และวางแผนที่จะใช้โค้ดที่เกี่ยวข้องกับโอเพ่นซอร์สและกระบวนการประมวลผลข้อมูล เพื่ออำนวยความสะดวกในการใช้งานและการฝึกอบรมของผู้ใช้

โอเพนซอร์สและความสะดวกในการใช้งานของ LatentSync จะส่งเสริมการพัฒนาและการประยุกต์ใช้เทคโนโลยีลิปซิงโครไนซ์เพิ่มเติม โดยนำความเป็นไปได้ใหม่ๆ มาสู่ด้านการตัดต่อวิดีโอและการสร้างเนื้อหา รอคอยการอัปเดตโครงการนี้ในครั้งต่อไปซึ่งจะนำมาซึ่งความประหลาดใจมากขึ้น