DeepSeek เปิดตัวโมเดลการอนุมานรุ่นแรก DeepSeek-R1 โดยอิงจากการฝึกอบรมการเรียนรู้แบบเสริมกำลังเมื่อวันที่ 20 มกราคม 2025 โมเดลดังกล่าวแสดงประสิทธิภาพที่เทียบเคียงหรือดีกว่า OpenAI-o1-1217 ในการทดสอบเกณฑ์มาตรฐานหลายรายการ DeepSeek-R1 ไม่ได้รับการฝึกฝนโดยตรง แต่ผ่านการฝึกอบรมแบบหลายขั้นตอนและข้อมูลการสตาร์ทแบบเย็น โดยยึดตามโมเดล DeepSeek-V3-Base จึงสามารถเอาชนะปัญหาที่เกิดจากการใช้โมเดลการฝึกอบรมการเรียนรู้แบบเสริมกำลังเท่านั้น (DeepSeek-R1-Zero) ปัญหาต่างๆ เช่น การอ่านไม่ดีและภาษาผสม ส่งผลให้เกิดการปรับปรุงประสิทธิภาพที่สำคัญในท้ายที่สุด โมเดลนี้เป็นแบบโอเพ่นซอร์สและเสนอราคาที่แข่งขันได้สำหรับการเข้าถึง API ทำให้ผู้ใช้มีทางเลือกที่สะดวกและประหยัดยิ่งขึ้น

เมื่อวันที่ 20 มกราคม 2025 DeepSeek ได้ประกาศเปิดตัวโมเดลการอนุมานรุ่นแรก DeepSeek-R1 ที่ได้รับการฝึกอบรมผ่านการเรียนรู้แบบเสริมกำลัง (RL) ซึ่งได้รับประสิทธิภาพที่เทียบเท่ากับ OpenAI-o1-1217 ในเกณฑ์มาตรฐานการอนุมานหลายรายการ DeepSeek-R1 ใช้โมเดล DeepSeek-V3-Base และใช้การฝึกอบรมแบบหลายขั้นตอนและข้อมูล Cold Start เพื่อปรับปรุงความสามารถในการอนุมาน

นักวิจัยของ DeepSeek พัฒนา DeepSeek-R1-Zero เป็นครั้งแรก ซึ่งเป็นแบบจำลองที่ได้รับการฝึกฝนทั้งหมดผ่านการเรียนรู้การเสริมกำลังขนาดใหญ่ โดยไม่มีขั้นตอนการเตรียมการสำหรับการปรับแต่งแบบละเอียดภายใต้การดูแล DeepSeek-R1-Zero แสดงให้เห็นถึงประสิทธิภาพที่ยอดเยี่ยมในการวัดประสิทธิภาพการอนุมาน ตัวอย่างเช่น ในการสอบ AIME2024 คะแนน pass@1 เพิ่มขึ้นจาก 15.6% เป็น 71.0% อย่างไรก็ตาม DeepSeek-R1-Zero ก็มีปัญหาบางอย่างเช่นกัน เช่น ความอ่านไม่ดีและภาษาผสม

เพื่อที่จะแก้ไขปัญหาเหล่านี้และปรับปรุงประสิทธิภาพการอนุมานให้ดียิ่งขึ้น ทีม DeepSeek จึงได้พัฒนา DeepSeek-R1 DeepSeek-R1 แนะนำการฝึกอบรมแบบหลายขั้นตอนและข้อมูลการสตาร์ทแบบเย็นก่อนการเรียนรู้แบบเสริมกำลัง โดยเฉพาะอย่างยิ่ง นักวิจัยได้รวบรวมข้อมูลการสตาร์ทขณะเครื่องเย็นนับพันรายการเพื่อปรับแต่งโมเดล DeepSeek-V3-Base จากนั้น พวกเขาทำการเรียนรู้แบบเสริมกำลังแบบอนุมานขณะฝึก DeepSeek-R1-Zero เมื่อกระบวนการเรียนรู้แบบเสริมกำลังใกล้จะถึงจุดบรรจบกัน พวกเขาได้สร้างข้อมูลการปรับแต่งแบบละเอียดภายใต้การดูแลใหม่ โดยการสุ่มตัวอย่างการปฏิเสธจุดตรวจสอบการเรียนรู้แบบเสริมกำลัง รวมกับข้อมูลภายใต้การดูแลของ DeepSeek-V3 ในด้านต่างๆ เช่น การเขียน การตอบข้อเท็จจริง และการตระหนักรู้ในตนเอง จากนั้นจึงฝึกอบรมใหม่ รุ่น DeepSeek-V3-Base ในที่สุด การเรียนรู้การเสริมกำลังเพิ่มเติมจะดำเนินการในจุดตรวจที่ได้รับการปรับแต่งโดยใช้สัญญาณจากทุกสถานการณ์

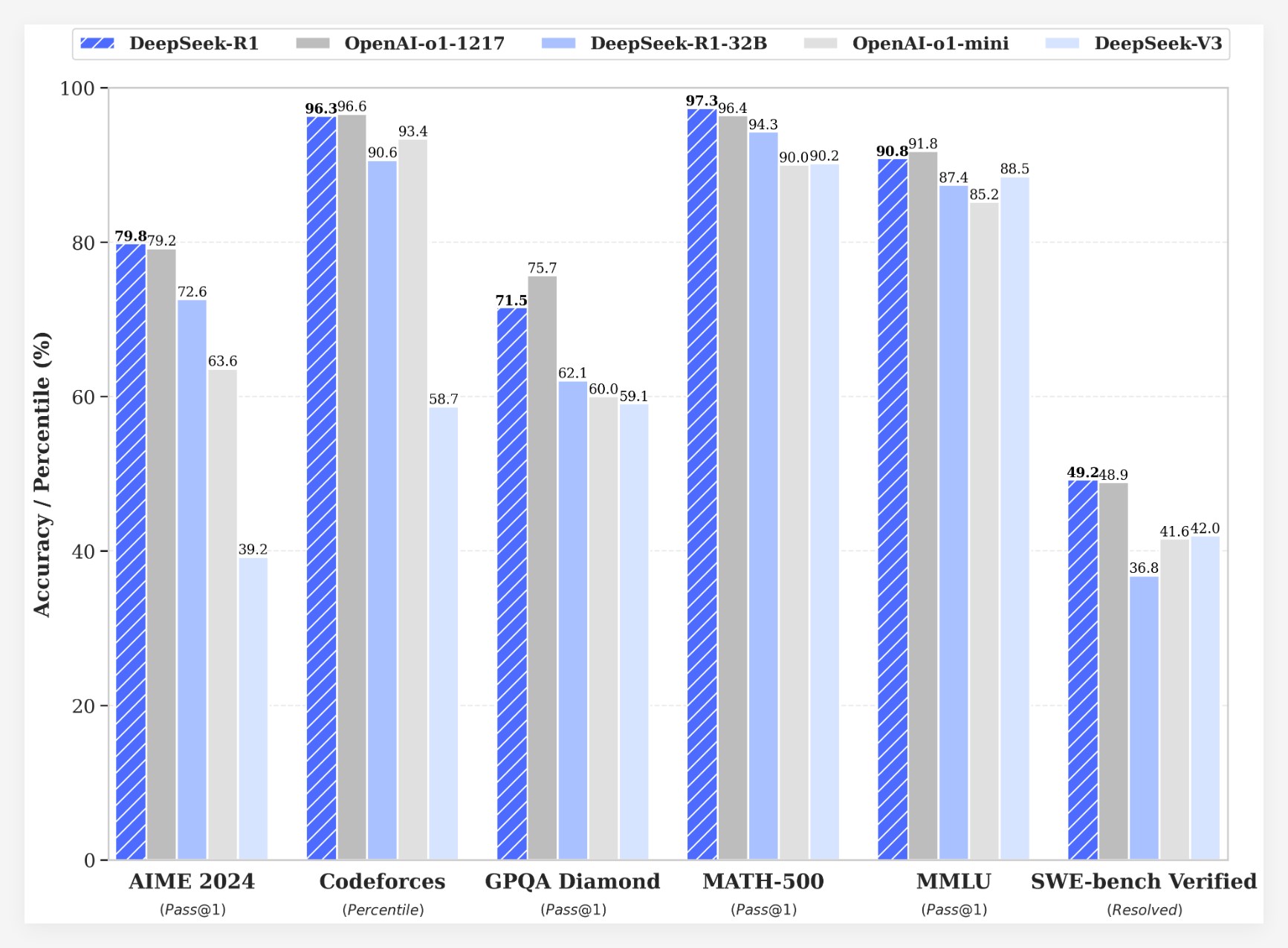

DeepSeek-R1 บรรลุผลลัพธ์ที่น่าประทับใจจากการวัดประสิทธิภาพหลายรายการ:

•ในการสอบ AIME2024 คะแนน pass@1 ของ DeepSeek-R1 สูงถึง 79.8% ซึ่งสูงกว่า OpenAI-o1-1217 เล็กน้อย

•ในการสอบ MATH-500 คะแนน pass@1 ของ DeepSeek-R1 สูงถึง 97.3% ซึ่งเท่ากับ OpenAI-o1-1217

ในงานแข่งขันเขียนโค้ด DeepSeek-R1 ได้รับคะแนน Elo ในปี 2029 บน Codeforces ซึ่งแซงหน้าผู้เข้าร่วมที่เป็นมนุษย์ถึง 96.3%

•ในการวัดประสิทธิภาพความรู้ เช่น MMLU, MMLU-Pro และ GPQA Diamond นั้น DeepSeek-R1 ได้คะแนน 90.8%, 84.0% และ 71.5% ตามลำดับ ซึ่งดีกว่า DeepSeek-V3 อย่างมาก

•DeepSeek-R1 ยังทำงานได้ดีในงานอื่นๆ เช่น การเขียนเชิงสร้างสรรค์ การถามตอบทั่วไป การแก้ไข การสรุป ฯลฯ

นอกจากนี้ DeepSeek ยังสำรวจการกลั่นความสามารถในการอนุมานของ DeepSeek-R1 ให้เป็นโมเดลขนาดเล็กอีกด้วย พบว่าการกลั่นโดยตรงจาก DeepSeek-R1 มีประสิทธิภาพดีกว่าการใช้การเรียนรู้แบบเสริมแรงกับแบบจำลองขนาดเล็ก สิ่งนี้ชี้ให้เห็นว่ารูปแบบการอนุมานที่ค้นพบโดยแบบจำลองฐานขนาดใหญ่มีความสำคัญอย่างยิ่งต่อการปรับปรุงความสามารถในการอนุมาน DeepSeek มีโอเพ่นซอร์ส DeepSeek-R1-Zero, DeepSeek-R1 และโมเดลหนาแน่นหกรุ่น (1.5B, 7B, 8B, 14B, 32B, 70B) ที่กลั่นจาก DeepSeek-R1 โดยใช้ Qwen และ Llama การเปิดตัว DeepSeek-R1 ถือเป็นความก้าวหน้าครั้งสำคัญในการเสริมการเรียนรู้ในการปรับปรุงความสามารถในการให้เหตุผลของโมเดลภาษาขนาดใหญ่

ความได้เปรียบด้านต้นทุนในแง่ของต้นทุน DeepSeek-R1 นำเสนอกลยุทธ์การกำหนดราคาที่มีการแข่งขันสูง ราคาการเข้าถึง API อยู่ที่ 0.14 ดอลลาร์ (การเข้าถึงแคช) และ 0.55 ดอลลาร์ (พลาดแคช) ต่อโทเค็นอินพุตหนึ่งล้าน และ 2.19 ดอลลาร์ต่อโทเค็นเอาต์พุตหนึ่งล้าน กลยุทธ์ด้านราคานี้มีความน่าสนใจมากกว่าผลิตภัณฑ์อื่นๆ ที่คล้ายคลึงกัน และผู้ใช้อธิบายว่าเป็น "ผู้เปลี่ยนเกม" เว็บไซต์อย่างเป็นทางการและ API ออนไลน์แล้ว! เยี่ยมชม https://chat.deepseek.com เพื่อสัมผัสประสบการณ์ DeepThink!

การเปิดตัว DeepSeek-R1 ทำให้เกิดการถกเถียงกันอย่างดุเดือดในชุมชน ผู้ใช้จำนวนมากชื่นชมธรรมชาติของโอเพ่นซอร์สและความได้เปรียบด้านต้นทุนของโมเดล โดยเชื่อว่าจะทำให้นักพัฒนามีทางเลือกและอิสระมากขึ้น อย่างไรก็ตาม ผู้ใช้บางรายได้ตั้งคำถามเกี่ยวกับขนาดหน้าต่างบริบทของโมเดล และหวังว่าเวอร์ชันในอนาคตจะสามารถปรับให้เหมาะสมต่อไปได้

ทีม DeepSeek ระบุว่าพวกเขาจะทำงานเพื่อปรับปรุงประสิทธิภาพและประสบการณ์ผู้ใช้ของโมเดลต่อไป และวางแผนที่จะเปิดตัวฟีเจอร์เพิ่มเติมในอนาคต รวมถึงการวิเคราะห์ข้อมูลขั้นสูง เพื่อตอบสนองความคาดหวังของผู้ใช้สำหรับ AGI (ปัญญาประดิษฐ์ทั่วไป)

การเปิดตัว DeepSeek-R1 ไม่เพียงแต่แสดงให้เห็นถึงศักยภาพที่ยิ่งใหญ่ของการเรียนรู้แบบเสริมกำลังในการปรับปรุงความสามารถในการใช้เหตุผลของแบบจำลองภาษาขนาดใหญ่เท่านั้น แต่ยังนำทิศทางและความเป็นไปได้ใหม่ๆ มาสู่การพัฒนาด้าน AI อีกด้วย คุณสมบัติโอเพ่นซอร์สและกลยุทธ์การกำหนดราคาที่แข่งขันได้จะช่วยส่งเสริมความนิยมและการประยุกต์ใช้เทคโนโลยี AI