บทความนี้แนะนำวิธี LLM2CLIP ที่พัฒนาโดย Microsoft โดยความร่วมมือกับมหาวิทยาลัย Tongji ซึ่งมีวัตถุประสงค์เพื่อปรับปรุงประสิทธิภาพการเข้ารหัสภาพของโมเดลคลิปและแก้ข้อ จำกัด ในการจัดการคำอธิบายข้อความที่ยาวและซับซ้อน LLM2CLIP ช่วยเพิ่มความสามารถของโมเดลในการจับคู่รูปภาพและข้อความอย่างมีนัยสำคัญโดยการรวมโมเดลภาษาขนาดใหญ่ (LLMS) และแนะนำเทคโนโลยี "การปรับแต่งความคมชัด" ผลการทดลองของวิธีนี้ในชุดข้อมูลหลายชุดแสดงให้เห็นว่าในงานการดึงภาพและข้อความเป็นภาพโดยเฉพาะอย่างยิ่งงานดึงข้อความยาวและสั้น ๆ พวกเขาเหนือกว่าคลิปดั้งเดิมและ EVA แบบจำลองและแสดงการประมวลผลข้ามภาษาที่ทรงพลัง ความสามารถ.

ในสาขาวิทยาศาสตร์และเทคโนโลยีในปัจจุบันคลิป (การฝึกอบรมภาษาแบบภาษาที่ตรงกันข้าม) เป็นรูปแบบพื้นฐานที่สำคัญหลายรูปแบบ มันรวมสัญญาณภาพและข้อความไว้ในพื้นที่คุณสมบัติที่ใช้ร่วมกันโดยใช้การสูญเสียการเรียนรู้แบบคอนทราสต์กับคู่ข้อความภาพขนาดใหญ่

ในฐานะผู้ค้นหาคลิปสามารถรองรับงานต่าง ๆ เช่นการจำแนกประเภทศูนย์การตรวจจับการแบ่งส่วนและการดึงข้อความภาพ ในฐานะที่เป็นตัวแยกฟีเจอร์มันครองงานการเป็นตัวแทนข้ามรูปแบบเกือบทั้งหมดเช่นความเข้าใจของภาพความเข้าใจวิดีโอและการสร้างข้อความเป็นภาพหรือวิดีโอ สิ่งที่ทรงพลังเกี่ยวกับคลิปคือความสามารถในการเชื่อมต่อภาพกับภาษาธรรมชาติและจับความรู้ของมนุษย์ด้วยการฝึกอบรมเกี่ยวกับข้อมูลเครือข่ายขนาดใหญ่ซึ่งมีคำอธิบายข้อความโดยละเอียด

อย่างไรก็ตามคลิปมีข้อ จำกัด บางประการในการจัดการกับคำอธิบายข้อความที่ยาวและซับซ้อน เพื่อเอาชนะปัญหานี้นักวิจัยจาก Microsoft และ Tongji University ได้เสนอวิธี LLM2CLIP โดยมีวัตถุประสงค์เพื่อเพิ่มการเรียนรู้การแสดงภาพโดยการรวมโมเดลภาษาขนาดใหญ่ (LLMs) วิธีนี้จะแทนที่ตัวเข้ารหัสข้อความคลิปดั้งเดิมอย่างกล้าหาญและใช้ความรู้ที่หลากหลายของ LLM เพื่อปรับปรุงประสิทธิภาพการเข้ารหัสภาพของคลิป การศึกษาพบว่าการรวม LLMs เข้ากับคลิปโดยตรงในการลดลงของประสิทธิภาพดังนั้นความท้าทายนี้จะต้องได้รับการแก้ไข

วิธี LLM2CLIP ช่วยปรับปรุงความสามารถของ LLM ในการแยกชื่อภาพอย่างมากโดยการแนะนำเทคโนโลยี

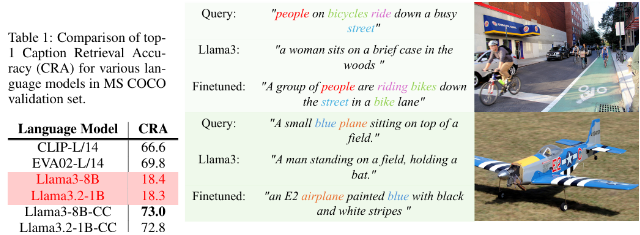

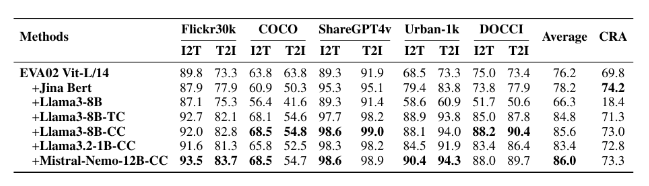

นักวิจัยใช้ชุดข้อมูลที่มีขนาดต่างกันสำหรับการทดลองปรับแต่งอย่างละเอียดรวมถึง CC-3M ขนาดเล็ก, CC-3M และ CC-12M ขนาดกลางรวมถึง CC-3M ขนาดใหญ่, CC-12M, YFCC-15M และ Recaption-1B ผลลัพธ์แสดงให้เห็นว่าแบบจำลองที่ได้รับการฝึกฝนโดยใช้ LLM2CLIP ทำงานได้ดีกว่าคลิปแบบดั้งเดิมและ EVA แบบดั้งเดิมในงานการดึงภาพต่อข้อความและข้อความเป็นภาพ

ด้วยการรวมการฝึกอบรมแบบหลายรูปแบบเข้ากับแบบจำลองเช่น LLAVA 1.5, LLM2Clip ทำงานได้ดีในเกือบทั้งหมดโดยเฉพาะอย่างยิ่งเมื่อต้องรับมือกับงานดึงข้อความยาวและสั้น ๆ เพื่อปรับปรุงประสิทธิภาพของรุ่น EVA02 ก่อนหน้านี้ 16.5% วิธีการที่เป็นนวัตกรรมนี้ไม่เพียง แต่เปลี่ยนคลิปจากการประมวลผลข้อมูลภาษาอังกฤษเป็นแบบจำลองข้ามภาษาที่ทรงพลัง แต่ยังวางรากฐานสำหรับการวิจัยในอนาคตเกี่ยวกับการฝึกอบรมคลิป

รุ่น: https://huggingface.co/collections/microsoft/llm2clip-672323a266173cfa40b32d4c

รหัส: https://github.com/microsoft/llm2clip/

กระดาษ: https://arxiv.org/abs/2411.04997

คะแนน:

LLM2CLIP เป็นวิธีการที่เป็นนวัตกรรมที่เสนอโดย Microsoft และ Tongji University โดยร่วมมือกับมหาวิทยาลัย Tongji โดยมีวัตถุประสงค์เพื่อปรับปรุงประสิทธิภาพของการเข้ารหัสภาพด้วยการแทนที่การเข้ารหัสข้อความของคลิป

วิธีนี้ช่วยเพิ่มความสามารถของโมเดลในการจับคู่ภาพด้วยข้อความผ่านเทคนิค

การทดลองของ LLM2CLIP ในชุดข้อมูลหลายชุดแสดงให้เห็นว่ามันทำงานได้ดีกว่าโมเดลดั้งเดิมในงานการดึงข้อความระยะยาวและสั้น ๆ ซึ่งขับเคลื่อนการพัฒนาโมเดลข้ามภาษา

ในระยะสั้นวิธี LLM2CLIP ให้แนวคิดใหม่สำหรับการปรับปรุงรูปแบบคลิป ลิงก์ทรัพยากรที่เกี่ยวข้องนั้นสะดวกสำหรับผู้อ่านในการเรียนรู้และการวิจัย