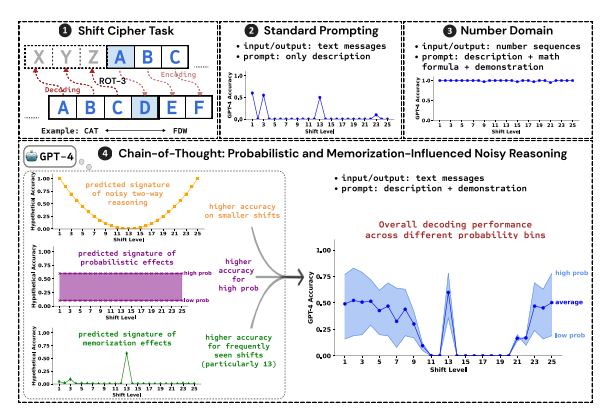

นักวิจัยที่มหาวิทยาลัยพรินซ์ตันและมหาวิทยาลัยเยลดำเนินการวิจัยเชิงลึกเกี่ยวกับความสามารถในการใช้เหตุผล "ห่วงโซ่การคิด (COT)" ของแบบจำลองภาษาขนาดใหญ่ (LLM) และเผยแพร่รายงานที่เกี่ยวข้อง การศึกษาใช้รหัสผ่านกะเป็นงานทดสอบและเลือก LLMS GPT-4 สาม, Claude3 และ Llama3.1 สำหรับการวิเคราะห์โดยมีจุดประสงค์เพื่อเปิดเผยกลไกที่อยู่เบื้องหลังการอนุมานของ COT การวิจัยพบว่าการใช้เหตุผล COT ของ LLM ไม่ใช่การใช้เหตุผลเชิงตรรกะเชิงสัญลักษณ์อย่างง่าย แต่เป็นผลมาจากการมีปฏิสัมพันธ์ที่ซับซ้อนของปัจจัยหลายอย่างซึ่งให้มุมมองใหม่สำหรับเราที่จะเข้าใจความสามารถในการใช้เหตุผลของ LLM

นักวิจัยที่ Princeton และ Yale University เพิ่งเปิดตัวรายงานเกี่ยวกับความสามารถในการใช้เหตุผลของ“ การเชื่อมโยงห่วงโซ่ (COT)” ในรูปแบบภาษาขนาดใหญ่ (LLM) เผยให้เห็นความลึกลับของการให้เหตุผล COT: มันไม่ใช่เหตุผลเชิงสัญลักษณ์ตามกฎเชิงตรรกะ แต่เพียงผู้เดียว แต่ มันรวมหน่วยความจำความน่าจะเป็นและการใช้เหตุผลเสียง

นักวิจัยใช้รหัสผ่านกะเป็นงานทดสอบเพื่อวิเคราะห์ประสิทธิภาพของสาม LLMS, GPT-4, Claude3 และ Llama3.1 รหัสผ่านกะเป็นวิธีการเข้ารหัสอย่างง่ายและตัวอักษรแต่ละตัวจะถูกแทนที่ด้วยตัวอักษรที่เลื่อนไปข้างหน้าในตัวอักษรที่มีตัวเลขคงที่ ตัวอย่างเช่นเลื่อนตัวอักษรไปข้างหน้าด้วยตัวเลข 3 หลักและ "CAT" กลายเป็น "FDW"

ผลการวิจัยแสดงให้เห็นว่าปัจจัยสำคัญสามประการที่มีผลต่อประสิทธิภาพของการอนุมาน COT คือ:

ความน่าจะเป็น: LLM มีแนวโน้มที่จะสร้างผลลัพธ์ที่มีความน่าจะเป็นสูงกว่าแม้ว่าขั้นตอนการอนุมานจะชี้ไปที่คำตอบที่มีความน่าจะเป็นต่ำกว่า ตัวอย่างเช่นหากขั้นตอนการให้เหตุผลชี้ไปที่ "staz" แต่ "อยู่" เป็นคำทั่วไปมากขึ้น llm อาจ "แก้ไขตัวเอง" และส่งออก "อยู่"

หน่วยความจำ: LLM จดจำข้อมูลข้อความจำนวนมากระหว่างการฝึกอบรมก่อนซึ่งมีผลต่อความแม่นยำของการอนุมาน COT ตัวอย่างเช่น ROT-13 เป็นรหัสผ่านการเปลี่ยนแปลงที่พบบ่อยที่สุดและ LLM มีความแม่นยำสูงกว่าอย่างมีนัยสำคัญใน ROT-13 มากกว่ารหัสผ่านแบบเลื่อนอื่น ๆ

การให้เหตุผลทางเสียง: กระบวนการให้เหตุผลของ LLM นั้นไม่ถูกต้องอย่างสมบูรณ์ แต่มีเสียงรบกวนในระดับหนึ่ง เมื่อการกระจัดของรหัสผ่านกะเพิ่มขึ้นขั้นตอนกลางที่จำเป็นสำหรับการถอดรหัสก็เพิ่มขึ้นเช่นกันและผลกระทบของการอนุมานเสียงจะชัดเจนขึ้นส่งผลให้ความแม่นยำของ LLM ลดลง

นักวิจัยยังพบว่าการใช้เหตุผล COT ของ LLM ขึ้นอยู่กับการปรับสภาพตนเองเช่น LLM จำเป็นต้องสร้างข้อความอย่างชัดเจนเป็นบริบทสำหรับขั้นตอนการให้เหตุผลที่ตามมา หาก LLM ได้รับคำสั่งให้ "คิดอย่างเงียบ ๆ " โดยไม่ส่งข้อความใด ๆ ความสามารถในการใช้เหตุผลจะลดลงอย่างมาก นอกจากนี้ประสิทธิภาพของขั้นตอนการสาธิตมีผลกระทบเพียงเล็กน้อยต่อการอนุมานของ COT

การศึกษาครั้งนี้แสดงให้เห็นว่าการใช้เหตุผลของ COT ของ LLM นั้นไม่ได้เป็นการใช้เหตุผลเชิงสัญลักษณ์ที่สมบูรณ์แบบ แต่รวมปัจจัยหลายอย่างเช่นหน่วยความจำความน่าจะเป็นและการให้เหตุผลด้านเสียง LLM ไม่เพียง แต่แสดงลักษณะของหน่วยความจำมาสเตอร์ในกระบวนการให้เหตุผล COT แต่ยังแสดงรูปแบบของต้นแบบความน่าจะเป็น การวิจัยนี้ช่วยให้เรามีความเข้าใจที่ลึกซึ้งยิ่งขึ้นเกี่ยวกับความสามารถในการใช้เหตุผลของ LLM และให้ข้อมูลเชิงลึกที่มีค่าสำหรับการพัฒนาระบบ AI ที่ทรงพลังยิ่งขึ้นในอนาคต

ที่อยู่กระดาษ: https://arxiv.org/pdf/2407.01687

โดยสรุปการศึกษาครั้งนี้มีความสำคัญอย่างยิ่งในการทำความเข้าใจกลไกการใช้เหตุผลของแบบจำลองภาษาขนาดใหญ่และการค้นพบของมันให้การอ้างอิงที่มีค่าสำหรับการปรับปรุงความสามารถในการใช้เหตุผลของ LLM ในอนาคตและพัฒนาระบบ AI ที่ทรงพลังยิ่งขึ้น การศึกษาเน้นถึงผลกระทบของปัจจัยต่าง ๆ เช่นความน่าจะเป็นความจำและเสียงรบกวนในการให้เหตุผล LLM ซึ่งให้คำแนะนำใหม่สำหรับนักวิจัยในสาขาของ AI