ทีมวิจัยจากมหาวิทยาลัยสแตนฟอร์ดและมหาวิทยาลัยวอชิงตันเมื่อเร็ว ๆ นี้ได้เปิดตัววิธีการฝึกอบรม AI ที่ก้าวหน้าที่เรียกว่า S1 ซึ่งแตกต่างจากการพึ่งพาพลังการประมวลผลขนาดใหญ่หรืออัลกอริทึมที่ซับซ้อนวิธี S1 ได้รับการกระโดดอย่างชาญฉลาดโดยการควบคุมการจัดสรรทรัพยากรการคำนวณของแบบจำลองในระหว่างการทดสอบ

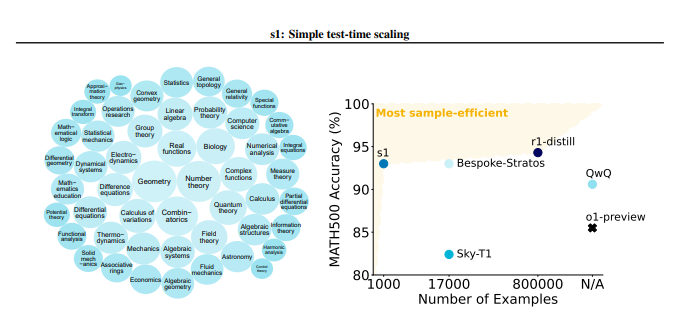

วิธี S1 สร้างชุดข้อมูลขนาดเล็กที่เรียกว่า S1K อย่างระมัดระวังเป็นครั้งแรกซึ่งมีปัญหาการอนุมานคุณภาพสูง 1,000 ข้อ มาตรฐานการคัดกรองของชุดข้อมูลนี้เข้มงวดมากและต้องเป็นไปตามเงื่อนไขสามประการของความยากลำบากสูงความหลากหลายที่แข็งแกร่งและคุณภาพที่ยอดเยี่ยมในเวลาเดียวกัน ทีมวิจัยตรวจสอบความสำคัญของเกณฑ์ทั้งสามนี้ผ่านการทดลองด้วยการระเหยอย่างละเอียดและผลการวิจัยพบว่าการเลือกแบบสุ่มหรือมุ่งเน้นไปที่เกณฑ์เดียวจะนำไปสู่การลดลงอย่างมีนัยสำคัญในการปฏิบัติงาน เป็นมูลค่าการกล่าวขวัญว่าแม้ว่าได้รับการฝึกฝนโดยใช้ superset ที่มีตัวอย่าง 59,000 ตัวอย่าง แต่ผลของมันก็น้อยกว่าตัวอย่าง 1,000 ตัวอย่างที่เลือกอย่างระมัดระวังซึ่งเน้นถึงความสำคัญของการเลือกข้อมูล

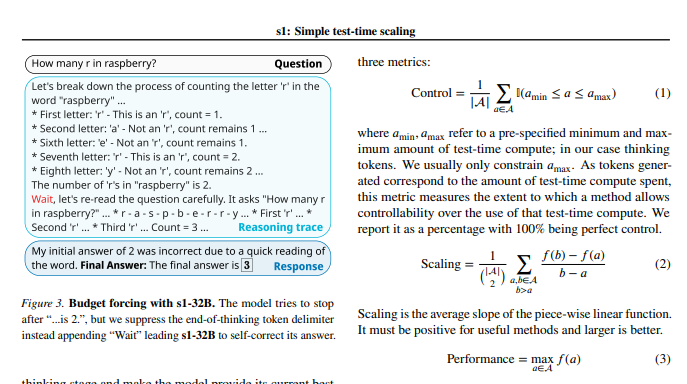

หลังจากการฝึกอบรมแบบจำลองเสร็จสิ้นนักวิจัยใช้เทคนิคที่เรียกว่า "บังคับใช้งบประมาณ" เพื่อควบคุมปริมาณการคำนวณระหว่างการทดสอบ พูดง่ายๆคือวิธีนี้ขยายเวลาการคิดของแบบจำลองโดยการบังคับให้ยกเลิกกระบวนการคิดของโมเดลหรือเพิ่มคำแนะนำ "รอ" ดังนั้นจึงเป็นแนวทางในการสำรวจและตรวจสอบเชิงลึกเพิ่มเติม ด้วยวิธีนี้โมเดลสามารถตรวจสอบขั้นตอนการอนุมานซ้ำ ๆ และแก้ไขข้อผิดพลาดได้อย่างมีประสิทธิภาพ

ผลการทดลองแสดงให้เห็นว่าด้วยการปรับแต่งชุดข้อมูล S1K และการสนับสนุนของเทคโนโลยี "บังคับใช้งบประมาณ" ประสิทธิภาพของโมเดล S1-32B ในปัญหาทางคณิตศาสตร์ระดับการแข่งขันเกินกว่าโมเดล O1-Preview ของ OpenAI ได้มากถึง 27% สิ่งที่น่าแปลกใจยิ่งกว่านั้นคือผ่านการปรับขนาด "งบประมาณ" โมเดล S1-32B ยังแสดงให้เห็นถึงความสามารถในการวางนัยทั่วไปเกินระดับการฝึกอบรมของตัวเองและคะแนนในชุดทดสอบ AIME24 เพิ่มขึ้นจาก 50% เป็น 57%

การมีส่วนร่วมหลักของการศึกษาครั้งนี้คือให้วิธีการที่ง่ายและมีประสิทธิภาพสำหรับการสร้างชุดข้อมูลที่มีความสามารถในการอนุมานสูงและบรรลุการปรับขนาดประสิทธิภาพเมื่อทำการทดสอบ จากสิ่งนี้ทีมวิจัยได้สร้างโมเดล S1-32B ซึ่งมีประสิทธิภาพเทียบเคียงหรือแม้แต่เหนือกว่าโมเดลแหล่งที่มาปิดและในเวลาเดียวกันก็จะได้รับโอเพ่นซอร์สและประสิทธิภาพตัวอย่างสูง รหัสโมเดลและข้อมูลสำหรับการศึกษาเปิดให้บริการบน GitHub

นักวิจัยยังทำการทดลองในเชิงลึกเกี่ยวกับรายละเอียดปลีกย่อยของข้อมูลและเทคนิคการปรับสเกลระหว่างการทดสอบ ในด้านข้อมูลพวกเขาพบว่ามันสำคัญมากที่จะต้องพิจารณาความยากลำบากความหลากหลายและคุณภาพในเวลาเดียวกัน ในแง่ของการปรับขนาดในเวลาทดสอบวิธีการ "งบประมาณบังคับ" แสดงให้เห็นถึงการควบคุมที่ยอดเยี่ยมและการปรับปรุงประสิทธิภาพ การศึกษายังสำรวจสองวิธีที่แตกต่างกันการปรับขนาดแบบขนานและการปรับขนาดตามลำดับและแนะนำเทคโนโลยีขั้นสูงเช่นการรีเบสซึ่งเป็นแรงบันดาลใจที่สำคัญสำหรับทิศทางการวิจัยในอนาคต

การศึกษาครั้งนี้ไม่เพียง แต่นำแนวคิดใหม่ที่มีต้นทุนต่ำและมีประสิทธิภาพสูงมาสู่การฝึกอบรม AI แต่ยังวางรากฐานที่มั่นคงสำหรับแอพพลิเคชั่น AI ที่หลากหลาย

ที่อยู่กระดาษ: https://arxiv.org/pdf/2501.19393

การศึกษาครั้งนี้แสดงให้เห็นว่าผ่านการก่อสร้างชุดข้อมูลอย่างระมัดระวังและการทดสอบการคำนวณทรัพยากรการคำนวณเวลาความสามารถในการอนุมานของแบบจำลอง AI สามารถปรับปรุงได้อย่างมีนัยสำคัญซึ่งให้ทิศทางใหม่สำหรับการพัฒนา AI ในอนาคต