Downcodes小編獲悉,艾倫人工智慧研究所(Ai2)最近發布了全新開源多模態AI模型家族Molmo,其性能驚艷,在多個第三方基準測試中甚至超越了OpenAI的GPT-4o、Anthropic的Claude3.5Sonnet和Google的Gemini1.5。 Molmo不僅能分析用戶上傳的影像,在訓練過程中也使用了比競爭對手少1,000倍的數據,這歸功於其獨特的訓練技巧。這項突破性成果展示了Ai2對開放研究的承諾,為更廣泛的社群和企業提供了高效能模型以及開放的權重和資料。

Molmo 不僅能接受用戶上傳的圖像進行分析,還使用了「比競爭對手少1000倍的數據」 進行訓練,這得益於其獨特的訓練技巧。

這次發布展示了Ai2對開放研究的承諾,提供了高效能的模型以及開放的權重和數據,供更廣泛的社區和企業使用。 Molmo 家族包括四個主要模型,分別是Molmo-72B、Molmo-7B-D、Molmo-7B-O 和MolmoE-1B,其中Molmo-72B 是旗艦模型,包含72億個參數,表現特別突出。

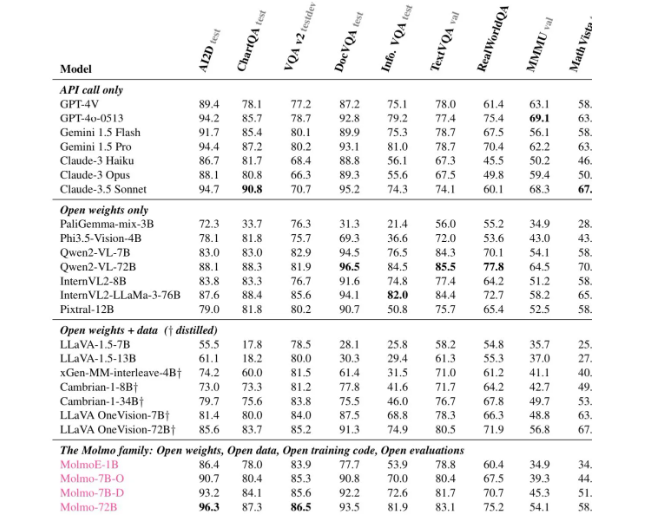

根據各項評估,Molmo-72B 在11重要基準測試中獲得了最高分,並在使用者偏好方面僅次於-4o。 Ai2也推出了一款為OLMoE 的模型,採用了「小型模型組合」 的方式,旨在提高成本益。

Molmo 的架構經過精心設計,以實現高效和卓越的性能。所有模型使用OpenAI 的ViT-L/14336px CLIP 模型作為視覺編碼器,將多尺度的圖處理成視覺令。語言模型部分是解碼器Transformer,具有不同的容量和開放性。

在訓練方面,Mol 經過了兩階段的訓練:首先是多模預訓練,其次是有監督的微調。與許多現代模型不同,Molmo 並未依賴人類回饋的強化學習,而是透過細緻調優的訓練流程來更新模型參數。

Molmo 在多個基準測試中表現優異,特別是在文件閱讀和視覺推理等複雜任務中,展現了其強大的能力。 Ai2已經在Hugging Face 上發布了這些模型和資料集,未來幾個月還將推出更多模型和擴展技術報告,旨在為研究者提供更多資源。

如果你想了解Molmo 的功能,現在可以透過Molmo 的官方網站進行公開展示(https://molmo.allenai.org/)。

劃重點:

Ai2Molmo 開源模態AI 模式超越產業頂產品。

? Mol-72B 在多個基準測試中表現卓越,僅次於GPT4o。

開放性強,模型和資料集供研究者與自由使用。

總而言之,Molmo 的出現標誌著多模態AI領域的一大進步,其開源特性也為全球研究者提供了寶貴的資源。 Downcodes小編期待Molmo在未來能得到更廣泛的應用與發展,推動AI技術不斷進步。