近日,Downcodes小編關注到一個令人擔憂的消息:在醫療行業廣泛應用的AI轉錄工具,基於OpenAI的Whisper技術,被發現存在「幻覺」現象,可能生成虛假內容。這引發了人們對AI技術在醫療領域應用的安全性與可靠性的擔憂。本文將詳細分析此事件,探討其潛在風險以及OpenAI的回應。

最近,一款由OpenAI 的Whisper 技術驅動的AI 轉錄工具在醫療產業中廣受歡迎。許多醫生和醫療機構都在使用這個工具來記錄和總結與病人的會面。

根據ABC 新聞的報導,研究人員發現這款工具在某些情況下會出現「幻覺」 現象,有時甚至會完全編造內容。

這款由名為Nabla 的公司開發的轉錄工具,已經成功轉錄了超過700萬次醫學對話,目前有超過3萬名臨床醫生和40個健康系統在使用它。儘管如此,Nabla 公司也意識到了Whisper 會產生幻覺的可能性,並表示正在努力解決這個問題。

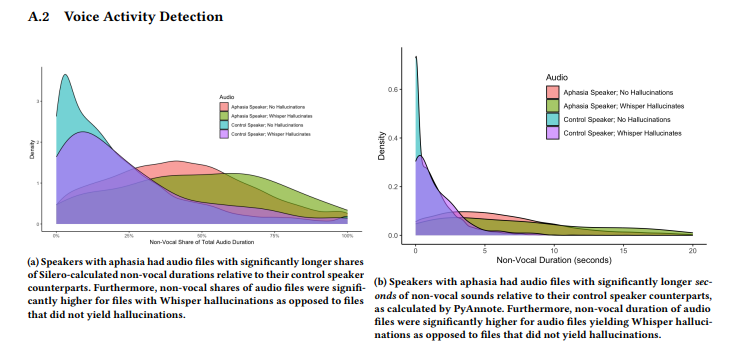

一群來自康乃爾大學、華盛頓大學等機構的研究人員進行了一項研究,發現Whisper 在大約1% 的轉錄中會出現幻覺。在這些情況下,工具會在錄音的沉默時段內隨機產生一些毫無意義的短語,甚至有時表達出暴力情緒。這些研究人員從TalkBank 的AphasiaBank 收集了音訊樣本,並指出,當語言障礙患者說話時,沉默的現象尤其常見。

康乃爾大學的研究員艾莉森・科內克(Allison Koenecke)在社群媒體上分享了一些範例,展示了Whisper 生成的幻覺內容。研究人員發現,工具所產生的內容中還包括一些虛構的醫學術語,甚至是類似於「感謝觀看!」 這樣的短語,這些句子聽起來就像是YouTube 影片中的話語。

這項研究於6月在巴西的電腦協會FAccT 會議上進行展示,但目前尚不清楚是否經過同行評審。對於這個問題,OpenAI 的發言人Taya Christianson 在接受《The Verge》採訪時表示,他們非常重視這個問題,並會持續努力改善,尤其是在減少幻覺方面。同時,她提到,在他們的API 平台上使用Whisper 時,有明確的使用政策禁止在某些高風險決策環境中使用該工具。

劃重點:

Whisper 轉錄工具在醫療行業中使用廣泛,並已記錄700萬次醫學對話。

⚠️ 研究發現Whisper 在約1% 的轉錄中會出現“幻覺”,有時會產生毫無意義的內容。

OpenAI 表示正在努力改善工具效能,特別是在減少幻覺現象方面。

總而言之,AI技術在醫療領域的應用前景廣闊,但也面臨許多挑戰。 Whisper「幻覺」現象的出現,提醒我們需謹慎對待AI技術,並加強對其安全性與可靠性的監管,以確保其安全、有效地應用於醫療領域,保障病患的權益與安全。 Downcodes小編將持續關注此事件的後續發展。