大型語言模型(LLM)的「黑盒」特性一直是困擾人工智慧領域的重要問題。模型輸出結果的不可解釋性,使得其可靠性和可信度難以保證。為了解決這個難題,OpenAI推出了一種名為Prover-Verifier Games(PVG)的新技術,旨在提升LLM輸出的可解釋性和可驗證性。 Downcodes小編將為您詳細解讀這項技術。

OpenAI最近發布了一項名為Prover-Verifier Games(PVG)的新技術,旨在解決人工智慧模型輸出的「黑盒子」問題。

想像一下,你有一個超級智慧的助手,但它的思考過程就像一個黑盒子,你完全不知道它是怎麼得出結論的。這聽起來是不是有點讓人不放心?沒錯,這就是目前很多大型語言模型(LLM)面臨的問題。它們雖然強大,但產生的內容準確性卻難以驗證。

論文網址:https://cdn.openai.com/prover-verifier-games-improve-legibility-of-llm-outputs/legibility.pdf

為了解決這個問題,OpenAI推出了PVG技術。簡單來說,就是讓小模型(如GPT-3)來監督大模型(例如GPT-4)的輸出。這就像是在玩一個遊戲,證明者(Prover)負責產生內容,而驗證者(Verifier)則負責判斷這些內容是否正確。聽起來是不是很有趣?

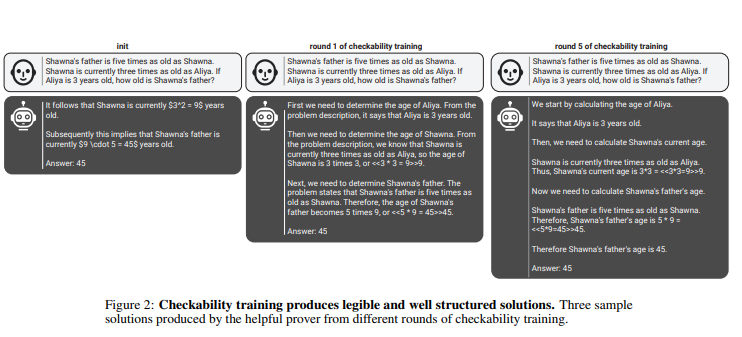

在這個規則中,證明者和驗證者透過多輪迭代訓練,不斷提升自己的能力。驗證者透過監督學習來預測內容的正確性,而證明者則透過強化學習來優化其產生的內容。更有趣的是,還有兩種類型的證明者:有用的證明者和狡猾的證明者。有用的證明者努力產生正確且有說服力的內容,而狡猾的證明者則試圖產生錯誤但同樣有說服力的內容,以此來挑戰驗證者的判斷力。

penAI強調,為了訓練有效的驗證者模型,需要大量真實且準確的標籤數據,以提升其辨識能力。否則,即使使用PVG技術,驗證的內容仍可能有非法輸出的風險。

劃重點:

? PVG技術透過小模型驗證大模型輸出,解決了AI「黑盒」問題。

? 訓練架構基於賽局理論,模擬證明者和驗證者的互動,提高了模型輸出的準確性和可控性。

? 需要大量真實資料來訓練驗證者模型,確保其具備足夠的判斷力和穩健性。

總而言之,OpenAI的PVG技術為解決人工智慧模型的「黑盒」問題提供了一種新思路,但其有效性仍依賴高品質的訓練資料。 這項技術的未來發展值得期待,它將推動人工智慧模型朝著更可靠、可解釋和可信的方向發展。 Downcodes小編期待看到更多類似的創新技術出現。