Downcodes小編帶你深入了解Transformer模型的奧秘!最近,一篇名為「Transformer Layers as Painters」的論文,以「畫家」的視角,生動地解釋了Transformer模型中間層的工作機制。論文透過巧妙的比喻和實驗,揭示了Transformer層級結構的運作方式,為我們理解大型語言模型的內部運作提供了新的思路。論文中,作者將Transformer的每一層比喻為一位畫家,共同創作出一幅宏大的語言畫卷,並透過一系列實驗驗證了這個觀點。

在人工智慧的世界裡,有一群特殊的畫家—Transformer模型中的層級結構。它們像一支支神奇的畫筆,在語言的畫布上描繪出豐富多彩的世界。最近,一篇名為Transformer Layers as Painters的論文,為我們理解Transformer中間層的工作機制提供了新的視野。

Transformer模型,作為當下最受歡迎的大型語言模型,擁有數十億的參數量。它的每一層,就像一位位畫家,共同完成一幅宏大的語言畫卷。但這些畫家是如何協同工作的?它們使用的畫筆和顏料又有何不同?這篇論文試圖回答這些問題。

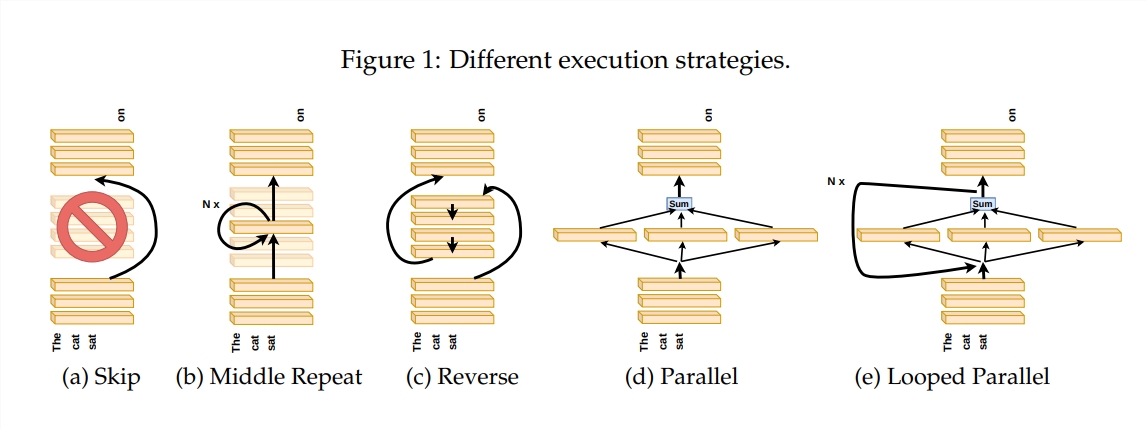

為了探究Transformer層的工作原理,作者設計了一系列實驗,包括跳過某些層、改變層的順序或平行運行層等。這些實驗就好比給畫家們設定不同的作畫規則,看看他們能否適應。

在「畫家流水線」的比喻中,輸入被看作是一張畫布,通過中間層的過程就像是畫佈在流水線上的傳遞。每個「畫家」,即Transformer的每個層,都會根據自己的專長對畫作進行修改。這種類比幫助我們了解Transformer層的並行性和可調整性。

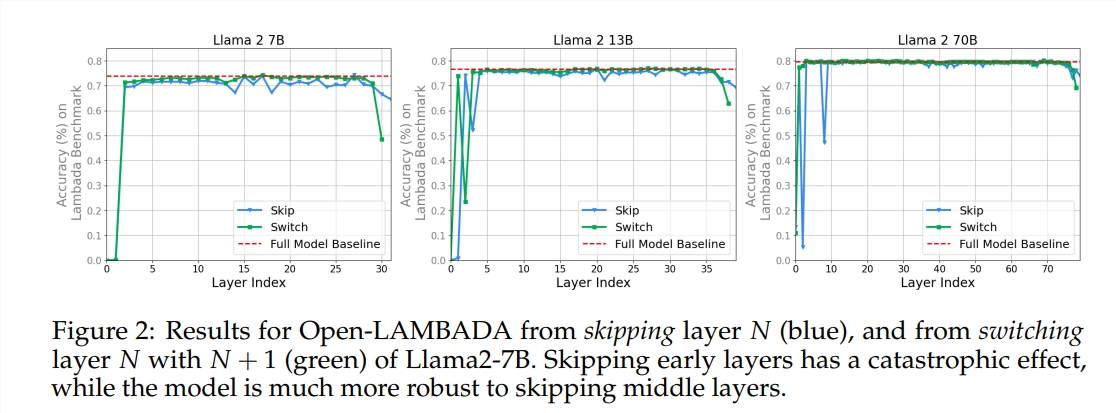

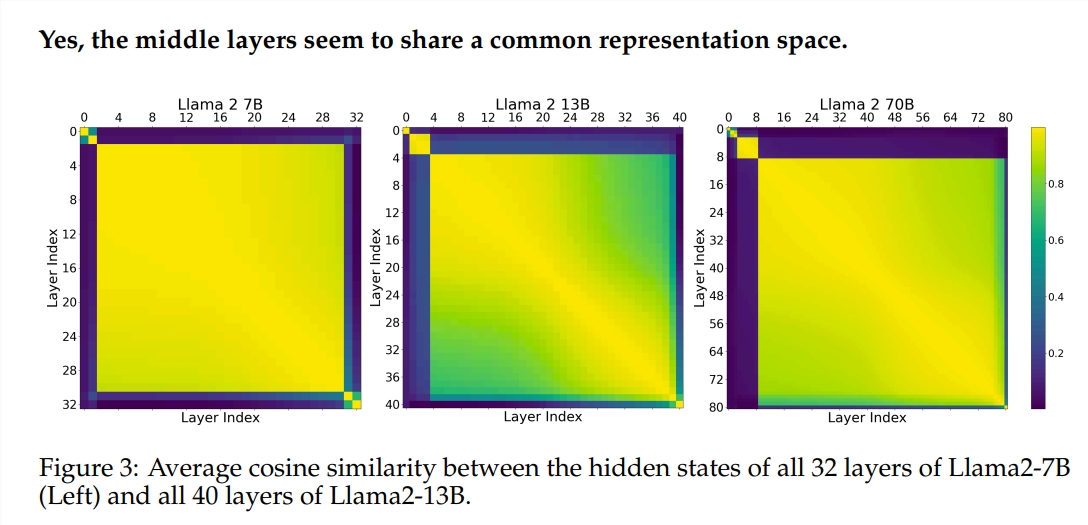

實驗使用了兩種預先訓練的大型語言模型(LLM):Llama2-7B和BERT。研究發現,中間層的畫家似乎共享一個共同的顏料盒——表示空間,而與首尾層有所不同。跳過某些中間層的畫家,對整幅畫作的影響並不大,說明並非所有畫家都是必須的。

儘管中間層的畫家使用相同的顏料盒,但它們卻用各自的技藝,在畫布上描繪出不同的圖案。如果簡單地重複使用某位畫家的技藝,畫作就會失去原有的魅力。

對於需要嚴密邏輯的數學和推理任務,作畫的順序尤其重要。而對於依賴語意理解的任務,順序的影響則相對較小。

研究結果表明,Transformer的中間層具有一定程度的一致性,但並不冗餘。對於數學和推理任務,層的順序比語意任務更為重要。

研究還發現,並非所有層都是必要的,中間層可以跳過而不會災難性地影響模型性能。此外,中間層雖然共享相同的表徵空間,但它們執行著不同的功能。改變層的執行順序會導致效能下降,顯示順序對於模型效能有重要影響。

在探索Transformer模型的道路上,許多研究者都在嘗試進行最佳化,包括剪枝、減少參數等。這些工作為理解Transformer模型提供了寶貴的經驗和啟示。

論文網址:https://arxiv.org/pdf/2407.09298v1

總而言之,這篇論文為我們理解Transformer模型的內部機制提供了新的視角,並為未來的模型最佳化提供了新的想法。 Downcodes小編建議有興趣的讀者閱讀全文,深入了解Transformer模型的奧秘!