近日,Anthropic公司的AI聊天機器人Claude的使用者體驗引發熱議。 Reddit上出現大量用戶回饋,稱Claude的表現有所下降,具體表現為記憶力減退和編碼能力下滑。這事件引發了關於大型語言模型效能評估和使用者體驗的廣泛討論,也再次凸顯了AI公司在維護模型穩定性方面所面臨的挑戰。

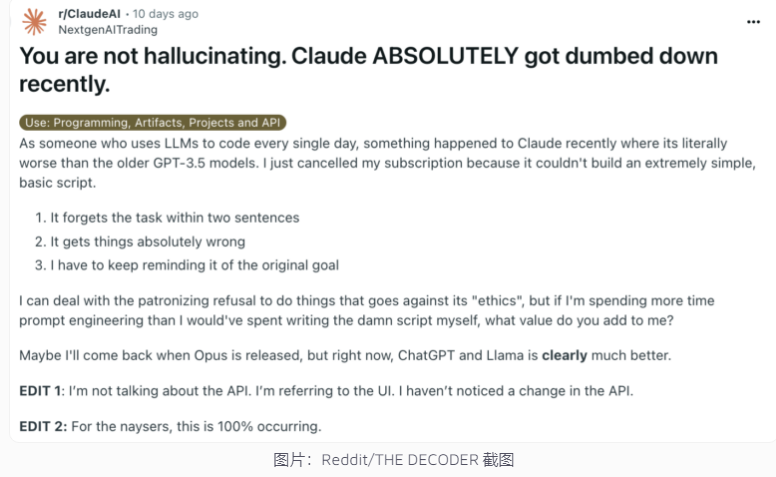

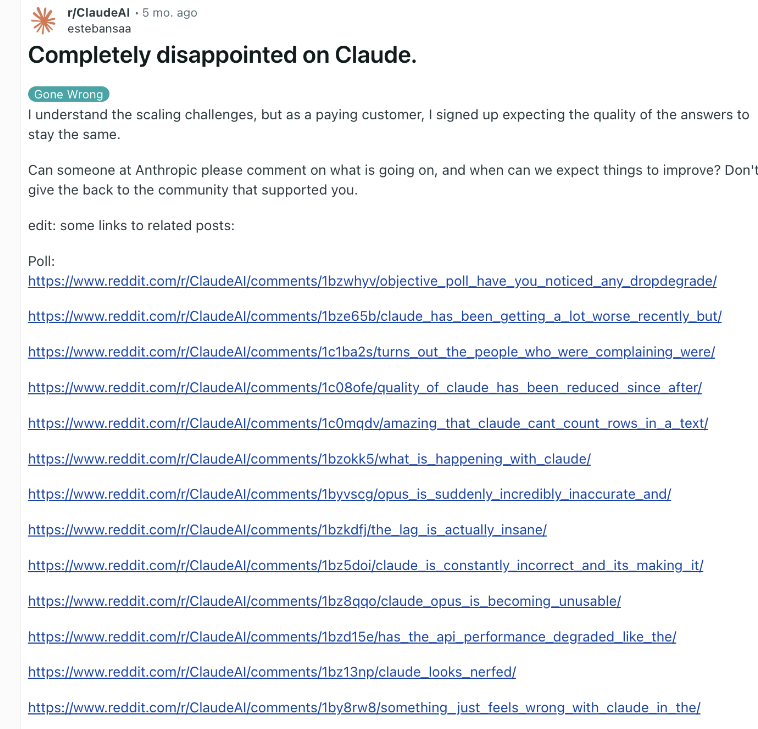

近日,Anthropic公司的AI聊天機器人Claude再次陷入效能爭議。 Reddit上一篇聲稱Claude最近變得愚蠢多了的貼文引發廣泛關注,許多用戶表示感受到Claude能力下降,包括記憶力減退和編碼能力下滑。

對此,Anthropic高層Alex Albert回應稱,公司調查未發現任何普遍問題,並確認未對Claude3.5Sonnet模型或推理管道做出更改。為提高透明度,Anthropic已在官網公佈Claude模型的系統提示。

這種用戶回饋AI退化而公司否認的模式並非首次出現。 2023年末,OpenAI的ChatGPT也曾面臨類似質疑。業內人士分析,造成此現象的原因可能包括:用戶期望值隨時間提高、AI輸出的自然變化、臨時計算資源限制等。

然而,即便底層模型未發生重大變化,這些因素仍可能導致使用者感知效能下降。 OpenAI曾指出,AI行為本身就具有不可預測性,維護和評估大規模生成式AI效能是一項巨大挑戰。

Anthropic表示將持續關注用戶回饋,並努力提升Claude的效能穩定性。這事件凸顯了AI公司在維持模型一致性方面所面臨的挑戰,以及提高AI績效評估和溝通透明度的重要性。

Claude效能爭議事件反映了大型語言模型研發和部署的複雜性,以及使用者預期與實際應用之間的差距。未來,AI公司需要進一步提升模型穩定性,並與使用者保持更有效的溝通,以確保AI技術能持續可靠地為使用者提供服務。