谷歌近期發布的研究報告警告稱,生成式人工智慧(GenAI)正在透過虛假內容污染網路。報告指出,GenAI 的濫用案例層出不窮,從竄改肖像到偽造證據,其目的多為影響輿論、詐騙或牟利。谷歌本身也因其AI產品曾給出荒謬建議而成為假訊息製造者,這使得其警告更具警示意義,也引發了人們對GenAI潛在風險的深思。

最近,Google的研究人員發出了警告:生成式人工智慧(GenAI)正在用虛假內容毀掉網路。這不只是一個警示,更像是一次自我反省。

諷刺的是,谷歌在這場「真假大戰」中扮演了雙重角色。一方面,它是生成式AI的重要推動者,另一方面,它也是假訊息的製造者。谷歌的AI概述功能曾出現過「披薩上塗膠水」、「吃石頭」等荒謬建議,這些錯誤訊息最終不得不被手動刪除。

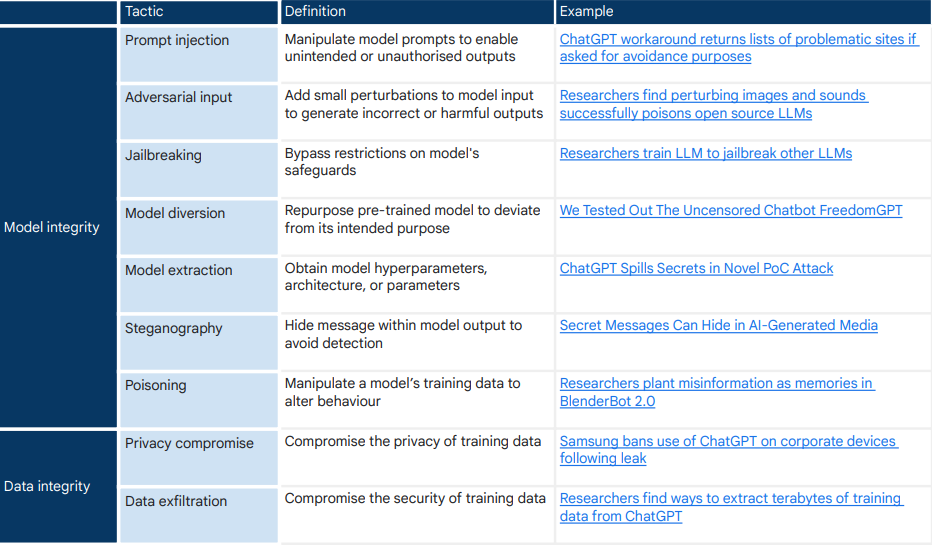

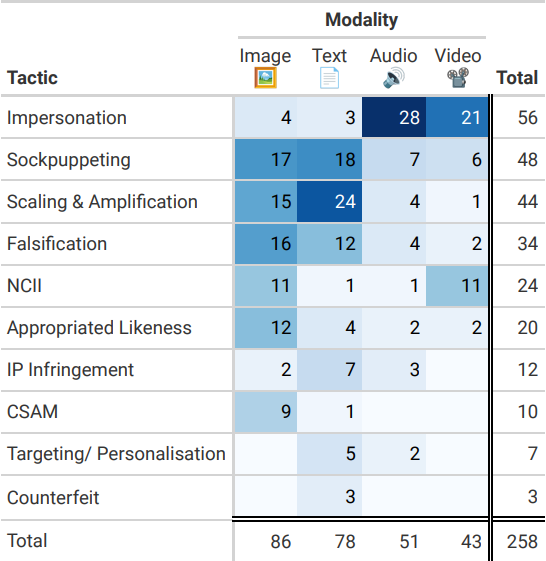

谷歌的研究團隊深入調查了200篇關於生成式AI濫用的新聞報道,發現竄改人類肖像和偽造證據是最普遍的濫用方式。這些行為的目的無非是影響公眾輿論、詐欺或牟取利益。生成式AI的風險雖然還沒有上升到「威脅生存」的地步,但卻是當下正在發生的事情,未來可能會變得更糟。

研究人員發現,大多數GenAI濫用案例都是對系統的正常使用,並沒有「越獄」行為。這類「常規操作」佔了9成。 GenAI的廣泛可用性、可近性和超現實性,使得層出不窮的、較低的濫用形式成為可能。產生假訊息的成本實在太低了!

谷歌的研究素材大量來自於媒體報道,這是否意味著研究結論帶有媒體的偏見?媒體更傾向於報道聳人聽聞的事件,這可能會導致數據集偏向特定類型的濫用。 404Media指出,還有大量的我們尚未意識到的生成式人工智慧的濫用並沒有被報導。

AI工具的「圍欄」可以用一些提示巧妙避過。例如,ElevenLabs的人工智慧語音克隆工具可以高度逼真地模仿同事或明星的聲音。 Civitai用戶可以創建人工智慧生成的名人圖像,儘管該平台有禁止NCII(未經同意的私密圖片)的政策,但同樣沒有什麼能阻止用戶在自己的機器上使用開源工具來產生NCII。

當假資訊氾濫,網路上的混亂狀況會對人們辨別真假的能力帶來巨大的考驗。我們將陷入一種經常性的懷疑,「這是真的嗎」?如果不加以解決,人工智慧產生的內容對公開資料的污染還可能會阻礙資訊檢索,扭曲對社會政治現實或科學共識的集體理解。

對於生成式AI所帶來的假內容的氾濫,Google扮演了推波助瀾的作用。多年前射出的子彈,今日終於擊中了自己的眉心。谷歌的這次研究,或許是一種自我救贖的開始,也是對整個網路社會的警醒。

論文網址:https://arxiv.org/pdf/2406.13843

谷歌的這份報告,無疑為GenAI的未來發展敲響了警鐘。如何平衡科技發展與風險控制,如何有效應對GenAI帶來的假訊息氾濫,是擺在全球科技界與社會面前的共同挑戰。 我們期待更多研究和行動,共同維護網路的真實與純淨。