表情包,從靜態圖片到動態視頻,已成為網路文化的重要組成部分。但製作高品質的表情包影片並非易事,現有方法有效率低、泛化能力差等問題。本文介紹了一種名為HelloMeme的工具,它能輕鬆高效地生成生動有趣、高保真度的表情包視頻,為短視頻創作增添新的樂趣。

各位“衝浪達人”們,還記得那些年我們追過的表情包嗎?從“地鐵老人看手機”到“金館長熊貓頭”,它們不僅承包了我們的笑點,也成為了一種獨特的網路文化符號。如今,短視頻風靡全球,表情包也“與時俱進”,從靜態圖片進化成了動態視頻,在各大平台上瘋狂刷屏。

但是,想要製作一個高品質的表情包影片可不是件容易的事。首先,表情包的特點就是表情誇張,動作幅度大,這對影片產生技術提出了不小的挑戰。其次,許多現有的方法需要對整個模型進行參數最佳化,這不僅費時費力,還可能導致模型的泛化能力下降,難以相容於其他衍生模型,可謂是「牽一發而動全身」。

那麼,有沒有一種方法可以讓我們輕鬆製作出既生動有趣又高保真的表情包視頻呢?答案是:當然有!HelloMeme 來拯救你啦!

HelloMeme 就像是給大型模型「裝插件」的工具,它能夠在不改變原始模型的基礎上,讓模型學會製作表情包視頻這項「新技能」。 它的秘密武器就是優化了與二維特徵圖相關的注意力機制,從而增強了適配器的性能。簡單來說,就是給模型戴上了一副“透視眼鏡”,讓它能夠更準確地捕捉到表情和動作的細節。

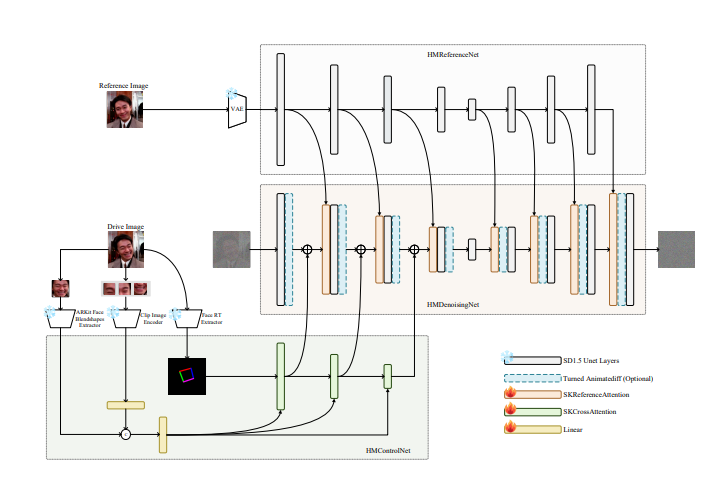

HelloMeme 的工作原理也很有意思。它由三個小夥伴組成:HMReferenceNet、HMControlNet 和HMDenoisingNet。

HMReferenceNet 就像是「閱片無數」的老師傅,它可以從參考影像中提取出高保真的特徵。 這就好比是給了模型一份“表情包製作指南”,讓它知道什麼樣的表情才夠“沙雕”。

HMControlNet 則像是“動作捕捉大師”,它可以提取頭部姿態和臉部表情訊息。 這相當於為模型安裝了一套“動作捕捉系統”,讓它能夠精準地捕捉到每一個細微的表情變化。

HMDenoisingNet 是“視訊剪輯師”,它負責將前面兩個小夥伴提供的資訊整合起來,產生最終的表情包影片。 它就像是個經驗豐富的剪輯師,可以將各種素材完美地融合在一起,打造出讓人捧腹大笑的影片作品。

為了讓這三個小夥伴能夠更好地協同工作,HelloMeme 還使用了一種名為「空間編織注意力機制」的魔法。這個機制就像是在編織毛衣一樣,將不同的特徵訊息交織在一起,從而保留了二維特徵圖中的結構資訊。 這樣一來,模型就不用重新學習這些基礎知識,可以更專注於表情包製作的「藝術創作」。

HelloMeme 最厲害的地方在於它在訓練過程中完全保留了SD1.5UNet 模型的原始參數,只優化了插入適配器的參數。 ** 這就好比是給模型“打了個補丁”,而不是對它進行“大手術”。 ** 這樣做的好處是既保留了原模型的強大功能,又賦予了它新的能力,可謂是一舉兩得。

HelloMeme 在表情包影片產生任務上取得了非常棒的效果。它產生的影片不僅表情生動,動作流暢,而且畫面清晰度高,簡直可以媲美專業製作水平。 更重要的是,HelloMeme 還與SD1.5衍生模型具有良好的兼容性,這意味著我們可以利用其他模型的優勢來進一步提升表情包影片的品質。

當然,HelloMeme 還有很多可以改進的空間。例如,它產生的影片在幀連續性方面還略遜於一些基於GAN 的方法,風格表達能力也有待增強。不過,HelloMeme 的研究團隊已經表示,他們會繼續努力改進模型,讓它變得更加強大,更加「沙雕」。

相信在不久的將來,HelloMeme 會成為我們製作表情包視頻的最佳利器,讓我們可以盡情釋放自己的“沙雕”腦洞,用表情包統治短視頻時代!

專案地址:https://songkey.github.io/hellomeme/

總而言之,HelloMeme 提供了一種高效且方便的表情包影片產生方案,其創新技術和出色效果值得期待。未來,隨著科技的不斷進步,相信HelloMeme將會成為表情包創作領域不可或缺的工具,讓更多人輕鬆製作出精彩的影片作品。