ARC-AGI,一個旨在評估通用人工智慧(AGI)抽象和推理能力的基準測試,近期取得進展,但其創造者弗朗索瓦·肖萊卻提醒我們,這並不意味著AGI的臨近。他指出,目前AI系統在ARC-AGI測試中的表現仍然遠低於預期,大型語言模型(LLM)的限制是主要原因,它們更擅長模式識別而非真正的推理。蕭萊和合作者發起了一百萬美元的競賽,以推動開源AI在ARC-AGI上的突破,但結果也印證了測試本身可能存在不足之處,需要進一步改進。

自2019年推出以來,ARC-AGI一直是人工智慧領域的焦點。儘管AI系統在測試中取得了一些進步,但其得分仍然遠低於人類水準。這引發了對當前AI發展方向的反思,也促使研究人員重新檢視AGI的定義和評估方法。文章詳細分析了ARC-AGI測試的局限性,以及對未來AGI研究方向的展望,並展示了相關競賽結果以及研究人員的應對策略。

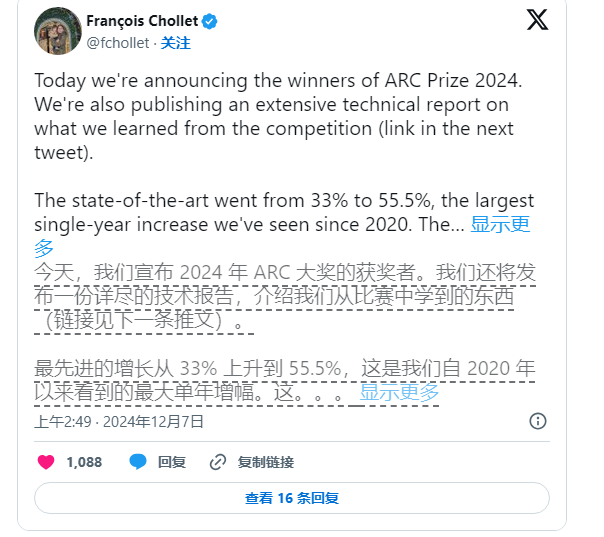

儘管如此,肖萊並未停止推動AI研究。他和Zapier創始人Mike Knoop於今年6月聯合發起了一項100萬美元的競賽,鼓勵開源AI挑戰ARC-AGI基準。儘管在17,789份參賽作品中,表現最好的AI系統僅得到了55.5%的分數,低於實現“人類水平”所需的85%標準,但肖萊和Knoop仍認為這是向前邁出的重要一步。

Knoop在部落格文章中指出,這項成績並不代表我們離實現AGI更近,反而凸顯了ARC-AGI中部分任務過度依賴「蠻力」解決方案,未必能為真正的通用智慧提供有效訊號。 ARC-AGI的設計本意是透過提供複雜、從未見過的任務來測試AI的泛化能力,然而,這些任務能否有效評估AGI仍存疑。

圖源備註:圖片由AI生成,圖片授權服務商Midjourney

ARC-AGI基準中的任務涉及如拼圖問題等,要求AI根據已知資訊推測出未知答案。儘管這些任務看似能推動AI對新情境的適應,但結果表明,現有模型似乎透過大量計算找到了解決方案,而未必展現出真正的智慧適應能力。

此外,ARC-AGI的創建者也面臨來自同行的批評,特別是在AGI定義方面的模糊性。 OpenAI的一位員工最近表示,如果將AGI定義為「在大多數任務上比大多數人類表現更好」的人工智慧,那麼AGI實際上已經實現。然而,蕭萊和Knoop則認為,ARC-AGI基準的現有設計尚未完全實現這一目標。

展望未來,蕭萊和Knoop計畫發布第二代ARC-AGI基準,並將在2025年舉行新的競賽,以解決目前測試中的不足。他們表示,新的基準將更聚焦於推動AI研究朝更重要的方向發展,加速AGI的實現進程。

然而,修復現有基準並非易事。蕭萊和Knoop的努力表明,定義人工智慧的智能,尤其是在通用智能領域,仍然是一項艱鉅而複雜的任務。

總而言之,ARC-AGI基準測試的進展及相關討論,反映了人工智慧領域對通用人工智慧的探索仍在持續進行中,既有突破,也有挑戰,未來需要更嚴格的定義和更有效的評估方法來推動AGI的真正發展。