位元組跳動豆包大模型團隊發布了全新的程式碼大模型評估基準-FullStack Bench,該基準涵蓋了11個真實場景、16種程式語言以及3374個問題,相比之前的評估標準,FullStack Bench能更全面、更準確地評估大模型的程式碼開發能力。它從Stack Overflow篩選數據,並經過AI和人工的交叉驗證,確保了數據的可靠性和廣泛性。同時,團隊也開源了程式碼沙盒工具SandboxFusion,方便開發者進行大模型測試。

12月5日,位元組豆包大模型團隊推出了最新的程式碼大模型評估基準-FullStack Bench,涵蓋了超11類真實場景,支援16種程式語言,並包含3374個問題。這項基準相比先前的評估標準,在更廣泛的程式設計領域中能更準確地評估大模型的程式碼開發能力,推動了模型在現實世界程式設計任務中的最佳化。

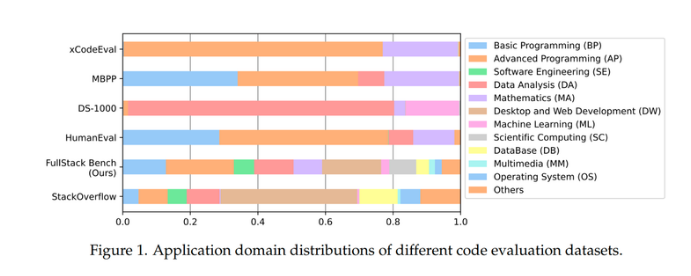

目前的主流程式碼評估基準,如HumanEval和MBPP,通常集中在基礎和高階程式設計問題,而DS-1000則專注於資料分析和機器學習任務,且僅支援Python。 xCodeEval則著重於高階程式設計和數學領域,有較大的應用場景和語言覆蓋限制。相較之下,FullStack Bench在資料覆蓋方面顯著增強,囊括了超11個應用領域,並且涵蓋了更為複雜多樣的程式設計場景。

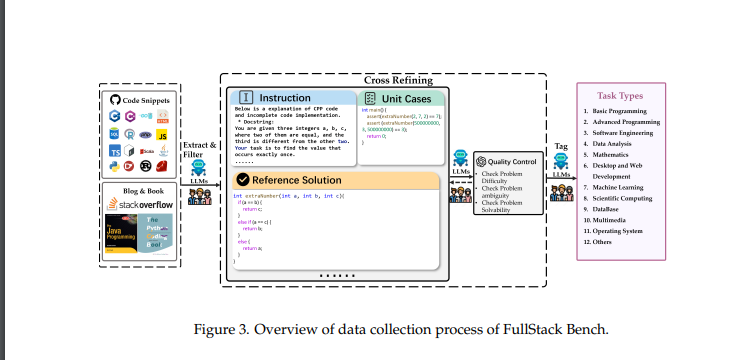

FullStack Bench的資料集來自全球最大程式問答平台Stack Overflow,研究團隊從50萬個問題中篩選出前88.1%的應用領域,確保了資料集的廣泛性與穩健性。每個問題都包括詳細的題目描述、參考解決方案和單元測試案例,確保評估準確性。團隊也透過AI與人工複查對數據品質進行了交叉評估,進一步提高了數據的可靠性。

為方便開發者使用此資料集,位元組豆包團隊也開源了程式碼沙盒工具-SandboxFusion,支援多語言程式設計任務的高效執行。 SandboxFusion相容於超過10種廣泛使用的程式碼評估資料集,支援23種程式語言,能夠幫助開發者在不同環境中輕鬆進行大模型測試。

此外,字節豆包大模型團隊也首次展示了自家開發的程式碼大模型-Doubao-Coder,並對全球20餘款程式碼大模型進行了程式設計能力評測。位元組在AI程式設計領域的不斷進展,特別是透過自研的程式碼基座模型MarsCode,每月為用戶貢獻百萬量級程式碼,展現了其在這一領域的領先地位。

資料集開源位址:https://huggingface.co/datasets/ByteDance/FullStackBench

沙盒開源網址:https://github.com/bytedance/SandboxFusion

論文網址:https://arxiv.org/pdf/2412.00535v2

FullStack Bench的發布以及相關工具的開源,標誌著位元組跳動在AI程式碼領域取得了顯著進展,為推動程式碼大模型的評估和發展做出了重要貢獻。 開發者可以利用這些資源來更好地提升自身模型的效能,並促進AI程式碼技術的進步。