近年來,AI虛擬頭像技術發展迅速,但其互動性仍是限制其應用的關鍵瓶頸。許多AI虛擬頭像在對話中表現生硬,缺乏真實感,無法實現與使用者的自然互動。為此,一項名為INFP的新技術應運而生,它旨在解決當前AI虛擬頭像在雙人對話中互動不足的問題,讓虛擬人物在對話過程中像真人一樣自然流暢地表達情感和動作,徹底改變人機互動體驗。

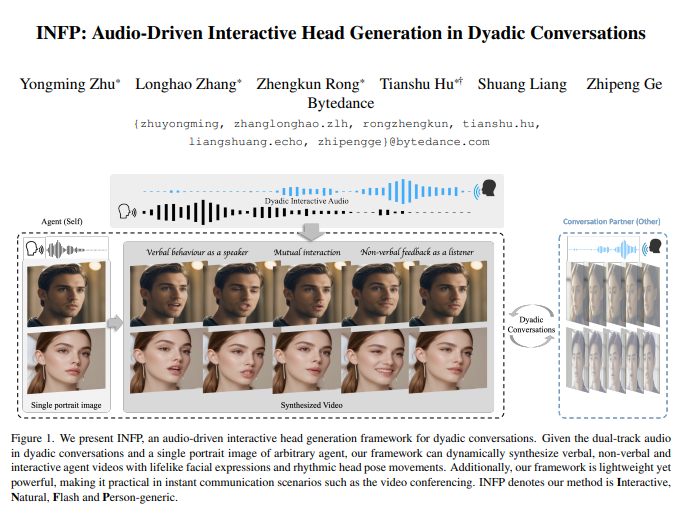

近日,一項名為INFP(Interactive, Natural, Flash and Person-generic)的新技術引起了廣泛關注。這項技術旨在解決當前AI虛擬頭像在雙人對話中存在的互動不足問題,讓虛擬人物在對話時能像真人一樣,根據對話內容動態調整表情和動作。

告別“單口相聲”,迎接“雙人合唱”

以前的AI頭像,要嘛只能自說自話,像個「單口相聲」演員,要嘛就是只會傻傻地聽著,沒有任何回饋,像個「木頭人」。但是,我們人類的對話可不是這樣的!我們說話的時候,眼睛會看著對方,還會不時點頭、皺眉,甚至插科打諢一下,這才是真正的互動啊!

而INFP的出現,就是要徹底改變這種尷尬的局面!它就像一個「雙人合唱」的指揮家,能根據你和AI的對話音頻,動態地調整AI頭像的表情和動作,讓你感覺就像在跟真人對話一樣!

INFP的「獨門秘籍」:兩大絕招,缺一不可!

INFP之所以這麼厲害,主要歸功於它的兩大「獨門秘籍」:

動作模仿大師(Motion-Based Head Imitation):

它會先從大量的真實對話影片中學習人類的表情和動作,就像一個“動作模仿大師”,把這些複雜的行為壓縮成一個個“動作密碼”。

為了讓動作更真實,它還會特別關注眼睛和嘴巴這兩個“表情擔當”,就像給它們上了“特寫鏡頭”一樣。

它還會使用人臉關鍵點來輔助表情的生成,確保動作的準確性和自然性。

然後,它把這些「動作密碼」套用到一個靜態的頭像上,讓頭像瞬間「活」過來,簡直就像魔法一樣!

音訊驅動的動作產生器(Audio-Guided Motion Generation):

這個「生成器」更厲害,它能聽懂你和AI的對話音頻,就像一個「聽聲辨位」的高手。

它會分析音訊中誰在說話、誰在聽,然後動態調整AI頭像的狀態,讓它在「說」與「聽」之間自由切換,完全不用手動切換角色。

它還配備了兩個“記憶庫”,分別儲存“說話”和“聽”時的各種動作,就像兩個“百寶箱”,隨時提取最合適的動作。

它還能根據你的聲音風格,調整AI頭像的情緒和態度,讓對話更生動有趣。

最後,它還會利用一種叫做「擴散模型」的技術,把這些動作變成平滑自然的動畫,讓你感覺不到任何卡頓。

DyConv:一個充滿「八卦」的超大對話資料集!

為了訓練INFP這個“超級AI”,研究人員也特意收集了一個超大規模的對話資料集,名叫DyConv!

這個資料集裡,有超過200小時的對話視頻,裡面的人來自五湖四海,聊的內容也是五花八門,簡直就是個「八卦集中營」。

DyConv資料集的影片品質非常高,確保每個人的臉都清晰可見。

研究人員也使用了最先進的語音分離模型,把每個人的聲音都單獨提取出來,方便AI學習。

INFP的「十八般武藝」:不只對話,還能...

INFP不僅能在雙人對話中大顯身手,還能在其他場景中發光發熱:

「聽話」模式(Listening Head Generation):它可以根據對方的說話內容,做出相應的表情和動作,就像一個「認真聽講」的好學生。

「復讀機」模式(Talking Head Generation):它可以根據音頻,讓頭像做出逼真的口型,就像一個「口技表演」大師。

為了證明INFP的強大,研究人員進行了大量的實驗,結果顯示:

在各種指標上,INFP都碾壓了其他同類方法,例如在視訊品質、唇音同步和動作多樣性等方面,都取得了非常優異的成績。

在使用者體驗方面,參與者也一致認為,INFP產生的影片更自然、生動,而且與音訊的匹配度更高。

研究人員也做了消融實驗,證明了INFP 中的每個模組都是必不可少的。

專案網址:https://grisoon.github.io/INFP/

INFP技術的突破,為AI虛擬頭像的互動體驗帶來了革命性的改變,使其更貼近真實的人類互動方式。未來,INFP技術可望在虛擬助理、線上教育、娛樂等許多領域中廣泛應用,為使用者帶來更自然、生動、沉浸式的互動體驗。