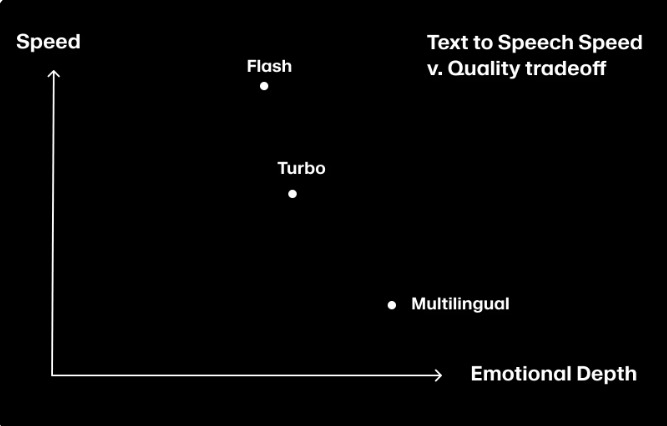

ElevenLabs发布了全新语音合成模型Flash,该模型以其超低的延迟——仅75毫秒——成为目前速度最快的文本转语音(TTS)解决方案。这一突破性进展特别适用于需要实时交互的对话式AI应用,显著提升了人机交互的流畅度和自然度。Flash模型提供两个版本:Flash v2(支持英语)和Flash v2.5(支持32种语言),用户可通过ElevenLabs的对话AI平台和API直接体验。尽管在音质和情感表达上略逊于Turbo模型,但Flash在速度方面明显领先,在盲测中脱颖而出。

Flash 模型分为两个版本,其中 Flash v2仅支持英语,而 Flash v2.5则支持32种语言。使用这两种模型时,用户每生成两个字符将消耗1个积分点。尽管 Flash 模型在音质和情感深度上稍逊于 Turbo 模型,但其低延迟性能使其在盲测中超越了其他同类产品,成为同类模型中速度最快的选择。

ElevenLabs 的技术团队表示,Flash 模型的推出将极大地推动人机交互的流畅度与自然感。开发者可以通过 API 直接调用模型 ID “eleven_flash_v2” 和 “eleven_flash_v2_5”,具体的 API 参考资料可在 ElevenLabs 官网找到。通过这一创新,ElevenLabs 期待能够开启更多低延迟、人性化的对话互动场景。

ElevenLabs 还提供了多种产品和解决方案,包括定制化的语音助手、音频制作工具和配音工作室,旨在帮助不同领域的用户和开发者实现高质量的 AI 音频创作。此外,ElevenLabs 也在积极开展研究和开发,持续提升其产品的技术水平,以满足用户日益增长的需求。

划重点:

Flash 模型生成语音的延迟仅为75毫秒,适合低延迟的对话式语音助手。

Flash v2.5支持32种语言,用户生成每两个字符消耗1个积分。

在盲测中,Flash 模型表现优于其他同类产品,成为速度最快的文本转语音解决方案。

总而言之,ElevenLabs的Flash模型凭借其超低延迟和多语言支持,为对话式AI应用带来了新的可能性,也预示着未来人机交互将更加流畅自然。其在速度方面的优势,使其成为目前市场上领先的文本转语音解决方案之一,值得开发者和用户关注。