想像一下,只要哼唱幾句或敲擊幾下節奏,就能產生高品質的音樂或音效,這不再是遙不可及的夢想。 Sketch2Sound,這項突破性的AI研究成果,透過結合聲音模仿和文字提示,實現了高品質音訊的生成。它巧妙地利用了聲音模仿中提取的響度、亮度和音高三個關鍵控制信號,並將其整合到文本到音頻的潛在擴散模型中,從而引導AI生成符合特定要求的聲音,為聲音創作領域帶來了革命性的變革。

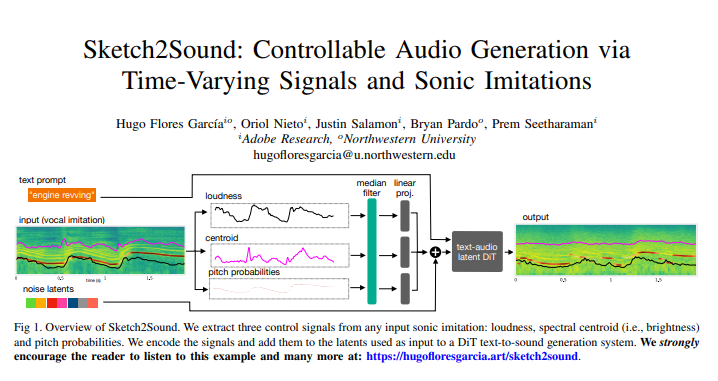

Sketch2Sound的核心技術在於,它能夠從任何聲音模仿(如人聲模仿或參考聲音)中提取出三個關鍵的、隨時間變化的控制信號:響度、亮度(頻譜質心)和音高。這些控制訊號被編碼後,會被加入到用於文字到聲音產生的潛在擴散模型中,引導AI產生符合特定要求的聲音。

這項技術最令人稱道的地方在於它的輕量化和高效性。 Sketch2Sound建立在現有的文本到音頻潛在擴散模型之上,只需進行4萬步的微調,並且每個控制信號僅需一個線性層,相比其他方法(如ControlNet)更加簡潔高效。為了讓模型能夠從「草圖」般的聲音模仿中進行合成,研究人員在訓練過程中也對控制訊號應用了隨機中值濾波器,使其能夠適應具有靈活時間特性的控制訊號。實驗結果表明,Sketch2Sound不僅能合成出符合輸入控制訊號的聲音,還能保持對文字提示的遵從,並達到與純文字基線相當的音訊品質。

Sketch2Sound為聲音藝術家提供了一種全新的創作方式。他們可以利用文字提示的語意彈性,結合聲音姿態或模仿的表達性和精確性,來創造前所未有的聲音作品。這類似於傳統Foley藝術家透過操作物件來製造音效,而Sketch2Sound則透過聲音模仿來引導聲音生成,為聲音創作帶來了「人性化」的觸感,提高了聲音作品的藝術價值。

與傳統的文字到音訊互動方式相比,Sketch2Sound能夠克服其限制。以往,聲音設計師需要花費大量時間調整生成聲音的時間特性,使其與視覺效果同步,而Sketch2Sound則可以透過聲音模仿來自然地實現這種同步,並且不僅僅局限於人聲模仿,任何類型的聲音模仿都可以用來驅動這個生成模型。

研究人員還開發了一種技術,透過在訓練過程中應用不同視窗大小的中值濾波器來調整控制訊號的時間細節。這使得聲音藝術家能夠控制生成模型對控制訊號時間精確度的遵循程度,從而提高那些難以完美模仿的聲音的品質。在實際應用中,使用者可以透過調整中位數濾波器的大小,在嚴格遵守聲音模仿和保證音訊品質之間找到平衡。

Sketch2Sound的工作原理是,首先從輸入音訊訊號中提取響度、頻譜質心和音高三個控制訊號。然後,將這些控制訊號與文字到聲音模型中的潛在訊號對齊,並透過簡單的線性投影層調節潛在擴散模型,最終產生符合要求的聲音。實驗結果顯示,透過時變控制訊號調節模型可顯著提高對此訊號的遵守度,同時對音訊品質和文字遵從度的影響微乎其微。

值得一提的是,研究人員也發現,控制訊號可以操縱產生訊號的語意。例如,在使用文字提示“森林氛圍”時,如果在聲音模仿中加入隨機的響度爆發,模型就可以在這些響度爆發中合成鳥鳴聲,而無需額外提示“鳥類”,這表明模型已經學會了響度爆發和鳥類存在之間的關聯。

當然,Sketch2Sound也存在一些局限性,例如質心控制可能會將輸入聲音模仿的房間音調融入到生成的音訊中,這可能是因為當輸入音訊中沒有聲音事件時,房間音調是由質心編碼的。

總而言之,Sketch2Sound是一個強大的生成聲音模型,它可以透過文字提示和時變控制(響度、亮度、音高)來產生聲音。它能夠透過聲音模仿和「草圖」式控製曲線來產生聲音,並且具有輕量化、高效率的特點,為聲音藝術家提供了一種可控、姿態化和富有表現力的工具,能夠生成具有靈活時間特性的任意聲音,未來在音樂創作、遊戲音效設計等領域具有廣闊的應用前景。

論文網址:https://arxiv.org/pdf/2412.08550

Sketch2Sound的出現,預示著聲音創作領域即將迎來一個新的時代,它為藝術家們提供了前所未有的創作自由和可能性,也為音樂、遊戲、電影等領域帶來了無限的想像空間。 相信在不久的將來,這項技術將會得到更廣泛的應用,為我們帶來更豐富多彩的聲音世界。