OpenAI 最新發布的o系列AI模型,旨在透過更深入的規則理解和推理能力,提升AI系統的安全性。有別於以往單純依靠範例學習,該模型能夠主動理解並應用安全指南,有效阻止有害請求。 文章詳細介紹了o1模型的三階段訓練過程,以及其在安全性測試中超越其他主流AI系統的表現。 然而,即使是改進後的o1模型,仍然存在被操縱的可能性,這凸顯了AI安全領域的持續挑戰。

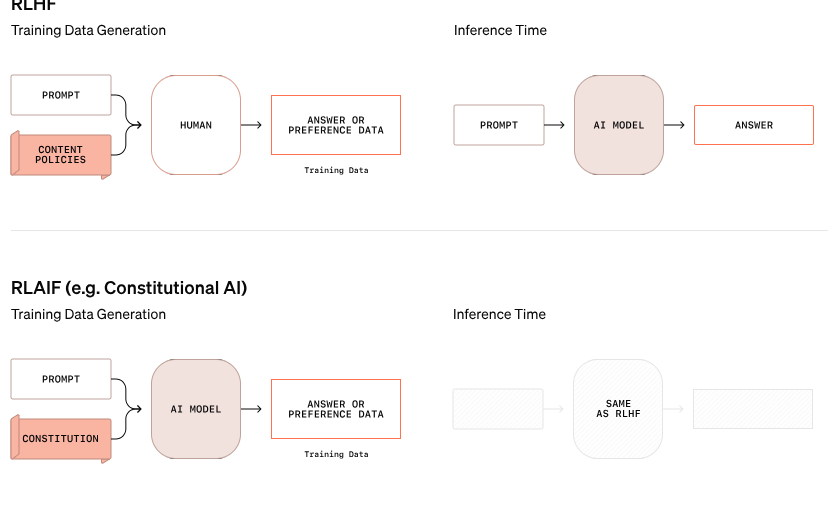

OpenAI 公佈了一種新的AI 安全方法,旨在透過改變AI 系統處理安全規則的方式來提升其安全性。這種新的o 系列模型不再僅僅依賴透過範例學習好與壞行為,而是能夠理解並積極推理特定的安全指南。

OpenAI 的研究中舉了一個例子,當用戶試圖透過加密文字獲取非法活動的指示時,模型成功解碼了訊息,但拒絕了請求,並具體引用了將要違反的安全規則。這種逐步推理的過程顯示了模型如何有效地遵循相關的安全準則。

這款o1模型的訓練過程分為三個階段。首先,模型學習如何提供協助。接下來,透過監督學習,模型會研究特定的安全指南。最後,模型使用強化學習來實踐應用這些規則,這一步驟幫助模型真正理解並內化這些安全指南。

在OpenAI 的測試中,新推出的o1模型在安全性方面表現顯著優於其他主流系統,如GPT-4o、Claude3.5Sonnet 和Gemini1.5Pro。測試內容包括模型如何拒絕有害請求並允許合適請求的通過,結果顯示o1模型在準確性和抵禦越獄嘗試方面均取得了最高分。

OpenAI 的聯合創始人沃伊切赫・扎倫巴在社交平台上表示,他對這種「深思熟慮的對齊」 工作感到非常自豪,認為這種推理模型可以以一種全新的方式進行對齊,特別是在在發展人工通用智慧(AGI)時,確保系統與人類價值一致是一項重大挑戰。

儘管OpenAI 聲稱取得了進展,然而名為「解放者普林尼」 的駭客仍然展示了即便是新的o1和o1-Pro 模型也能被操縱以突破安全指南。普林尼成功讓模型生成成人內容,甚至分享製作莫洛托夫雞尾酒的指示,儘管系統起初拒絕了這些請求。這些事件凸顯控制這些複雜AI 系統的難度,因為它們是基於機率而非嚴格規則進行操作。

扎倫巴表示,OpenAI 有約100名員工專門從事AI 安全和與人類價值觀一致的工作。他對競爭對手的安全處理方式提出了質疑,尤其是埃隆・馬斯克的xAI 公司優先考慮市場增長而非安全措施,而安瑟羅比(Anthropic)最近推出了一款沒有適當保障的AI 代理,扎倫巴認為這會為OpenAI 帶來「巨大的負面回饋」。

官方部落格:https://openai.com/index/deliberative-alignment/

劃重點:

OpenAI 的新o 系列模型能主動推理安全規則,提升系統安全性。

o1模型在拒絕有害請求和準確性方面表現優於其他主流AI 系統。

儘管有改進,但新的模型仍可能被操縱,安全挑戰依舊嚴峻。

總而言之,OpenAI 的o 系列模型在AI 安全領域取得了顯著進展,但同時也暴露出大型語言模型安全性的複雜性和持續性挑戰。 未來需要持續投入更多精力,才能真正有效地應對AI 安全風險。