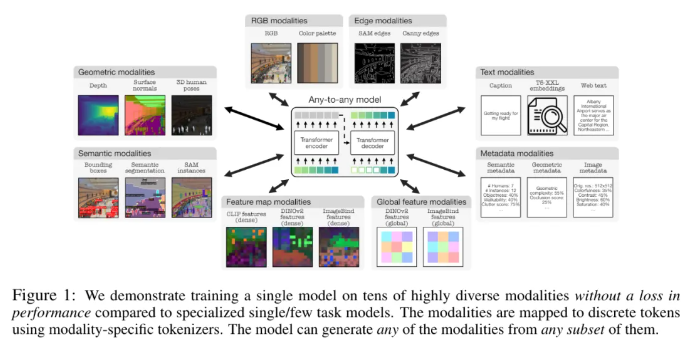

苹果和瑞士洛桑联邦理工学院(EPFL)合作研发了一种突破性的多模态模型——4M-21。该模型能够在21种不同模态上进行训练,其性能显著优于现有模型,实现了跨模态检索、可控生成等多种功能。这项研究通过扩大模型和数据集规模,增加训练模态类型和数量,并采用联合训练策略,极大地提升了模型的性能和适应性。4M-21模型在架构上采用了基于Transformer的编码器-解码器架构,并添加了额外的模态嵌入以适应新的模态,其训练过程充分考虑了不同模态的特性,并使用了特定于模态的tokenization方法。

该研究采用了4M 预训练方案,通过扩大模型和数据集的规模、增加训练模型所涉及的模态类型和数量,并且在多个数据集上进行联合训练,可以提升模型的性能和适应性。研究人员使用不同的 tokenization 方法来离散具有不同特征的模态,如全局图像嵌入、人体姿态和语义实例。在架构选择上,该研究采用基于 Transformer 的4M 编码器 - 解码器架构,并添加额外的模态嵌入以适应新模态。

该模型不仅可以开箱即用地执行一系列常见的视觉任务,如 DIODE 表面法线和深度估计、COCO 语义和实例分割、3DPW3D 人体姿态估计等,还能够生成任意训练模态、支持几种方法来执行细粒度和多模态生成,以及可以通过使用其他模态作为查询来检索 RGB 图像或其他模态。此外,研究人员还在 NYUv2、Hypersim 语义分割和 ARKitScenes 上进行了多模态传输实验。

其重要的功能特点包括:

任意到任意模态:从现有最佳任意到任意模型的7种模态增加到21种不同模态,实现跨模态检索、可控生成和强大的开箱即用性能。

多样性支持:添加对更多结构化数据的支持,例如人体姿态、SAM 实例、元数据等等。

Tokenization:使用特定于模态的方法研究不同模态的离散 tokenization,例如全局图像嵌入、人体姿态和语义实例。

扩展:将模型大小扩展至3B 参数,将数据集扩展至0.5B 样本。

协同训练:同时在视觉和语言上协同训练。

论文地址:https://arxiv.org/pdf/2406.09406

划重点:

- 苹果和瑞士洛桑联邦理工学院(EPFL)研究人员联合开发了一种任意到任意模态的单一模型,可以在21种不同的模态下进行训练。

- 该模型可以开箱即用地执行一系列常见的视觉任务,还能够生成任意训练模态、支持几种方法来执行细粒度和多模态生成。

- 研究人员还在 NYUv2、Hypersim 语义分割和 ARKitScenes 上进行了多模态传输实验。

总而言之,4M-21模型在多模态研究领域取得了显著进展,其强大的性能和广泛的应用前景,为未来多模态人工智能的发展提供了新的方向。 该模型的开源以及未来应用值得期待。