中山大學和位元組智創數位人團隊合作研發出一款名為MMTryon的虛擬試穿框架,該框架只需輸入服裝圖片和穿法文字指令,即可一鍵生成高品質的模特兒試穿效果,支援真人和漫畫人物,大大簡化了虛擬試穿流程。這項技術突破了傳統演算法的局限,實現了對複雜換裝場景和任意服裝款式的精準處理,無需對服裝進行精細分割,大幅提高了效率和便捷性。

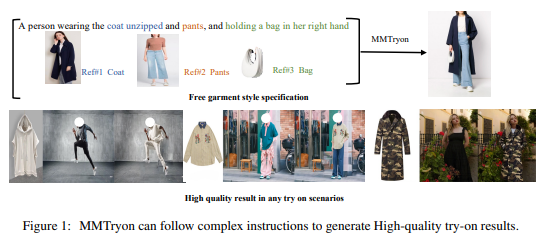

最近,中山大學和位元組智創數位人團隊搞了個大新聞,他們提出了一個叫做MMTryon的虛擬試穿框架。這玩意兒可不簡單,只要輸入幾件衣服的圖片,再加上幾句穿法的文字指令,就能一鍵生成模特兒試穿效果,而且品質還特別高。

想像一下,你選了一件大衣、一條褲子,再搭個包,然後「啪」的一下,它們就自動穿到了人像上。不管你是真人還是漫畫人物,都能一鍵搞定,這操作簡直不要太酷炫!

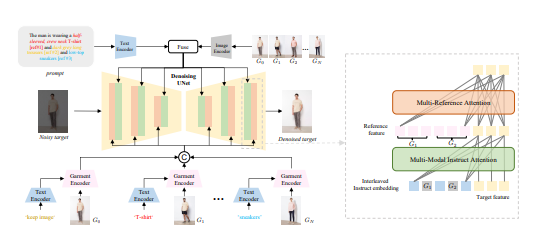

而且,MMTryon的厲害之處還不止於此。它在單圖換裝方面,利用了大量的數據設計了一個服裝編碼器,能夠處理各種複雜的換裝場景和任意服裝款式。至於組合換裝,它更是打破了傳統演算法對服裝精細分割的依賴,一條文字指令就能搞定,生成的效果既真實又自然。

在基準測試中,MMTryon直接拿下了新SOTA,這成績可不是蓋的。研究團隊也搞了個多模態多參考注意機制,讓換裝效果更精確、更靈活。以前的虛擬試穿方案,要嘛只能試穿單件,要嘛對穿搭風格束手無策。但現在,MMTryon統統給你解決。

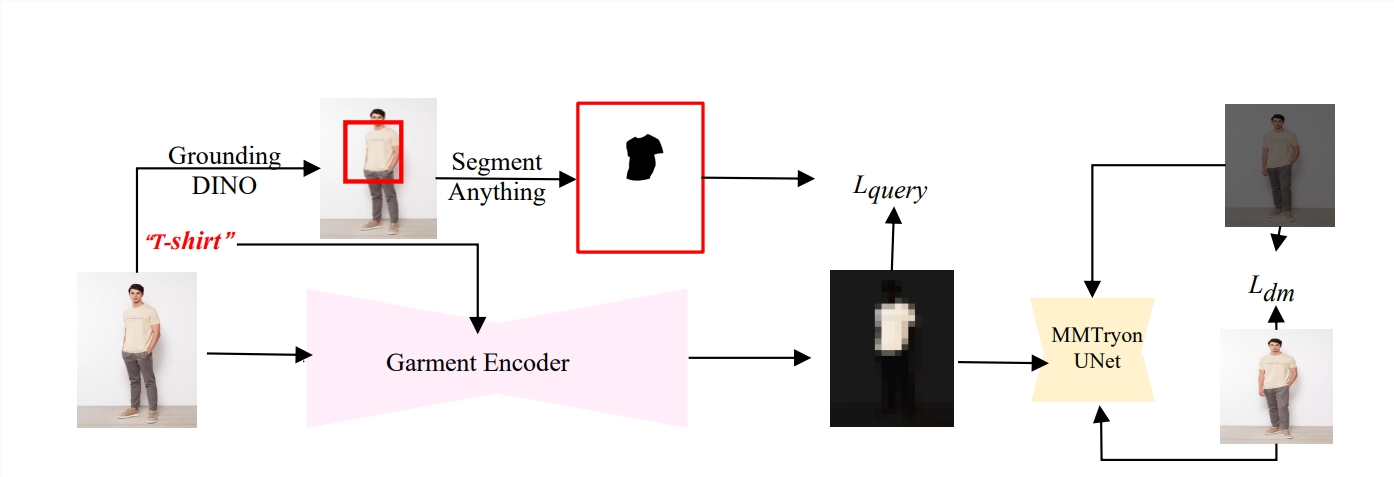

而且,MMTryon還特別聰明,它用了一個表徵能力豐富的服裝編碼器,加上新穎的可擴展資料生成流程,讓換裝過程無需任何分割,直接透過文字和多個試穿物件就能實現高品質虛擬換裝。

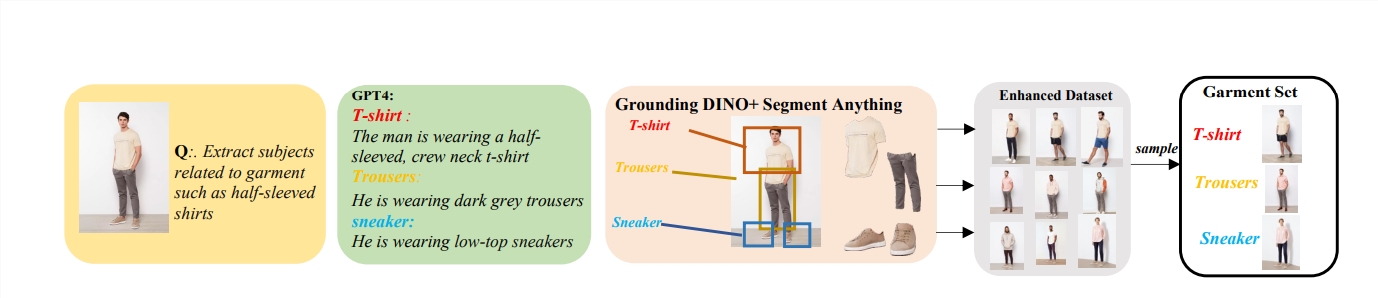

在開源資料集和複雜場景下的大量實驗證明,MMTryon在定性和定量上都優於現有的SOTA方法。研究團隊還預先訓練了一個服裝編碼器,利用文本作為query,激活文本對應區域的特徵,擺脫了對服裝分割的依賴。

更牛的是,為了訓練組合換裝,研究團隊提出了一個基於大模型的資料擴增模式,建構了100w的增強資料集,讓MMTryon在各種類型的換裝上都能有真實的虛擬試穿效果。

MMTryon就像是個時尚界的黑科技,不僅能幫你一鍵試穿,還能作為一個fashion換裝輔助設計,幫你挑衣服。在量化指標和Human evaluation上,MMTryon都超越了其他baseline模型,效果槓槓的。

論文網址:https://arxiv.org/abs/2405.00448

總而言之,MMTryon憑藉其高效、精準和便利的虛擬試穿功能,在時尚領域展現出巨大的應用潛力,為服裝設計和購物體驗帶來了革命性的變化。其領先的技術和出色的性能使其成為虛擬試穿領域的新標竿。