随着多模态大型语言模型(MLLM)的快速发展,将视觉、语言和语音模态有效整合成为研究热点。然而,不同模态数据本质差异带来的挑战,例如视觉的空间信息与语音的时间序列信息,阻碍了高效的多模态交互。现有方法常依赖独立的ASR和TTS模块,增加了延迟并降低了交互的流畅性。本文介绍了VITA-1.5,一个整合视觉、语言和语音的多模态大型语言模型,旨在解决这些问题。

最近,多模态大型语言模型(MLLM)取得了显著进展,特别是在视觉和文本模态的集成方面。但随着人机交互的日益普及,语音模态的重要性也日益凸显,尤其是在多模态对话系统中。语音不仅是信息传输的关键媒介,还能显著提高交互的自然性和便利性。

然而,由于视觉和语音数据在本质上的差异,将它们整合到 MLLM 中并非易事。例如,视觉数据传达空间信息,而语音数据则传达时间序列中的动态变化。这些根本性的差异给两种模态的同步优化带来了挑战,常常导致训练过程中的冲突。此外,传统的语音到语音系统依赖于独立的自动语音识别(ASR)和文本到语音(TTS)模块,这会增加延迟并降低连贯性,限制了其在实时应用中的实用性。

为了解决这些挑战,研究人员推出了 VITA-1.5,这是一款集成了视觉、语言和语音的多模态大型语言模型。VITA-1.5采用精心设计的三阶段训练方法,逐步引入视觉和语音数据,缓解模态冲突,同时保持强大的多模态性能。

在第一阶段,模型专注于视觉-语言训练,通过训练视觉适配器并使用描述性字幕和视觉问答数据微调模型,建立强大的视觉能力。

第二阶段引入音频输入处理,通过使用语音转录配对数据训练音频编码器,然后使用语音问答数据进行微调,使模型能够有效地理解和响应音频输入。最后,在第三阶段,训练音频解码器以实现端到端语音输出,无需外部 TTS 模块,从而使 VITA-1.5能够生成流畅的语音回复,增强多模态对话系统的自然性和交互性。

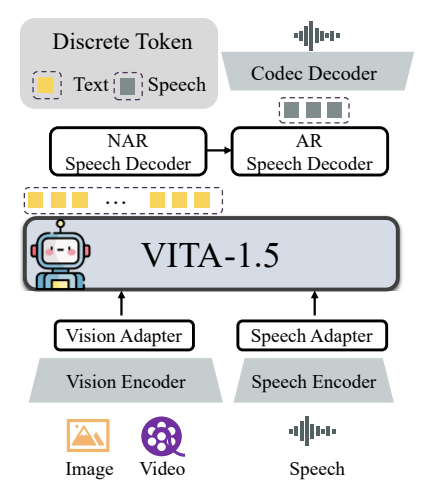

VITA-1.5的整体架构包括视觉和音频编码器以及连接到大型语言模型的适配器。输出端则具有一个端到端的语音生成模块,而不是像最初的 VITA-1.0版本那样使用外部 TTS 模型。视觉编码器采用 InternViT-300M,输入图像大小为448×448像素,每张图像生成256个视觉令牌。

对于高分辨率图像,VITA-1.5采用动态修补策略来捕获局部细节。视频则被视为一种特殊的多图像输入类型,根据视频长度对帧进行采样。音频编码模块由多个下采样卷积层和24个 Transformer 块组成,输出帧率为12.5Hz。音频适配器由多个具有2倍下采样的卷积层组成。TiCodec 被用作编解码器模型,它将连续的语音信号编码成离散的语音令牌,频率为40Hz,并能够将它们解码回采样率为24,000Hz 的语音信号。为了使模型能够输出语音令牌,在文本令牌之后添加了两个语音解码器:非自回归(NAR)语音解码器和自回归(AR)语音解码器。

VITA-1.5的训练数据涵盖了广泛的类别,如字幕数据和问答数据,包括中文和英文。在不同的训练阶段,会选择性地采样整个数据集的子集,以服务于不同的目标。训练策略分三个阶段进行:

第一阶段:视觉-语言训练,包括视觉对齐、视觉理解和视觉有监督微调,旨在弥合视觉和语言之间的差距,并使模型能够理解图像内容和回答视觉问题。

第二阶段:音频输入调优,包括音频对齐和音频有监督微调,旨在使模型能够理解音频输入,并能够通过语音提问和文本回答进行交互。

第三阶段:音频输出调优,包括编解码器训练和 NAR + AR 解码器训练,旨在使模型能够生成语音输出,实现端到端的语音交互。

研究人员对图像、视频和语音理解的各种基准进行了广泛的评估,并将结果与开源和专有模型进行了比较。结果表明,VITA-1.5在图像和视频任务上表现出了与领先的 MLLM 相媲美的感知和推理能力,并在语音能力方面取得了显著改进。例如,在图像理解基准测试中,VITA-1.5的性能与最先进的开源模型相当,甚至超过了一些封闭源模型。在视频理解方面,VITA-1.5的表现与顶级开源模型相当。此外,VITA-1.5在中文和英文的 ASR 任务中都取得了领先的准确率,超越了专业的语音模型。

总的来说,VITA-1.5通过精心设计的三阶段训练策略,成功地将视觉和语音集成在一起,实现了强大的视觉和语音理解能力,从而能够进行高效的语音到语音交互,而无需依赖单独的 ASR 或 TTS 模块。这项研究有望推动开源模型在实时多模态交互领域的进步。

项目地址:https://github.com/VITA-MLLM/VITA

VITA-1.5的出现标志着多模态大型语言模型发展的新阶段,其端到端的语音生成能力以及在图像、视频和语音理解任务上的优异表现,为未来构建更自然、更流畅的多模态交互系统提供了新的可能性。 这项研究成果值得关注,并有望在实际应用中发挥重要作用。