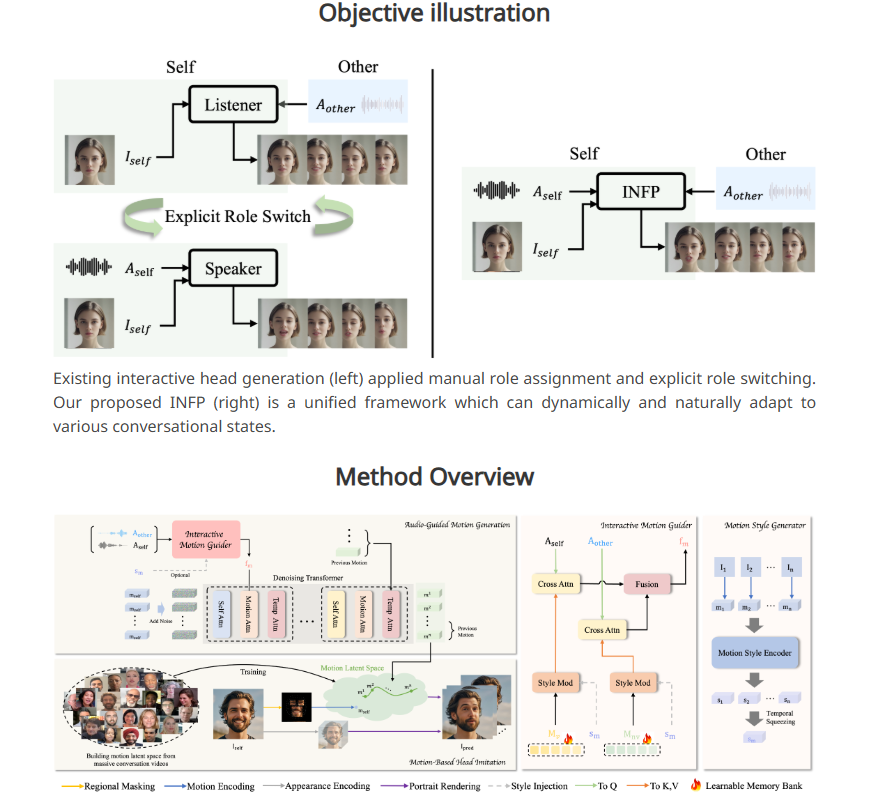

位元組跳動推出全新AI系統INFP,該系統能夠使靜態人物肖像照片透過音訊輸入「說話」並做出反應。不同於傳統技術,INFP無需手動指定角色,系統可根據對話自動判斷,大幅提升了效率和便利性。其核心技術在於「基於運動的頭部模仿」和「音訊引導運動生成」兩個步驟,透過分析對話中的面部表情、頭部運動和音訊輸入,產生自然流暢的運動模式,使靜態圖像栩栩如生。為了訓練INFP,位元組跳動還建立了包含200多小時真實對話影片的DyConv資料集,確保系統的高品質輸出。

INFP 的工作流程分為兩個主要步驟。第一步,稱為“基於運動的頭部模仿”,該系統通過分析人們在對話中的面部表情和頭部運動,從影片中提取細節。這些運動數據會被轉化為可以用於後續動畫的格式,使靜態照片能夠與原始人物的運動相匹配。

第二步是“音訊引導運動產生”,系統則根據音訊輸入產生自然的運動模式。研究團隊開發了一種“運動引導器”,該工具透過分析對話雙方的音頻,創造出說話和傾聽的運動模式。隨後,名為擴散變換器的AI 組件對這些模式進行逐步優化,從而產生流暢且真實的運動,完美契合音訊內容。

為了對系統進行有效訓練,研究團隊還建立了一個名為DyConv 的對話資料集,匯集了200多個小時的真實對話影片。與現有的對話資料庫(如ViCo 和RealTalk)相比,DyConv 在情緒表達和視訊品質方面具有獨特優勢。

位元組跳動表示,INFP 在多個關鍵領域的表現優於現有工具,特別是在與語音匹配的唇部運動、保留個體面部特徵以及創造多樣化自然動作方面。此外,該系統在產生僅聽對話者的影片時同樣表現出色。

雖然目前INFP 僅支援音訊輸入,研究團隊正在探索將系統擴展到圖像和文字的可能性,未來目標是能夠創造出人物全身的真實動畫。然而,考慮到這類技術可能被用於製造虛假視訊和傳播錯誤訊息,研究團隊計劃將核心技術限制在研究機構使用,類似於微軟對其先進語音克隆系統的管理。

這項技術是位元組跳動更廣泛AI 策略的一部分,依託其旗下的熱門應用TikTok 和CapCut,位元組跳動擁有廣闊的AI 創新應用平台。

專案入口:https://grisoon.github.io/INFP/

劃重點:

INFP 可以讓靜態人像透過音訊實現“說話”,自動判斷對話角色。

該系統透過兩個步驟工作:首先提取人類對話中的運動細節,其次將音訊轉換為自然的運動模式。

位元組跳動的DyConv 資料集包含超過200小時的高品質對話視頻,幫助提升系統效能。

INFP 系統的推出展現了位元組跳動在人工智慧領域的創新實力,其未來發展潛力巨大,但也需要謹慎應對潛在的倫理風險。 科技的進步應始終以社會利益為導向,確保其被用於造福人類。