本文介紹了位元組跳動和中國科學技術大學研究團隊提出的新型擴散模型適配器VMix,旨在提昇文字到影像生成的品質和美學效果。 VMix透過巧妙的條件控制方法,在不重新訓練模型的情況下,增強現有擴散模型的美學表現,並保持圖像與文字描述的一致性。它將文字提示分解為內容和美學描述,並透過混合交叉注意力機制,將美學訊息融入圖像生成過程,實現對圖像美學的細粒度控制。該適配器與多種社區模型相容,具有廣泛的應用前景。

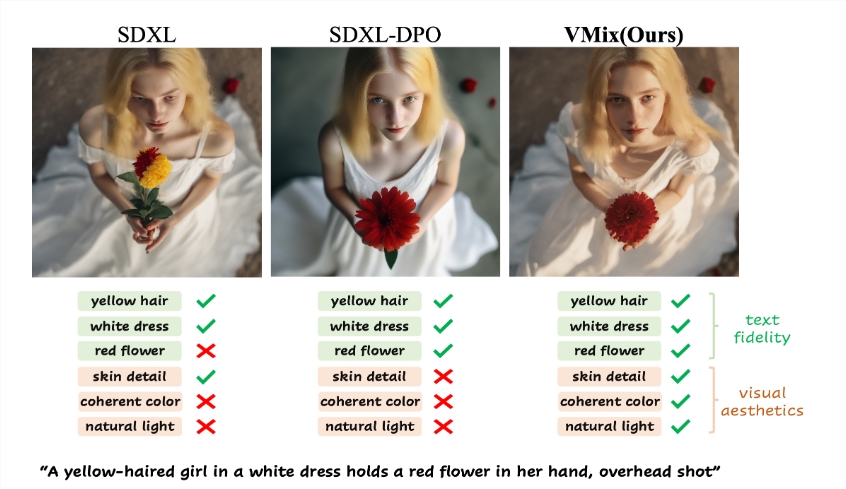

在文字生成圖像的領域,擴散模型展現了非凡的能力,但在美學圖像生成方面仍存在一定的不足。最近,來自位元組跳動和中國科學技術大學的研究團隊提出了一種名為“Cross-Attention Value Mixing Control”(VMix)適配器的新技術,旨在提升生成圖像的質量,並保持對各種視覺概念的通用性。

VMix 適配器的核心思想在於,透過設計優越的條件控制方法,增強現有擴散模型的美學表現,同時確保圖像與文字之間的對齊。

該適配器主要透過兩個步驟實現其目標:首先,它透過初始化美學嵌入,將輸入的文字提示分解為內容描述和美學描述;其次,在去噪過程的過程中,透過混合交叉注意力的方式,將美學條件融入其中,,從而提升圖片的美學效果,並保持圖片和提示詞的一致性。 。這種方法的靈活性使得VMix 能夠在不進行重訓練的情況下,應用於多個社群模型,從而提高視覺表現。

研究人員透過一系列實驗驗證了VMix 的有效性,結果顯示該方法在美學影像生成方面的表現超越了其他最先進的方法。同時,VMix 也與多種社群模組(如LoRA、ControlNet 和IPAdapter)相容,進一步拓寬了其應用範圍。

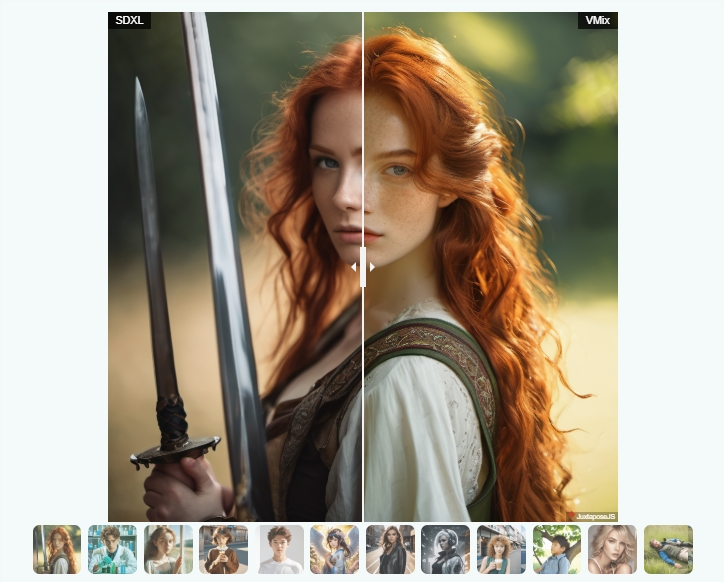

VMix 的美學細粒度控制能力,體現在調整美學嵌入時,可以透過單維美學標籤來改善影像的特定維度,或透過完整的正面美學標籤來整體提升影像品質。在實驗中,當使用者給定如「一個女孩靠在窗邊,微風拂過,夏日肖像,半身中景」 的文本描述時,VMix 適配器能夠顯著提升生成圖像的美感。

VMix 適配器為提昇文字到影像生成的美學品質開闢了新的方向,未來有望在更廣泛的應用中發揮其潛力。

專案入口:https://vmix-diffusion.github.io/VMix/

劃重點:

VMix 適配器透過美學嵌入將文字提示分解為內容和美學描述,增強影像生成品質。

此轉接器相容於多個社群模型,使用者無需重訓練即可提升影像視覺效果。

實驗結果表明,VMix 在美學生成方面的表現優於現有技術,具有廣泛的應用潛力。

總而言之,VMix 轉接器為提升AI影像生成的藝術性和美感提供了有效方案,其在相容性和易用性方面也表現突出,為未來影像生成技術的發展提供了新的方向和可能性。