Meta最新發布的Multi-IF基準測試,旨在更全面地評估大語言模型(LLM)在多輪對話和多語言環境下的指令遵循能力。有別於以往多關注單輪單語言的評估標準,Multi-IF涵蓋八種語言,包含4501個三輪對話任務,力求模擬真實應用場景的複雜性,為LLM的評估提供一個更嚴謹、更具挑戰性的標準。此基準測試結果揭示了目前LLM在多輪對話和多語言任務上的諸多不足,為未來模型的改進方向提供了寶貴參考。

Meta 最近發布了一項全新的基準測試,名為Multi-IF,旨在評估大語言模型(LLM)在多輪對話和多語言環境下的指令遵循能力。這項基準涵蓋了八種語言,包含4501個三輪對話任務,重點探討了目前模型在複雜多輪和多語言場景中的表現。

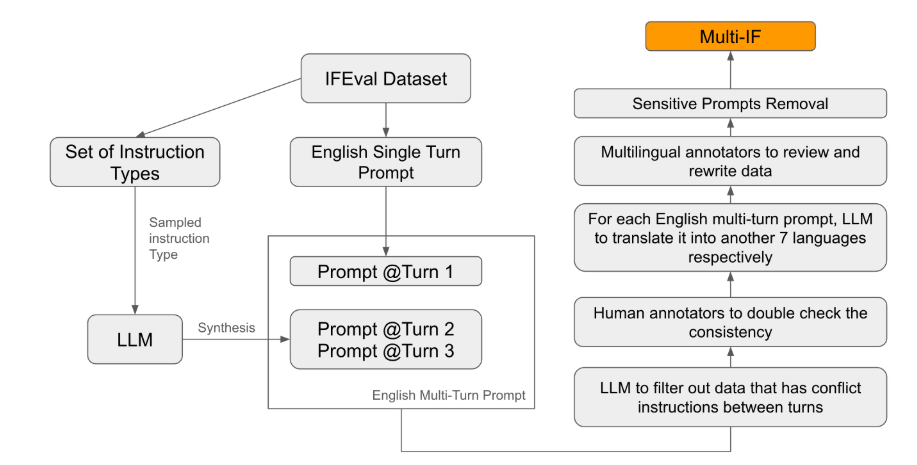

在現有的評估標準中,大多數集中在單輪對話和單語言任務,難以全面反映模型在實際應用中的表現。而Multi-IF 的推出正是為了填補這一空缺。研究團隊透過將單輪指令擴展為多輪指令,產生了複雜的對話場景,並確保每一輪指令在邏輯上連貫、遞進。此外,資料集還透過自動翻譯和手動校對等步驟實現了多語言支援。

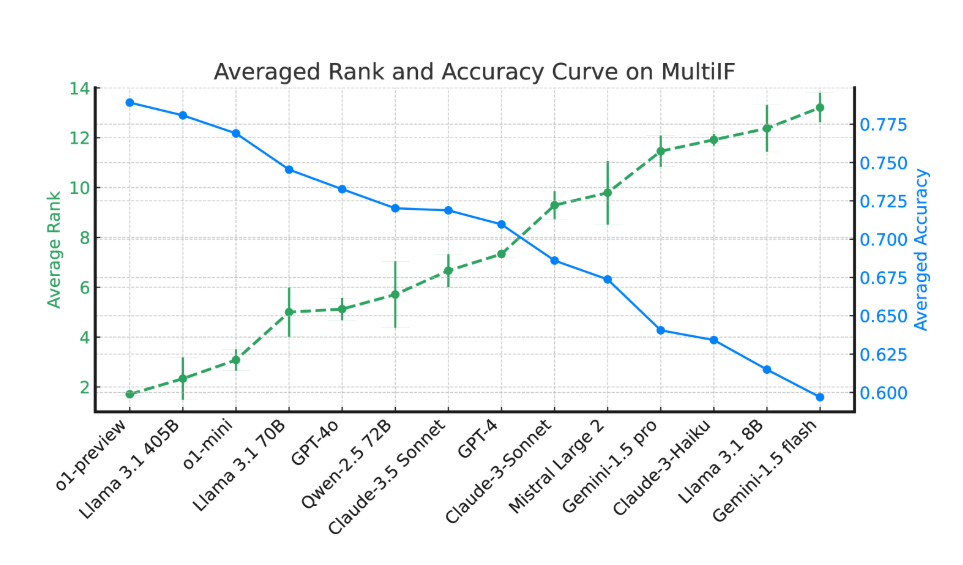

實驗結果顯示,大多數LLM 在多輪對話中的表現顯著下降。以o1-preview 模型為例,其在第一輪的平均準確率為87.7%,但到了第三輪下降至70.7%。特別是在非拉丁文字的語言中,如印地語、俄語和中文,模型的表現普遍低於英語,顯示出在多語言任務上的限制。

在14種前沿語言模型的評估中,o1-preview 和Llama3.1405B 表現最佳,三輪指令的平均準確率分別為78.9% 和78.1%。然而,在多輪對話中,所有模型的指令遵循能力普遍下降,反映出模型在複雜任務中的挑戰。研究團隊也引入了「指令遺忘率」(IFR)來量化模型在多輪對話中的指令遺忘現象,結果顯示高性能模型在這方面的表現相對較好。

Multi-IF 的發佈為研究人員提供了一個具有挑戰性的基準,推動了LLM 在全球化和多語言應用中的發展。這項基準的推出,不僅揭示了目前模型在多輪、多語言任務中的不足,也為未來改進提供了明確方向。

論文:https://arxiv.org/html/2410.15553v2

劃重點:

Multi-IF 基準涵蓋八種語言,包含4501個三輪對話任務,評估LLM 在複雜場景中的表現。

實驗顯示,多數LLM 在多輪對話中的準確率顯著下降,尤其在非拉丁文字的語言中表現較弱。

o1-preview 和Llama3.1405B 模型表現最佳,三輪指令的平均準確率分別為78.9% 和78.1%。

總而言之,Multi-IF基準的出現為大語言模型的評估提供了一個新的方向,其對多輪對話和多語言支援的關注,將有助於推動LLM技術在全球範圍內的應用和發展,促進更聰明、更貼近實際應用的模型的誕生。