大型語言模型(LLM)在許多領域展現出驚人的能力,然而,一項最新研究卻揭示了它們在算術推理方面的「奇葩」弱點:這些「天才」AI竟然在簡單的數學運算中頻頻出錯!研究人員深入分析了Llama3、Pythia和GPT-J等多個LLM,發現它們並非依靠強大的算法或記憶力進行計算,而是採用一種“啟發式大雜燴”的策略,如同一個靠“小聰明”和“經驗法則」蒙答案的學生。

最近,AI 大型語言模型(LLM)在各種任務中表現出色,寫詩、寫代碼、聊天都不在話下,簡直是無所不能!但是,你敢相信嗎?這些“天才”AI 居然是“數學菜鳥」!它們在處理簡單的算術題時經常翻車,讓人大跌眼鏡。

一項最新的研究揭開了LLM 算術推理能力背後的「奇葩」秘訣:它們既不依賴強大的演算法,也不完全依靠記憶,而是採用了一種被稱為「啟發式大雜燴」的策略!這就好比一個學生,沒有認真學習數學公式和定理,而是靠著一些「小聰明」和「經驗法則」來蒙答案。

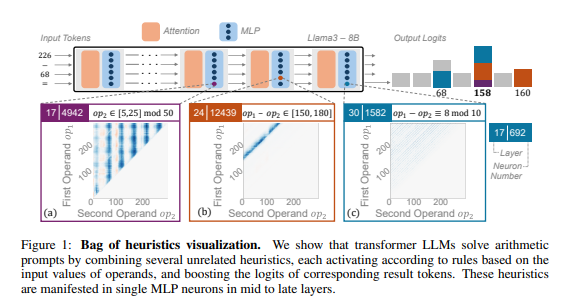

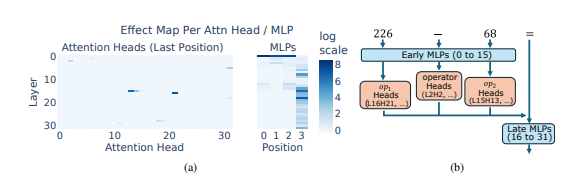

研究人員以算術推理作為典型任務,對Llama3、Pythia 和GPT-J 等多個LLM 進行了深入分析。他們發現,LLM 模型中負責算術計算的部分(稱為“電路”)是由許多單一神經元組成的,每個神經元都像一個“微型計算器”,只負責識別特定的數位模式並輸出對應的答案。 例如,一個神經元可能專門負責識別“個位數是8的數字”,另一個神經元則負責識別“結果在150到180之間的減法運算”。

這些「微型計算器」就像一堆雜亂無章的工具,LLM 並非按照特定的演算法來使用它們,而是根據輸入的數字模式,隨機地組合使用這些「工具」來計算答案。 這就像一個廚師,沒有固定的食譜,而是根據手邊現有的食材,隨意搭配,最終做出一道「黑暗料理」。

更令人驚訝的是,這種「啟發式大雜燴」的策略居然在LLM 訓練的早期就出現了,並且隨著訓練的進行逐漸完善。這意味著,LLM 從一開始就依賴這種「拼湊」式的推理方法,而不是在後期才發展出這種策略。

那麼,這種「奇葩」的算術推理方法會導致什麼問題呢?研究人員發現,「啟發式大雜燴」策略的泛化能力有限,容易出現錯誤。 這是因為LLM 所掌握的「小聰明」數量有限,而且這些「小聰明」本身也可能有缺陷,導致它們在遇到新的數字模式時無法給出正確答案。 就像一個只會做“番茄炒蛋”的廚師,突然讓他做一道“魚香肉絲”,他肯定會手忙腳亂,不知所措。

這項研究揭示了LLM 算術推理能力的局限性,也為未來改進LLM 的數學能力指明了方向。 研究人員認為,僅依靠現有的訓練方法和模型架構可能不足以提升LLM 的算術推理能力,需要探索新的方法來幫助LLM 學習更強大、更泛化的演算法,讓它們真正成為“數學高手” 。

論文網址:https://arxiv.org/pdf/2410.21272

這項研究不僅解釋了LLM在數學計算上的不足,更重要的是為未來LLM的改進提供了寶貴的參考方向。 未來的研究需要關注如何提升LLM的泛化能力和演算法學習能力,以解決其在算術推理上的缺陷,使其真正具備強大的數學能力。