Salesforce AI 研究團隊發布了最新的多模態語言模型BLIP-3-Video,旨在高效處理日益增長的視頻數據。傳統的視頻理解模型效率低下,BLIP-3-Video 通過創新的時序編碼器,將視頻信息壓縮至16到32個視覺標記,極大提升了計算效率,同時保持了高準確率。此舉解決了處理長視頻的難題,為自動駕駛、娛樂等行業提供更強大的視頻理解能力。

最近,Salesforce AI 研究團隊推出了一款全新的多模態語言模型——BLIP-3-Video。隨著視頻內容的快速增加,如何高效處理視頻數據成為了一個亟待解決的問題。這款模型的出現,旨在提升視頻理解的效率和效果,適用於從自動駕駛到娛樂等各個行業。

傳統的視頻理解模型往往是逐幀處理視頻,生成大量的視覺信息。這一過程不僅消耗了大量的計算資源,還極大地限制了處理長視頻的能力。隨著視頻數據量的不斷增長,這種方法變得愈發低效,因此,找到一種既能捕捉到視頻的關鍵信息,又能減少計算負擔的解決方案至關重要。

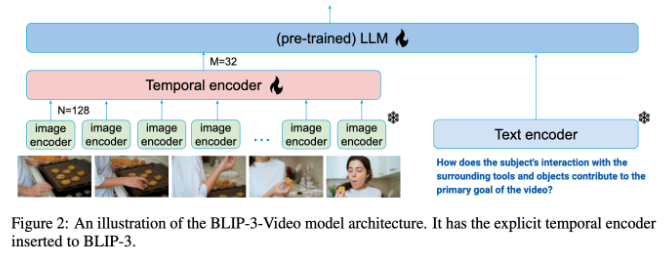

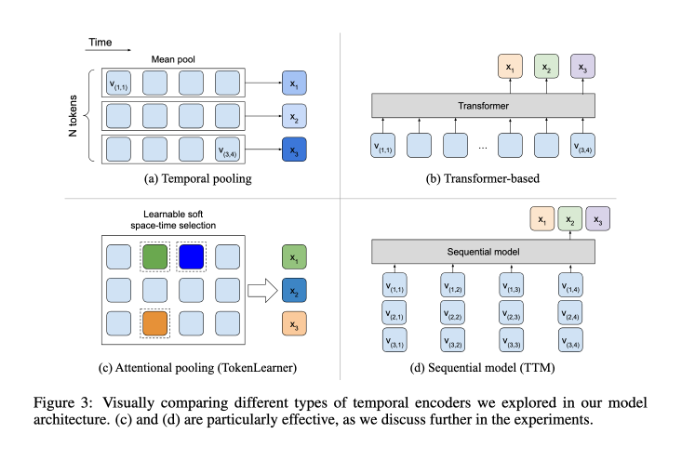

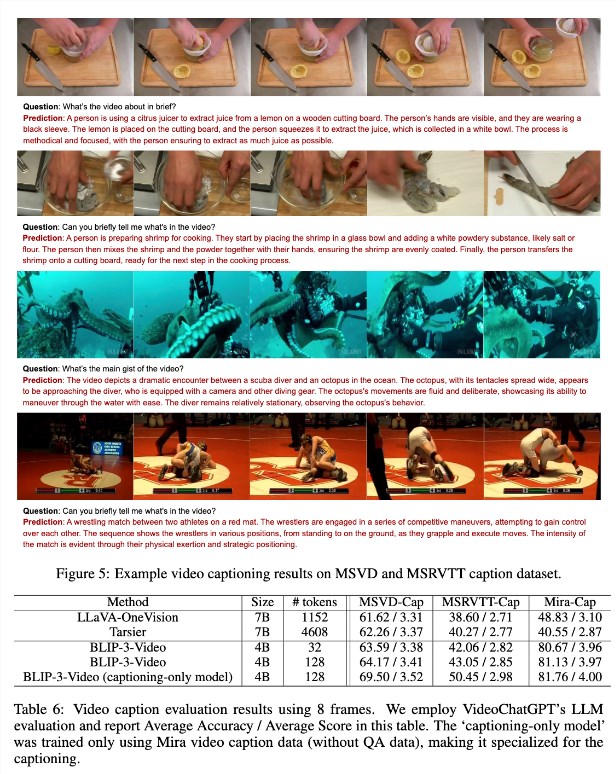

在這方面,BLIP-3-Video 表現得相當出色。該模型通過引入“時序編碼器”,成功將視頻中所需的視覺信息數量減少到16到32個視覺標記。這一創新設計大大提高了計算效率,讓模型能夠以更低的成本完成複雜的視頻任務。這個時序編碼器採用了一種可學習的時空注意力池化機制,能夠從每一幀中提取最重要的信息,將其整合成一個緊湊的視覺標記集。

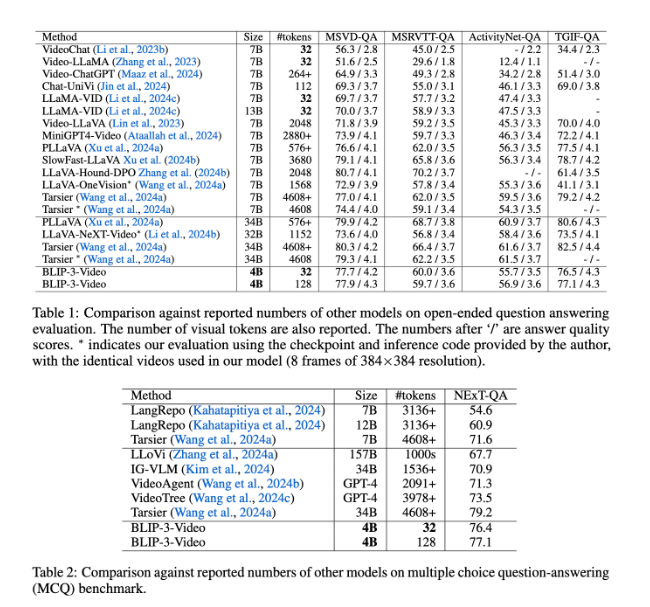

BLIP-3-Video 的表現也非常出色。通過與其他大型模型的比較,研究發現,該模型在視頻問答任務中的準確率與頂尖模型相當。例如,Tarsier-34B 模型處理8幀視頻需要4608個標記,而BLIP-3-Video 只需32個標記,就能實現77.7% 的MSVD-QA 基準得分。這顯示出BLIP-3-Video 在維持高性能的同時,顯著減少了資源消耗。

此外,BLIP-3-Video 在多項選擇問答任務中的表現同樣不容小覷。在NExT-QA 數據集中,模型取得了77.1% 的高分,而在TGIF-QA 數據集中,也達到了77.1% 的準確率。這些數據都表明,BLIP-3-Video 在處理複雜視頻問題時的高效性。

BLIP-3-Video 通過創新的時序編碼器,在視頻處理領域開闢了新的可能性。這款模型的推出,不僅提升了視頻理解的效率,也為未來的視頻應用提供了更多可能性。

項目入口:https://www.salesforceairesearch.com/opensource/xGen-MM-Vid/index.html

劃重點:

- ** 新模型發布**:Salesforce AI 研究推出BLIP-3-Video,多模態語言模型,專注於視頻處理。

- ** 高效處理**:採用時序編碼器,大幅減少所需視覺標記數量,顯著提升計算效率。

- ** 優越表現**:在視頻問答任務中表現優異,保持高準確率,同時減少資源消耗。

總而言之,BLIP-3-Video憑藉其高效的處理能力和優異的性能,為視頻理解領域帶來了顯著的進步,其應用前景廣闊。 該模型的開源也為進一步的研究和應用提供了良好的基礎。