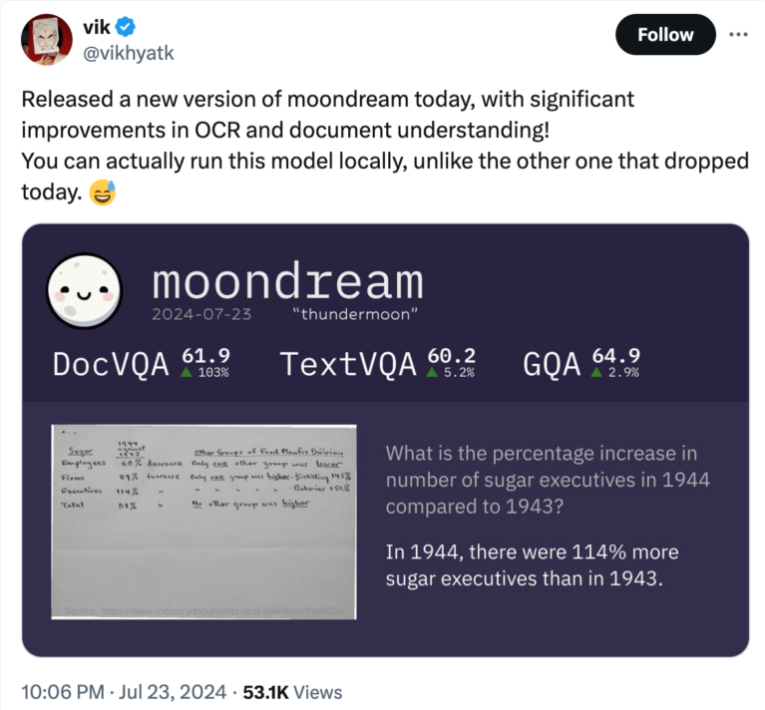

西雅圖初創公司Moondream發布了緊湊型視覺語言模型moondream2,其僅有16億參數,卻在各項基準測試中表現出色,甚至優於一些參數量更大的模型。作為開源模型,moondream2可在智能手機等低性能設備上本地運行,具備強大的圖像和文本處理能力,包括問答、OCR、物體計數和分類等功能。其在DocVQA、TextVQA和GQA上的得分均超過60%,展現了其在本地執行時的強大能力。 Moondream已獲得450萬美元種子輪融資,並持續更新模型,提升其性能。

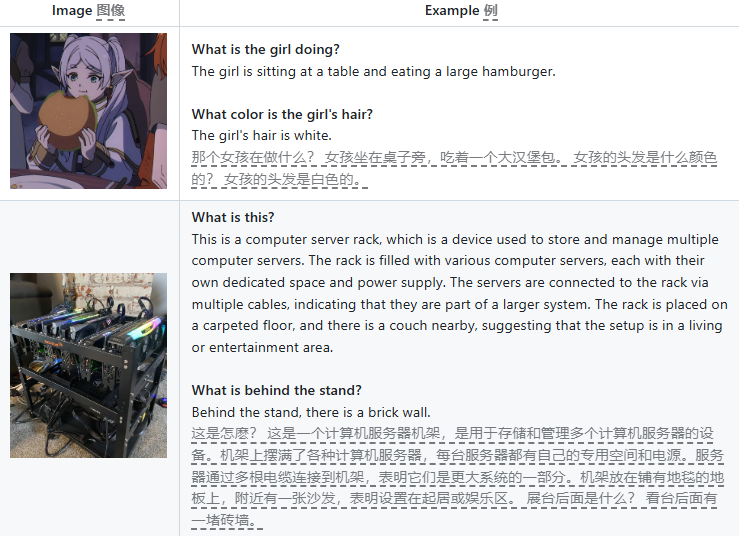

最近,西雅圖的一家初創公司Moondream 推出了名為moondream2的緊湊型視覺語言模型。儘管體積小巧,但該模型在各項基準測試中表現出色,備受關注。作為一個開源模型,moondream2有望在智能手機上實現本地圖像識別功能。

moondream2於三月正式發布,該模型能夠處理文本和圖像輸入,具備回答問題、文本提取(OCR)、物體計數和物品分類等能力。自發布以來,Moondream 團隊持續更新該模型,不斷提升其基準性能。 7月份的版本在OCR 和文檔理解方面顯示出顯著進步,尤其是在對歷史經濟數據的分析中表現出色。該模型在DocVQA、TextVQA 和GQA 的得分均超過60%,顯示出其在本地執行時的強大能力。

moondream2的一個顯著特點是其緊湊的尺寸:僅有16億個參數,這使得它不僅能夠在雲服務器上運行,也可以在本地計算機甚至一些性能較低的設備如智能手機或單板計算機上運行。

儘管體積小,但其性能卻與一些參數量達數十億的競爭模型相當,甚至在某些基準測試中表現優於這些較大模型。

在對移動設備視覺語言模型的比較中,研究人員指出,儘管moondream2的參數量僅為1.7億,但其性能與7億參數的模型相當,僅在SQA 數據集的表現稍遜一籌。這表明,儘管小型模型表現出色,但在理解特定上下文方面仍面臨挑戰。

該模型的開發者Vikhyat Korrapati 表示,moondream2是基於其他模型如SigLIP、微軟的Phi-1.5和LLaVA 訓練數據集所構建的。該開源模型現已在GitHub 上免費提供下載,並在Hugging Face 上展示了其演示版本。在編碼平台上,moondream2也引起了開發者社區的廣泛關注,獲得了超過5000個星級評價。

此次成功吸引了投資者的目光:在由Felicis Ventures、微軟的M12GitHub 基金和Ascend 領投的種子輪融資中,Moondream 成功籌集了450萬美元。公司的CEO Jay Allen 曾在亞馬遜網絡服務(AWS)工作多年,領導著這家不斷發展的初創企業。

moondream2的推出標誌著一系列經過專業優化的開源模型的誕生,這些模型在提供與更大、更舊模型相似的性能時,所需的資源更少。目前市場上雖然已有一些小型的本地模型,比如蘋果的智能助手和谷歌的Gemini Nano,但這兩家廠商仍然將更複雜的任務外包給雲端解決。

huggingface:https://huggingface.co/vikhyatk/moondream2

github:https://github.com/vikhyat/moondream

劃重點:

Moondream 推出了moondream2,一個僅有1.6億參數的視覺語言模型,能在智能手機等小型設備上運行。

該模型具備強大的文本和圖像處理能力,能夠回答問題、進行OCR、物體計數和分類,基準測試表現出色。

Moondream 成功籌集450萬美元資金,CEO 曾在亞馬遜工作,團隊持續更新提升模型性能。

moondream2的出現,為移動端AI應用帶來了新的可能性,其開源特性也促進了開發者社區的積極參與和創新。未來,隨著技術的不斷發展,類似moondream2這樣的小型、高效的AI模型將會在更多領域發揮重要作用。