AI視覺目標定位技術一直面臨精度瓶頸,傳統算法如同“近視眼”,只能粗略框選目標,難以捕捉細節。伊利諾伊理工大學、思科研究院和中佛羅里達大學的研究人員開發了SegVG框架,旨在解決這一難題,為AI賦予“高清視覺”。 SegVG的核心在於像素級細節處理,將邊界框信息轉化為分割信號,如同為AI戴上“高清眼鏡”,使其能夠清晰識別目標的每一個像素。

在AI視覺領域,目標定位一直是個老大難問題。傳統的算法就像個“近視眼”,只能粗略地用“框框”圈出目標,卻看不清裡面的細節。這就好比你跟朋友描述一個人,只說了個大概身高體型,朋友能找到人才怪!

為了解決這個問題,一群來自伊利諾伊理工大學、思科研究院和中佛羅里達大學的大佬們,開發了一套名為SegVG的全新視覺定位框架,號稱要讓AI從此告別“近視眼”!

SegVG的核心秘訣就是:“像素級”細節!傳統的算法只用邊界框信息訓練AI,相當於只給AI看個模糊的影子。而SegVG則是把邊界框信息轉換成分割信號,相當於給AI戴上了“高清眼鏡”,讓AI能看清目標的每一個像素!

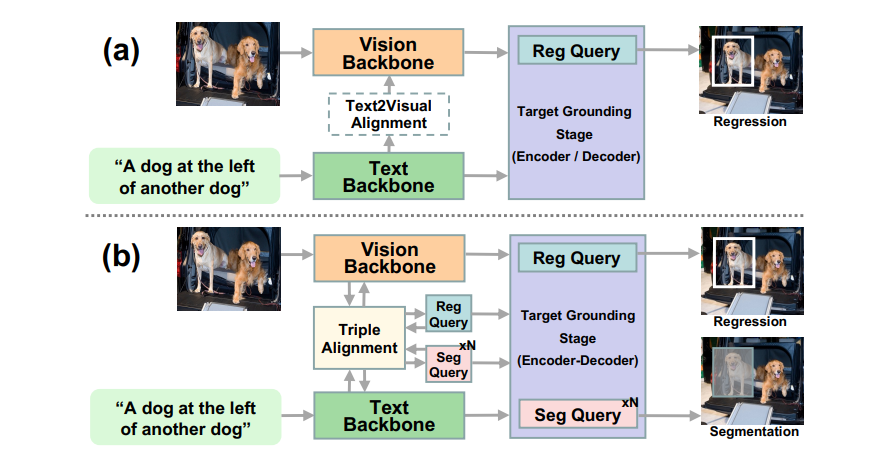

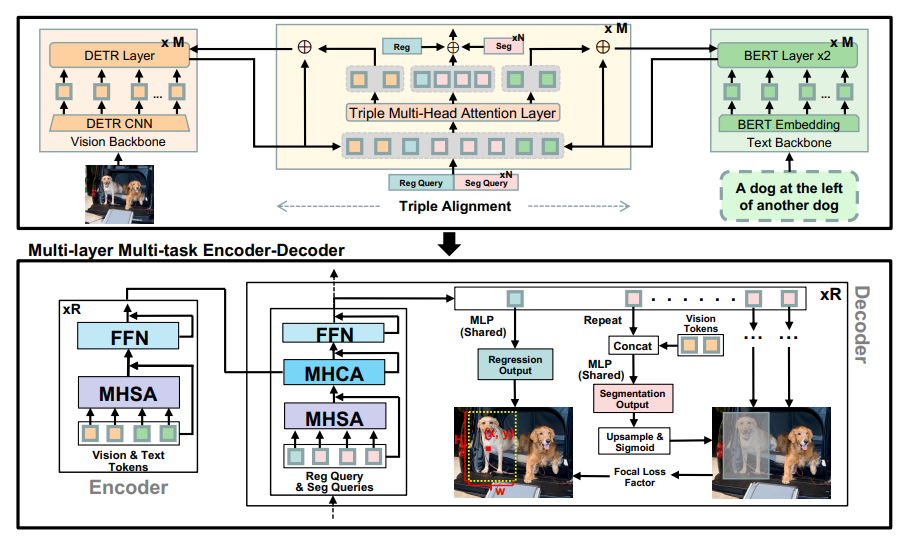

具體來說,SegVG採用了一種“多層多任務編碼器-解碼器”。這個名字聽起來很複雜,其實你可以把它理解成一個超級精密的“顯微鏡”,裡麵包含用於回歸的查詢和多個用於分割的查詢。 簡單來說,就是用不同的“鏡頭”分別進行邊界框回歸和分割任務,反復觀察目標,提取更精細的信息。

更厲害的是,SegVG還引入了“三元對齊模塊”,相當於給AI配備了“翻譯器”,專門解決模型預訓練參數和查詢嵌入之間“語言不通”的問題。 通過三元注意力機制,這個“翻譯器”可以把查詢、文本和視覺特徵“翻譯”到同一個頻道,讓AI更好地理解目標信息。

SegVG的效果到底如何呢?大佬們在五個常用的數據集上做了實驗,結果發現SegVG的表現吊打了一眾傳統算法! 尤其是在RefCOCO+和RefCOCOg這兩個出了名的“難題”數據集上,SegVG更是取得了突破性的成績!

除了精准定位,SegVG還能輸出模型預測的置信度得分。 簡單來說,就是AI會告訴你它對自己的判斷有多大的把握。這在實際應用中非常重要,比如你想用AI來識別醫學影像,如果AI的置信度不高,你就需要人工复核,避免誤診。

SegVG的開源,對於整個AI視覺領域來說都是一個重大利好! 相信未來會有越來越多的開發者和研究人員加入SegVG的陣營,共同推動AI視覺技術的發展。

論文地址:https://arxiv.org/pdf/2407.03200

代碼鏈接:https://github.com/WeitaiKang/SegVG/tree/main

SegVG的出現標誌著AI視覺目標定位技術取得了顯著進步,其高精度、高置信度的定位能力以及開源特性,將為諸多領域帶來革新,值得期待其未來的應用和發展。